Site Web officiel www.binance.com/ZH-CN :Entrez le site officiel ☜☜

Application: ☞☞Official App Download☜☜

Dans le domaine de l'intelligence artificielle, Moore Thread a une fois de plus dirigée par l'innovation technologique et a annoncé deux principaux cadres d'IA: MT-mégatronlm open source et MT-transformère. Cette décision majeure injecte non seulement une nouvelle vitalité dans l'infrastructure informatique domestique, mais fournit également un puissant support d'outils pour les développeurs d'IA à travers le monde. En intégrant profondément les stratégies de formation hybride FP8 et la bibliothèque des opérateurs à haute performance, ces deux cadres ont obtenu une formation parallèle hybride et une inférence sur les GPU domestiques à fonction complète, améliorant considérablement l'efficacité et la stabilité de la formation de modèles à grande échelle.

Le cadre MT-MegatronLM est spécialement conçu pour les GPU à fonction complète, prend en charge une formation efficace des modèles de densité, des modèles multimodaux et des modèles MOE (expert hybride), répondant aux divers besoins de formation actuels dans le domaine de l'IA. MT-transformère se concentre sur l'optimisation de la formation et de l'inférence des modèles de transformateurs. Grâce à la fusion de l'opérateur et aux stratégies d'accélération parallèle et à d'autres technologies, il libère efficacement le potentiel de calcul à haute densité des threads Moore, ce qui améliore considérablement l'efficacité de l'opérateur lié à la mémoire.

Les percées technologiques de ces deux cadres se reflètent principalement dans la collaboration approfondie de l'adaptation matérielle et de l'innovation d'algorithme. Premièrement, ils prennent en charge la formation parallèle mixte de plusieurs types de modèles, qui peuvent gérer de manière flexible avec des scénarios informatiques complexes de différentes architectures de modèles; Deuxièmement, combiné avec la stratégie de formation de précision hybride FP8 nativement soutenue par Moore Thread GPU, améliore efficacement l'efficacité de la formation; Troisièmement, grâce à l'intégration profonde de la bibliothèque d'opérateurs haute performance MUDNN et de la bibliothèque de communication MCCL, les frais généraux de communication des tâches et des cartes multiples de calcul sont systématiquement optimisées; Dans le même temps, combiné avec la bibliothèque Simumax open source, la recherche de stratégie parallèle peut être effectuée automatiquement et les performances de formation parallèles peuvent être maximisées pour différents modèles et environnements d'accélération; De plus, le mécanisme de récupération des exceptions de rembobinage intégré du cadre peut revenir automatiquement au récent nœud stable pour la formation, améliorant considérablement la stabilité de la formation à grande échelle; Enfin, les deux cadres sont compatibles avec l'écosystème GPU grand public, qui garantit non seulement la migration fluide de l'écosystème existant, mais fournit également un support sous-jacent aux développeurs pour construire leur propre pile de technologies AI.

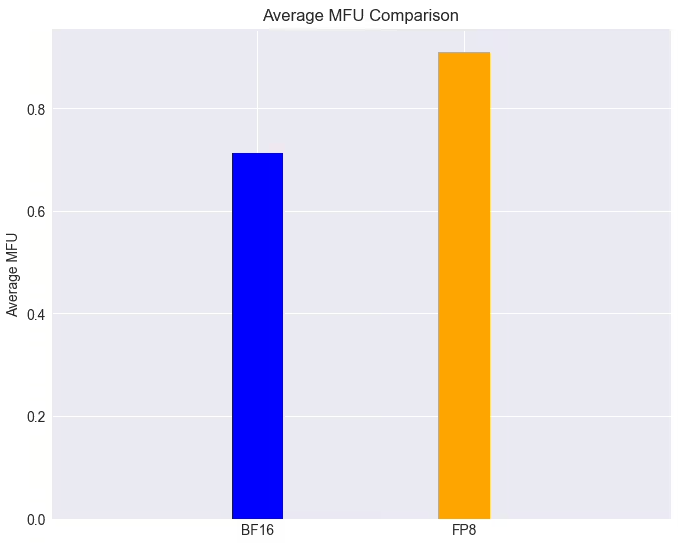

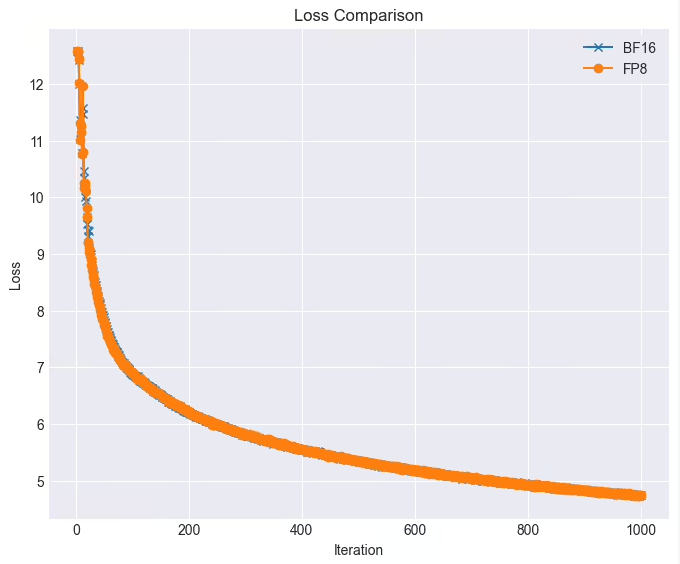

Dans les applications pratiques, les performances de ces deux cadres sont impressionnantes. Sur un cluster GPU complet, la tâche de formation du modèle LLAMA38B peut atteindre plus de 90% avec la technologie FP8 lorsque la perte est presque sans perte, ce qui est 28% plus élevé que la vitesse de formation d'origine. De plus, les fils de Moore ont été profondément intégrés et open source pour soutenir efficacement l'algorithme parallèle Deepseek Dualpipe. Une fois que MT-Dualpipe est entièrement connecté au cadre MT-Megatron et au cadre de transformateur MT, il a réalisé avec succès la reproduction complète du processus de formation Deepseek V3, soutenant MLA, MTP et une variété de stratégies d'équilibre expertes. Grâce à une variété de technologies de fusion des opérateurs de transformateurs, ces cadres ont considérablement amélioré l'utilisation de la bande passante de la mémoire, atténué efficacement le goulot d'étranglement lié à la mémoire et publié en outre le potentiel matériel des GPU domestiques.

Le threading de Moore a déclaré qu'il continuerait d'optimiser ces deux cadres et prévoit d'introduire une série de nouvelles fonctions: y compris la stratégie parallèle à double tuyau / zérobubble pour réduire davantage le taux de bulles et améliorer l'efficacité de la formation parallèle; une variété de stratégies d'optimisation FP8 originales pour améliorer les performances et la stabilité de la formation; Stratégies de point de contrôle asynchrones pour améliorer la tolérance et l'efficacité des défauts pendant la formation; Des stratégies de recomputation optimisées pour réduire les frais généraux de calcul et de mémoire et améliorer la vitesse de formation; Algorithmes de formation originaux tolérants aux pannes pour améliorer la tolérance aux défauts pendant la formation; et intégrer les bibliothèques Moore Thread Flashmla et DeepGEMM pour publier davantage la puissance de calcul et la puissance de calcul FP8 des GPU de Thread Moore pour améliorer de manière approfondie les performances et l'efficacité de l'informatique.

Cette série de percées technologiques et de mesures open source démontre non seulement la force de Moore Thread dans le domaine de la puissance de calcul de l'IA, mais ouvre également de nouvelles possibilités pour le développement d'une infrastructure d'IA domestique. Attendons et voyons plus de percées que cela apporte dans le domaine de la formation des modèles d'IA.