Auf dem Gebiet der künstlichen Intelligenz leitete Moore erneut technologische Innovation und kündigte zwei große KI-Frameworks an: Open Source Mt-Megatronlm und MT-Transformeengine. Dieser große Schritt verleiht nicht nur neue Vitalität in die Inlands -Computerinfrastruktur, sondern bietet auch leistungsstarke Tool -Unterstützung für KI -Entwickler auf der ganzen Welt. Durch die tiefgreifende Integration von FP8-Hybrid-Trainingsstrategien und Hochleistungsbetreiberbibliothek haben diese beiden Rahmenbedingungen hybride parallele Schulungen und Schlussfolgerungen für GPUs inländischer Vollfunktionen erreicht, was die Effizienz und Stabilität des großberechtigten Modelltrainings erheblich verbessert.

Das MT-Megatronlm-Framework ist speziell für GPUs mit voll funktionsfähigem GPUs konzipiert, unterstützt effizientes Training von Dichtemodellen, multimodalen Modellen und MOE (Hybrid Expert) und entspricht den aktuellen vielfältigen Trainingsbedürfnissen im KI-Feld. MT-TransformerenEngine konzentriert sich auf die Trainings- und Inferenzoptimierung von Transformatormodellen. Durch die Strategien für die Fusion und die parallele Beschleunigungsstrategien und andere Technologien der Bediener fördert es effektiv das Potenzial des Hochdichte-Computing von Moore-Threads, was die Effizienz des von Speicher gebundenen Operators erheblich verbessert.

Die technologischen Durchbrüche dieser beiden Rahmenbedingungen spiegeln sich hauptsächlich in der tiefen Zusammenarbeit der Hardwareanpassung und der Algorithmus -Innovation wider. Erstens unterstützen sie gemischtes parallele Training mehrerer Modelle, die flexibel mit komplexen Computerszenarien verschiedener Modellarchitekturen umgehen können. Zweitens verbessert die von Moore Thread GPU nativ unterstützte FP8 -Hybrid -Präzisions -Trainingsstrategie die Trainingseffizienz effektiv. Drittens wird durch die tiefe Integration der Hochleistungs-Operator-Bibliothek MUDNN und der Kommunikationsbibliothek MCCL der Kommunikationsaufwand von Computerintensivaufgaben und mehreren Karten systematisch optimiert. Gleichzeitig kann in Kombination mit der Open-Source-Simumax-Bibliothek die parallele Strategie-Suche automatisch durchgeführt werden und die parallele Schulungsleistung für verschiedene Modelle und Beschleunigungsumgebungen maximiert werden. Darüber hinaus kann der integrierte Mechanismus für den integrierten Rückspulen-Ausnahmegebiet des Frameworks automatisch auf den jüngsten stabilen Knoten für das Training zurückkehren und die Stabilität des groß angelegten Trainings erheblich verbessern. Schließlich sind die beiden Frameworks mit dem Mainstream -GPU -Ökosystem kompatibel, das nicht nur die reibungslose Migration des vorhandenen Ökosystems gewährleistet, sondern auch den Entwicklern zugrunde liegende Unterstützung für den Bau eines eigenen KI -Technologiestapels bietet.

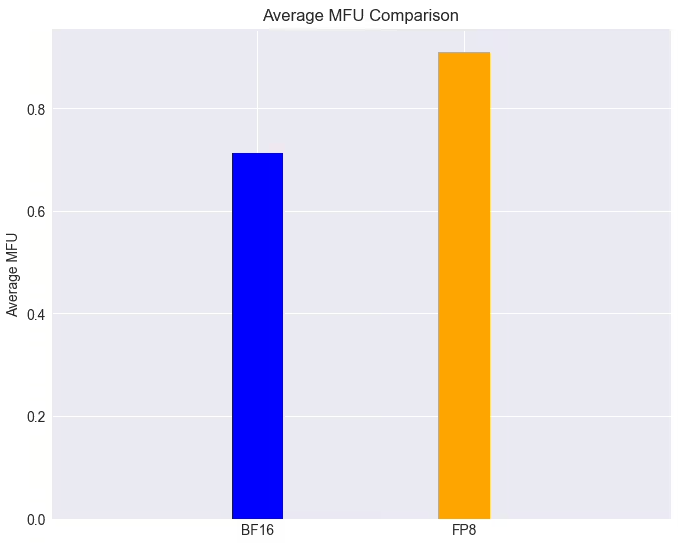

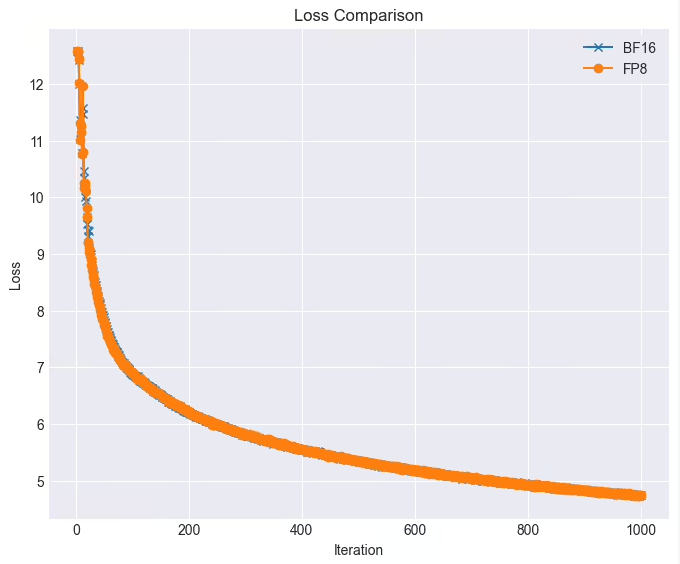

In praktischen Anwendungen ist die Leistung dieser beiden Frameworks beeindruckend. Bei einem GPU-Cluster mit vollem Funktionieren kann die Trainingsaufgabe des LLAMA38B-Modells mit der FP8-Technologie mehr als 90% erreichen, wenn der Verlust nahezu verlustlos ist, was 28% höher ist als die ursprüngliche Trainingsgeschwindigkeit. Darüber hinaus wurden Moore -Threads tief integriert und Open Source, um den Deepseek -Algorithmus -Dualpipe effizient zu unterstützen. Nachdem MT-DualPipe vollständig mit dem MT-Megatron-Framework und dem MT-TransformerenEngine-Framework verbunden ist, hat es die vollständige Reproduktion des Deepseek V3-Schulungsprozesses erfolgreich erkannt, das MLA, MTP und eine Vielzahl von Experten-Balance-Strategien unterstützt. Durch eine Vielzahl von Fusionstechnologien des Transformator -Operators haben diese Frameworks die Nutzung der Speicherbandbreite erheblich verbessert, den Speichergrenck effektiv lindert und das Hardwarepotential des inländischen GPUs weiter veröffentlicht.

Moore Threading sagte, es werde diese beiden Frameworks weiterhin optimieren und plant, eine Reihe neuer Funktionen einzuführen: einschließlich der parallelen Strategie mit zwei Rohren/Zerobubble, um die Blasenrate weiter zu senken und die parallele Trainingseffizienz zu verbessern. Eine Vielzahl ursprünglicher FP8 -Optimierungsstrategien zur Verbesserung der Trainingsleistung und -stabilität; Asynchrone Checkpoint -Strategien zur Verbesserung der Fehlertoleranz und Effizienz während des Trainings; optimierte Neuberechnungstrategien zur Reduzierung des Computer- und Speicheraufwands und zur Verbesserung der Trainingsgeschwindigkeit; ursprüngliche fehlertolerante Trainingsalgorithmen zur Verbesserung der Fehlertoleranz während des Trainings; und Integration von Moore -Thread -FlashMLA- und DeepGemm -Bibliotheken, um die Rechenleistung und die FP8 -Rechenleistung von Moore -Thread -GPUs weiter zu veröffentlichen, um die Rechenleistung und -effizienz umfassend zu verbessern.

Diese Reihe von technologischen Durchbrüchen und Open -Source -Maßnahmen zeigt nicht nur die Stärke von Moore Thread auf dem Gebiet der AI -Rechenleistung, sondern eröffnet auch neue Möglichkeiten für die Entwicklung der inländischen AI -Infrastruktur. Lassen Sie uns warten und sehen Sie weitere Durchbrüche, die es im Bereich des KI -Modelltrainings bringt.