Официальный веб-сайт www.binance.com/zh-cn :введите официальный веб-сайт ☜☜

Приложение: ☞☞official App Download☜☜

В области искусственного интеллекта Moore Thread вновь привела технологические инновации и объявила о двух основных структурах ИИ: с открытым исходным кодом MT-Megatronlm и MT-TransformerEngine. Этот основной шаг не только внедряет новую жизнеспособность в инфраструктуру домашних компьютеров, но также обеспечивает мощную поддержку инструментов для разработчиков ИИ по всему миру. Благодаря глубокой интеграции гибридных стратегий обучения FP8 и библиотеки высокопроизводительных операторов, эти две рамки достигли гибридных параллельных обучения и вывода по внутренним полнофункциональным графическим процессорам, что значительно повысило эффективность и стабильность крупномасштабной модели.

Структура MT-Megatronlm специально разработана для полнофункциональных графических процессоров, поддерживает эффективную подготовку моделей плотности, мультимодальные модели и модели MOE (Hybrid Expert), отвечающие текущим различным потребностям в обучении в области искусственного интеллекта. MT-TransformerEngine фокусируется на оптимизации обучения и выводов моделей трансформаторов. С помощью стратегий слияния оператора и параллельного ускорения и других технологий, он эффективно высвобождает потенциал вычислений высокой плотности потоков Moore, что значительно повышает эффективность оператора, связанного с памятью.

Технологические прорывы этих двух структур в основном отражаются в глубоком сотрудничестве аппаратной адаптации и инноваций алгоритма. Во -первых, они поддерживают смешанную параллельную подготовку нескольких типов моделей, которые могут гибко иметь дело со сложными вычислительными сценариями различных модельных архитектур; Во -вторых, в сочетании со стратегией обучения гибридной точности FP8, написываемой графическим процессором Moore Thread, эффективно повышает эффективность обучения; В-третьих, благодаря глубокой интеграции библиотеки операторов высокопроизводительных операторов Mudnn и библиотеки связи MCCL, накладные расходы на вычислительные задачи и несколько карт систематически оптимизированы; В то же время, в сочетании с библиотекой Simumax с открытым исходным кодом, поиск параллельного стратегии может быть автоматически проведен, и параллельная производительность обучения может быть максимизирована для различных моделей и среды ускорения; Кроме того, встроенный механизм восстановления исключений Framework может автоматически возвращаться к недавнему стабильному узлу для обучения, что значительно улучшит стабильность крупномасштабных тренировок; Наконец, две рамки совместимы с основной экосистемой GPU, которая не только обеспечивает плавную миграцию существующей экосистемы, но также обеспечивает базовую поддержку разработчикам для создания собственного стека технологий ИИ.

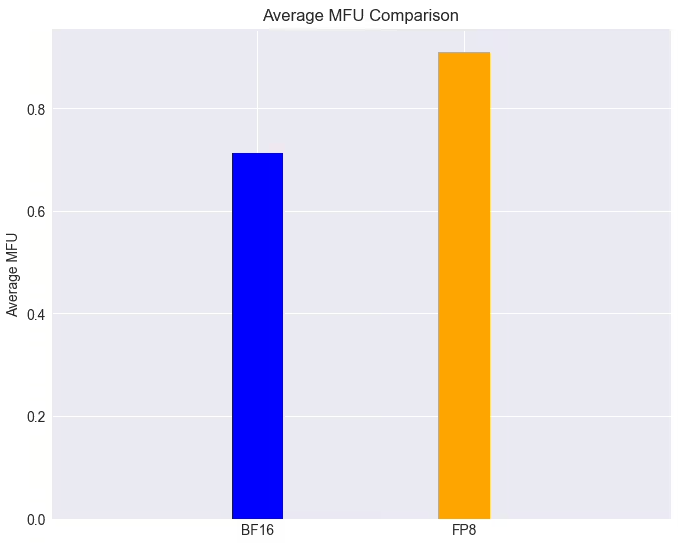

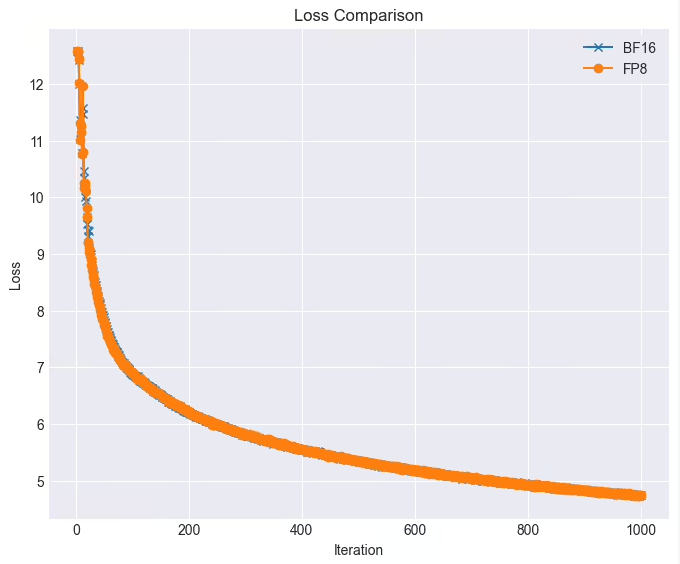

В практических приложениях производительность этих двух структур впечатляет. В полнофункциональном кластере графических процессоров задача обучения модели Llama38B может достигать более 90% с технологией FP8, когда потеря практически без потерь, что на 28% выше, чем исходная скорость обучения. Кроме того, потоки Мура были глубоко интегрированы и с открытым исходным кодом, чтобы эффективно поддерживать двойную алгоритм DeepSeek Parallel DualPipe. После того, как MT-DualPipe полностью подключена к структуре MT-Megatron и структуре MT-трансформации, она успешно реализовала полное воспроизведение процесса обучения DeepSeek V3, поддерживающего MLA, MTP и различные стратегии экспертного баланса. Благодаря различным технологиям Fusion Technologies оператора трансформатора эти рамки значительно улучшили использование полосы пропускания памяти, эффективно облегчили узкое место, связанное с памятью, и дополнительно выпустили аппаратный потенциал домашних графических процессоров.

Moore Threading заявила, что будет продолжать оптимизировать эти две рамки и планы по внедрению ряда новых функций: включая двойную параллельную стратегию с двойной трубкой/нулевой нулевой/нулевой раковиной для дальнейшего снижения скорости пузырьков и повышения эффективности параллельной тренировки; различные оригинальные стратегии оптимизации FP8 для повышения производительности и стабильности обучения; Асинхронные стратегии контрольной точки для повышения устойчивости к разломам и эффективности во время обучения; Оптимизированные стратегии рециркуляции для снижения вычислительных средств и накладных расходов памяти и улучшения скорости обучения; Оригинальные алгоритмы обучения, устойчивые к неисправности для повышения устойчивости к разлому во время тренировки; и интеграция потока MOORE FlashMLA и библиотеки DeepGemm для дальнейшего выпуска вычислительной мощности и вычислительной мощности FP8 потока MOORE для полного улучшения вычислительных характеристик и эффективности.

Эта серия технологических прорывов и показателей с открытым исходным кодом не только демонстрирует силу Moore Thread в области вычислительной мощности ИИ, но и открывает новые возможности для развития внутренней инфраструктуры ИИ. Давайте подождем и посмотрим, как больше прорывов это приведет в сферу обучения модели искусственного интеллекта.