No campo da inteligência artificial, a Moore Thread mais uma vez liderou a inovação tecnológica e anunciou duas grandes estruturas de IA: Open Source Mt-Megatronlm e Mt-TransformEngine. Esse grande movimento não apenas injeta nova vitalidade na infraestrutura de computação doméstica, mas também fornece suporte poderoso para os desenvolvedores de IA em todo o mundo. Ao integrar profundamente as estratégias de treinamento híbrido do FP8 e a biblioteca de operadores de alto desempenho, essas duas estruturas alcançaram treinamento paralelo híbrido e inferência nas GPUs de função total doméstica, melhorando significativamente a eficiência e a estabilidade do treinamento de modelos em larga escala.

A estrutura Mt-Megatronlm é especialmente projetada para GPUs de função completa, suporta treinamento eficiente de modelos de densidade, modelos multimodais e modelos MOE (especialista em híbridos), atendendo às atuais necessidades de treinamento diversas no campo da IA. MT-TransformEngine concentra-se no treinamento e na otimização de inferência dos modelos de transformadores. Através da fusão do operador e das estratégias de aceleração paralela e outras tecnologias, ele libera efetivamente o potencial da computação de alta densidade de threads moore, o que melhora significativamente a eficiência do operador ligado à memória.

Os avanços tecnológicos dessas duas estruturas são refletidos principalmente na profunda colaboração da adaptação de hardware e inovação de algoritmo. Primeiro, eles suportam treinamento paralelo misto de vários tipos de modelos, que podem lidar flexivelmente com cenários complexos de computação de diferentes arquiteturas de modelos; Segundo, combinado com a estratégia de treinamento de precisão híbrida FP8, apoiada nativamente pela Moore Thread GPU, melhorará efetivamente a eficiência do treinamento; Terceiro, através da profunda integração da biblioteca de operadores de alto desempenho MUDNN e da biblioteca de comunicação MCCL, a sobrecarga de comunicação de tarefas intensivas em computação e vários cartões é sistematicamente otimizada; Ao mesmo tempo, combinado com a biblioteca SIMUMAX de código aberto, a pesquisa de estratégia paralela pode ser conduzida automaticamente e o desempenho do treinamento paralelo pode ser maximizado para diferentes modelos e ambientes de aceleração; Além disso, o mecanismo de recuperação de exceção de rebobinação interno da estrutura pode recuar automaticamente para o nó estável recente para treinamento, melhorando bastante a estabilidade do treinamento em larga escala; Finalmente, as duas estruturas são compatíveis com o ecossistema GPU convencional, que não apenas garante a migração suave do ecossistema existente, mas também fornece suporte subjacente aos desenvolvedores para construir sua própria pilha de tecnologia de IA.

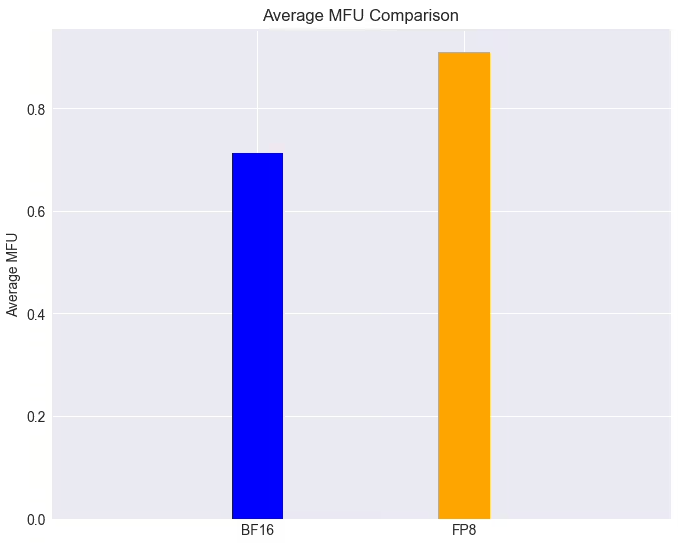

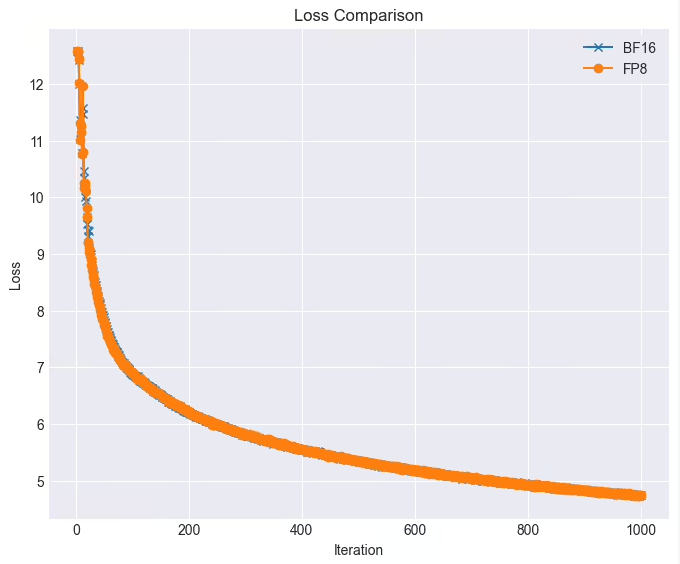

Em aplicações práticas, o desempenho dessas duas estruturas é impressionante. Em um cluster de GPU de função completa, a tarefa de treinamento do modelo LLAMA38B pode atingir mais de 90% com a tecnologia FP8 quando a perda é quase sem perdas, o que é 28% maior que a velocidade de treinamento original. Além disso, os threads Moore foram profundamente integrados e de código aberto para suportar com eficiência o algoritmo paralelo Deepseek. Depois que o MT-Dualpipe está totalmente conectado à estrutura do MT-Megatron e à estrutura do MT-TransformEngine, ele percebeu com sucesso a reprodução completa do processo de treinamento do DeepSeek V3, apoiando o MLA, MTP e uma variedade de estratégias de equilíbrio especialistas. Através de uma variedade de tecnologias de fusão do operador de transformador, essas estruturas melhoraram significativamente a utilização da largura de banda de memória, aliviaram efetivamente o gargalo ligado à memória e liberaram ainda mais o potencial de hardware das GPUs domésticas.

A Moore Threading disse que continuará otimizando essas duas estruturas e planeja introduzir uma série de novas funções: incluindo a estratégia paralela dupla de tubos/zerobubble para reduzir ainda mais a taxa de bolhas e melhorar a eficiência do treinamento paralelo; uma variedade de estratégias originais de otimização do FP8 para melhorar o desempenho e a estabilidade do treinamento; Estratégias de ponto de verificação assíncronas para melhorar a tolerância e a eficiência de falhas durante o treinamento; Estratégias de recomputação otimizadas para reduzir a computação e a sobrecarga da memória e melhorar a velocidade de treinamento; Algoritmos originais de treinamento tolerante a falhas para aumentar a tolerância a falhas durante o treinamento; e integrar as bibliotecas Moore Thread FlashMla e DeepGEMM para liberar ainda mais a potência de computação e o poder de computação FP8 das GPUs de Thread Moore para melhorar de maneira abrangente o desempenho e a eficiência da computação.

Esta série de avanços tecnológicos e medidas de código aberto não apenas demonstra a força de Moore Thread no campo do poder de computação de IA, mas também abre novas possibilidades para o desenvolvimento da infraestrutura doméstica de IA. Vamos esperar e ver mais avanços que traz para o campo de treinamento do modelo de IA.