Situs web resmi www.binance.com/zh-cn :Masukkan situs web resmi ☜☜

Aplikasi: ☞☞ Unduh Aplikasi Resmi☜☜

Di bidang kecerdasan buatan, Moore Thread sekali lagi memimpin inovasi teknologi dan mengumumkan dua kerangka kerja AI utama: open source mt-megatronlm dan mt-transformerengine. Langkah besar ini tidak hanya menyuntikkan vitalitas baru ke dalam infrastruktur komputasi domestik, tetapi juga memberikan dukungan alat yang kuat untuk pengembang AI di seluruh dunia. Dengan sangat mengintegrasikan strategi pelatihan hibrida FP8 dan perpustakaan operator kinerja tinggi, kedua kerangka kerja ini telah mencapai pelatihan paralel hibrida dan inferensi pada GPU fungsi penuh domestik, secara signifikan meningkatkan efisiensi dan stabilitas pelatihan model skala besar.

Kerangka kerja MT-MEGATRONLM dirancang khusus untuk GPU fungsi penuh, mendukung pelatihan yang efisien dari model kepadatan, model multimodal dan model MOE (ahli hibrida), memenuhi beragam kebutuhan pelatihan saat ini di bidang AI. MT-TransformerEngine berfokus pada pelatihan dan inferensi optimalisasi model transformator. Melalui fusi operator dan strategi akselerasi paralel dan teknologi lainnya, secara efektif melepaskan potensi komputasi kepadatan tinggi dari utas Moore, yang secara signifikan meningkatkan efisiensi operator terikat memori.

Terobosan teknologi dari dua kerangka kerja ini terutama tercermin dalam kolaborasi mendalam adaptasi perangkat keras dan inovasi algoritma. Pertama, mereka mendukung pelatihan paralel campuran dari berbagai jenis model, yang secara fleksibel dapat menangani skenario komputasi kompleks dari berbagai arsitektur model; Kedua, dikombinasikan dengan strategi pelatihan presisi hibrida FP8 yang didukung secara asli oleh Moore Thread GPU, secara efektif meningkatkan efisiensi pelatihan; Ketiga, melalui integrasi mendalam dari perpustakaan operator berkinerja tinggi MUDNN dan Perpustakaan Komunikasi MCCL, overhead komunikasi tugas intensif komputasi dan banyak kartu dioptimalkan secara sistematis; Pada saat yang sama, dikombinasikan dengan perpustakaan Simumax open-source, pencarian strategi paralel dapat secara otomatis dilakukan dan kinerja pelatihan paralel dapat dimaksimalkan untuk berbagai model dan lingkungan percepatan; Selain itu, mekanisme pemulihan pengecualian rewind rewind kerangka kerja dapat secara otomatis berputar kembali ke simpul stabil baru-baru ini untuk pelatihan, sangat meningkatkan stabilitas pelatihan skala besar; Akhirnya, kedua kerangka kerja ini kompatibel dengan ekosistem GPU utama, yang tidak hanya memastikan lancar migrasi ekosistem yang ada, tetapi juga memberikan dukungan yang mendasari pengembang untuk membangun tumpukan teknologi AI mereka sendiri.

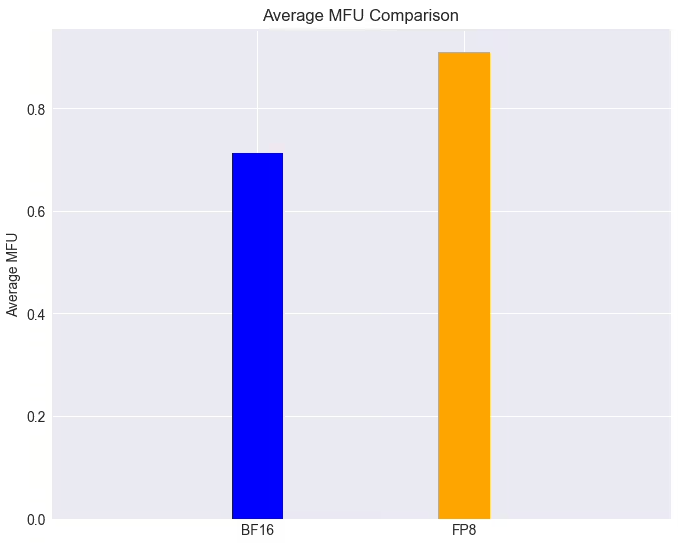

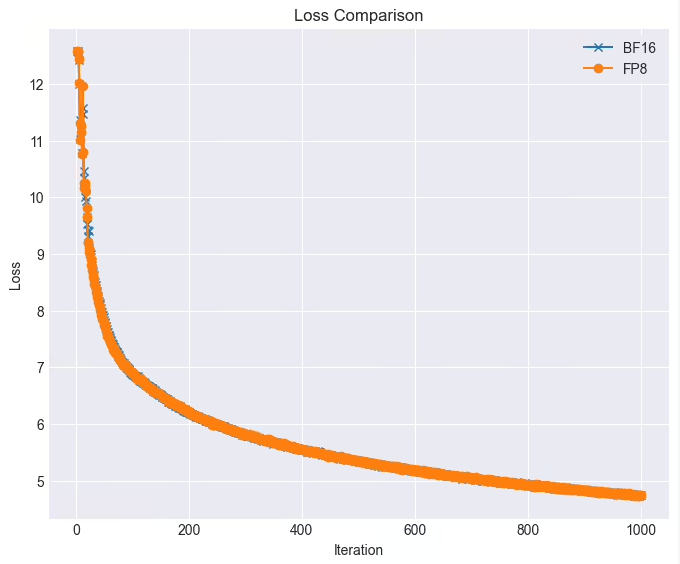

Dalam aplikasi praktis, kinerja kedua kerangka kerja ini sangat mengesankan. Pada kluster GPU fungsi penuh, tugas pelatihan model LLAMA38B dapat mencapai lebih dari 90% dengan teknologi FP8 ketika kerugiannya hampir lossless, yang 28% lebih tinggi dari kecepatan pelatihan asli. Selain itu, utas Moore telah sangat terintegrasi dan open source untuk mendukung dualpipe algoritma paralel Deepseek secara efisien. Setelah MT-Dualpipe sepenuhnya terhubung ke kerangka kerja MT-MEGATRON dan MT-TransformerEngine, telah berhasil mewujudkan reproduksi lengkap dari proses pelatihan Deepseek V3, mendukung MLA, MTP dan berbagai strategi keseimbangan ahli. Melalui berbagai teknologi fusi operator transformator, kerangka kerja ini telah secara signifikan meningkatkan pemanfaatan bandwidth memori, secara efektif mengurangi kemacetan memori yang terikat, dan lebih lanjut merilis potensi perangkat keras GPU domestik.

Moore Threading mengatakan akan terus mengoptimalkan dua kerangka kerja ini dan berencana untuk memperkenalkan serangkaian fungsi baru: termasuk strategi paralel pipa/zerobubble ganda untuk lebih mengurangi laju gelembung dan meningkatkan efisiensi pelatihan paralel; berbagai strategi optimasi FP8 asli untuk meningkatkan kinerja dan stabilitas pelatihan; strategi pos pemeriksaan asinkron untuk meningkatkan toleransi dan efisiensi kesalahan selama pelatihan; strategi rekomputasi yang dioptimalkan untuk mengurangi komputasi dan overhead memori dan meningkatkan kecepatan pelatihan; Algoritma pelatihan toleran kesalahan asli untuk meningkatkan toleransi kesalahan selama pelatihan; dan mengintegrasikan moore thread flashmla dan pustaka DeepGemM untuk lebih lanjut merilis daya komputasi dan daya komputasi fp8 dari moore thread gpus untuk secara komprehensif meningkatkan kinerja dan efisiensi komputasi.

Serangkaian terobosan teknologi dan langkah -langkah open source ini tidak hanya menunjukkan kekuatan Moore Thread di bidang daya komputasi AI, tetapi juga membuka kemungkinan baru untuk pengembangan infrastruktur AI domestik. Mari kita tunggu dan lihat lebih banyak terobosan yang dibawanya di bidang pelatihan model AI.