في مجال الذكاء الاصطناعي ، قاد Moore Thread مرة أخرى الابتكار التكنولوجي وأعلن عن إطارين رئيسيين من الذكاء الاصطناعي: المصدر المفتوح MT-megatronlm و MT-transformerEngine. هذه الخطوة الرئيسية لا تضخ الحيوية الجديدة فقط في البنية التحتية للحوسبة المحلية ، ولكنها توفر أيضًا دعمًا قويًا للأدوات لمطوري الذكاء الاصطناعي في جميع أنحاء العالم. من خلال دمج استراتيجيات التدريب الهجينة FP8 بعمق ومكتبة المشغل عالي الأداء ، حقق هذان الأطران تدريبًا هجينًا متوازيًا واستدلالًا على وحدات معالجة الرسومات المحلية الكاملة ، مما أدى إلى تحسين كفاءة واستقرار التدريب على نطاق واسع.

تم تصميم إطار عمل MT-MeGatronLM خصيصًا لاتصالات وحدات معالجة الرسومات كاملة الوظائف ، ويدعم تدريبًا فعالًا لنماذج الكثافة والنماذج متعددة الوسائط ونماذج MOE (الخبراء المختلط) ، وتلبية احتياجات التدريب الحالية المتنوعة في مجال الذكاء الاصطناعي. يركز MT-TransformerEngine على التدريب والاستدلال على تحسين نماذج المحولات. من خلال اندماج المشغل واستراتيجيات التسارع المتوازي وغيرها من التقنيات ، فإنه يطلق بشكل فعال إمكانات الحوسبة عالية الكثافة لمروح مور ، مما يحسن بشكل كبير من كفاءة المشغل المربوطة بالذاكرة.

تنعكس الاختراقات التكنولوجية لهذين الإطارين بشكل أساسي في التعاون العميق في تكيف الأجهزة والابتكار الخوارزمية. أولاً ، يدعمون التدريب المتوازي المختلط لأنواع متعددة من النماذج ، والتي يمكن أن تتعامل بمرونة مع سيناريوهات الحوسبة المعقدة من بنيات نموذجية مختلفة ؛ ثانياً ، إلى جانب استراتيجية التدريب الدقيقة FP8 Hybrid Precision التي تدعمها GPU Thread Thread ، تعمل بشكل فعال على تحسين كفاءة التدريب ؛ ثالثًا ، من خلال التكامل العميق لمكتبة المشغل عالية الأداء Mudnn ومكتبة الاتصالات MCCL ، يتم تحسين النفقات العامة للاتصالات في المهام المكثفة للحوسبة وبطاقات متعددة بشكل منهجي ؛ في الوقت نفسه ، إلى جانب مكتبة Simumax مفتوحة المصدر ، يمكن إجراء البحث عن الإستراتيجية المتوازية تلقائيًا ويمكن تعظيم أداء التدريب المتوازي في نماذج مختلفة وبيئات التسارع ؛ بالإضافة إلى ذلك ، يمكن لآلية الاسترداد المدمجة للاستثناء في إطار العمل تلقائيًا التراجع إلى العقدة المستقرة الحديثة للتدريب ، مما يؤدي إلى تحسين استقرار التدريب على نطاق واسع ؛ أخيرًا ، يتوافق الإطاران مع النظام الإيكولوجي في GPU السائد ، والذي لا يضمن فقط الترحيل السلس للنظام الإيكولوجي الحالي ، ولكنه يوفر أيضًا دعمًا أساسيًا للمطورين لبناء مكدس تقنية الذكاء الاصطناعي الخاص بهم.

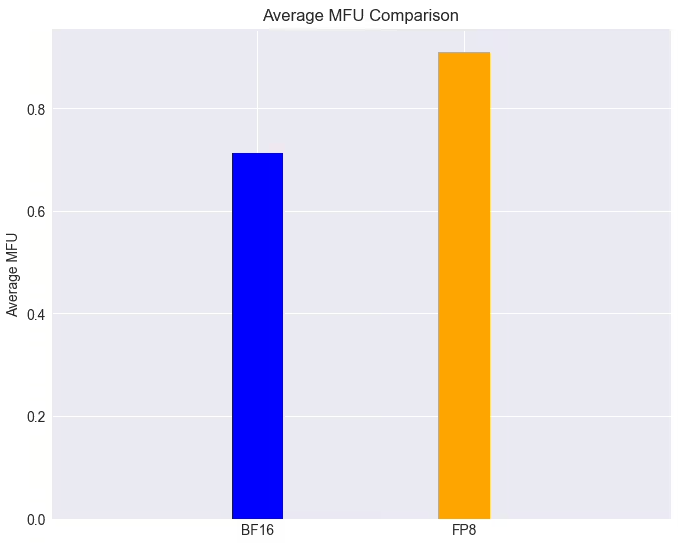

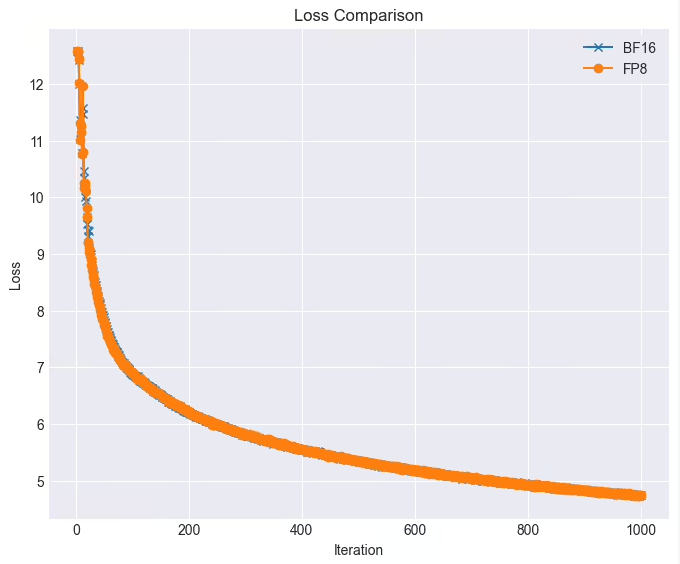

في التطبيقات العملية ، يكون أداء هذين الإطارين مثيرًا للإعجاب. على مجموعة GPU كاملة الوظائف ، يمكن أن تصل مهمة التدريب في نموذج LLAMA38B إلى أكثر من 90 ٪ مع تقنية FP8 عندما تكون الخسارة بلا خسارة تقريبًا ، وهي أعلى بنسبة 28 ٪ من سرعة التدريب الأصلية. بالإضافة إلى ذلك ، كانت مؤشرات ترابط مور متكاملة بشكل عميق ومفتوح المصدر لدعم الخوارزمية المتوازية Deepseek بكفاءة. بعد أن يكون MT-DualPipe متصلًا بالكامل بإطار MT-MeGatron وإطار MT-transformerengine ، فقد أدرك بنجاح التكاثر الكامل لعملية تدريب Deepseek V3 ، ودعم MLA و MTP ومجموعة متنوعة من استراتيجيات توازن الخبراء. من خلال مجموعة متنوعة من تقنيات اندماج مشغل المحولات ، قامت هذه الأطر بتحسين استخدام عرض النطاق الترددي للذاكرة بشكل كبير ، مما أدى إلى تخفيف فعلي عنق الزجاجة المقيد بالذاكرة ، وأصدرت أيضًا إمكانات أجهزة وحدات معالجة الرسومات المحلية.

وقالت مور تروينج إنها ستستمر في تحسين هذين الإطارين وخطط لإدخال سلسلة من الوظائف الجديدة: بما في ذلك استراتيجية موازية للأنابيب المزدوجة/Zerobubble لتقليل معدل الفقاعة وتحسين كفاءة التدريب الموازية ؛ مجموعة متنوعة من استراتيجيات تحسين FP8 الأصلية لتحسين أداء التدريب والاستقرار ؛ استراتيجيات نقطة التفتيش غير المتزامنة لتحسين تحمل الأخطاء والكفاءة أثناء التدريب ؛ استراتيجيات إعادة التثبيت الأمثل لتقليل الحوسبة والذاكرة النفقات العامة وتحسين سرعة التدريب ؛ خوارزميات التدريب الأصلية التي تتحمل الأخطاء لتعزيز التسامح مع الأعطال أثناء التدريب ؛ ودمج مكتبات Moore Thread Flashmla و DeepGemm لزيادة إطلاق قوة الحوسبة وقوة الحوسبة FP8 ل GPUs مؤشر ترابط Moore لتحسين أداء الحوسبة والكفاءة بشكل شامل.

هذه السلسلة من الاختراقات التكنولوجية والتدابير المفتوحة المصدر لا توضح فقط قوة Moore Thread في مجال قوة الحوسبة الذكاء الاصطناعى ، ولكنها تفتح أيضًا إمكانيات جديدة لتطوير البنية التحتية المحلية من الذكاء الاصطناعي. دعنا ننتظر ونرى المزيد من الاختراقات التي يجلبها في مجال التدريب على نموذج الذكاء الاصطناعي.