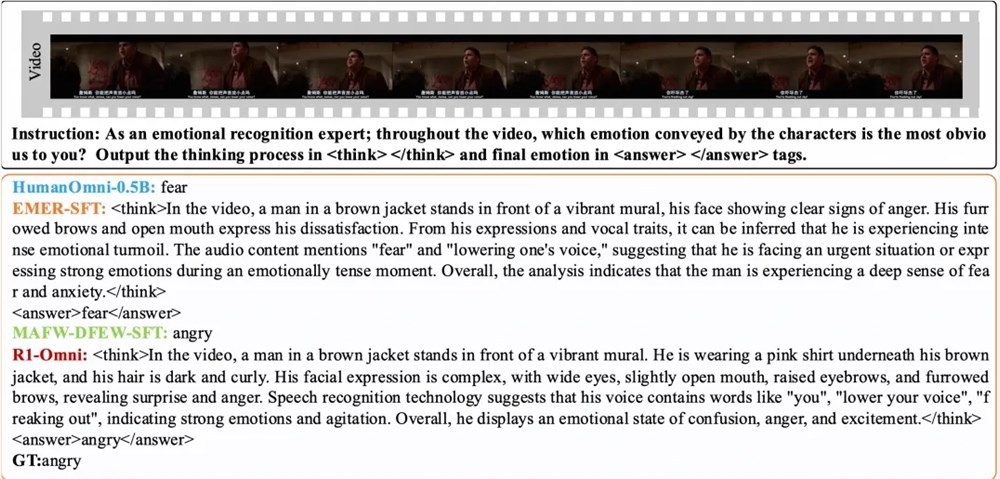

เมื่อวันที่ 11 มีนาคมทีมห้องปฏิบัติการ Tongyi ประกาศแบบจำลองโอเพนซอร์ส R1-OMNI ซึ่งได้นำความก้าวหน้าใหม่มาสู่การพัฒนาแบบจำลองทั้งหมด โมเดล R1-OMNI รวมการเรียนรู้การเสริมแรงเข้ากับวิธีการตรวจสอบความสามารถในการตรวจสอบ (RLVR) โดยมุ่งเน้นที่การปรับปรุงความสามารถในการอนุมานและประสิทธิภาพการวางนัยทั่วไปในงานการจดจำอารมณ์หลายรูปแบบ นวัตกรรมนี้ไม่เพียง แต่ฉีดพลังใหม่เข้าสู่สาขาปัญญาประดิษฐ์ แต่ยังให้การสนับสนุนทางเทคนิคที่สำคัญสำหรับการวิจัยหลายรูปแบบในอนาคต

กระบวนการฝึกอบรมของ R1-OMNI แบ่งออกเป็นสองขั้นตอนสำคัญ ในช่วงเริ่มต้นเย็นทีมใช้ชุดข้อมูลรวมที่มีข้อมูลวิดีโอ 580 สำหรับการปรับแต่งอย่างละเอียดส่วนใหญ่มาจากชุดข้อมูลการให้เหตุผลด้านอารมณ์หลายรูปแบบที่อธิบายได้ (EMER) และชุดข้อมูล Humanomni จุดประสงค์ของขั้นตอนนี้คือการวางรากฐานสำหรับความสามารถในการใช้เหตุผลของโมเดลและให้แน่ใจว่ามีความสามารถในการรับรู้อารมณ์หลายรูปแบบก่อนเข้าสู่ขั้นตอน RLVR ซึ่งจะช่วยให้มั่นใจถึงความมั่นคงประสิทธิภาพและความมั่นคงของการฝึกอบรมที่ตามมา ผ่านขั้นตอนของการฝึกอบรมแบบจำลองสามารถเข้าใจและประมวลผลข้อมูลหลายรูปแบบในขั้นต้นวางรากฐานที่มั่นคงสำหรับการเพิ่มประสิทธิภาพที่ตามมา

ต่อจากนั้นในขั้นตอน RLVR โมเดลจะได้รับการปรับให้เหมาะสมยิ่งขึ้นผ่านการเรียนรู้การเสริมแรงและกลไกการให้รางวัลที่ตรวจสอบได้ กุญแจสำคัญในขั้นตอนนี้อยู่ในการออกแบบรูปแบบกลยุทธ์และฟังก์ชั่นการให้รางวัล รูปแบบกลยุทธ์มีหน้าที่ในการประมวลผลข้อมูลอินพุตหลายรูปแบบที่ประกอบด้วยเฟรมวิดีโอและสตรีมเสียงสร้างการตอบสนองของผู้สมัครด้วยกระบวนการอนุมานโดยละเอียดแสดงให้เห็นว่าแบบจำลองรวมข้อมูลภาพและการได้ยินเพื่อวาดการคาดการณ์ ฟังก์ชั่นรางวัลได้รับแรงบันดาลใจจาก Deepseek R1 และแบ่งออกเป็นสองส่วน: รางวัลที่แม่นยำและรางวัลรูปแบบซึ่งรวมกันเป็นรางวัลสุดท้าย การออกแบบนี้ไม่เพียง แต่ส่งเสริมให้แบบจำลองสร้างการคาดการณ์ที่ถูกต้อง แต่ยังทำให้มั่นใจได้ว่าเอาต์พุตนั้นมีโครงสร้างและสอดคล้องกับรูปแบบที่ตั้งไว้ล่วงหน้าซึ่งจะเป็นการปรับปรุงประสิทธิภาพโดยรวมของโมเดล

ผลการทดลองแสดงให้เห็นว่า R1-OMNI มีการเพิ่มขึ้นเฉลี่ยมากกว่า 35% เมื่อเทียบกับโมเดลพื้นฐานดั้งเดิมในชุดทดสอบการกระจายเดียวกัน DFEW และ MAFW และเพิ่มขึ้นเฉลี่ยมากกว่า 10% เมื่อเทียบกับโมเดลการปรับจูน (SFT) ในอัตราการเรียกคืนเฉลี่ยที่ไม่ถ่วงน้ำหนัก (UAR) ในชุดทดสอบแบบกระจายที่แตกต่างกัน Ravdess อัตราการเรียกคืนค่าเฉลี่ยถ่วงน้ำหนัก (สงคราม) และ UAR ทั้งคู่เพิ่มขึ้นมากกว่า 13%แสดงให้เห็นถึงความสามารถในการวางนัยทั่วไปที่ยอดเยี่ยม นอกจากนี้ R1-OMNI ยังมีข้อได้เปรียบที่มีความโปร่งใสอย่างมีนัยสำคัญ ด้วยวิธี RLVR บทบาทของข้อมูลเสียงและวิดีโอในแบบจำลองจะชัดเจนและมองเห็นได้ชัดเจนขึ้นและสามารถแสดงให้เห็นถึงบทบาทสำคัญของข้อมูลโมดัลแต่ละครั้งเกี่ยวกับการตัดสินทางอารมณ์ที่เฉพาะเจาะจงซึ่งให้การอ้างอิงที่สำคัญสำหรับการทำความเข้าใจกระบวนการตัดสินใจแบบจำลองและการวิจัยในอนาคต

กระดาษ:

https://arxiv.org/abs/2503.05379

GitHub:

https://github.com/humanmllm/r1-omni

แบบอย่าง:

https://www.modelscope.cn/models/iic/r1-omni-0.5b