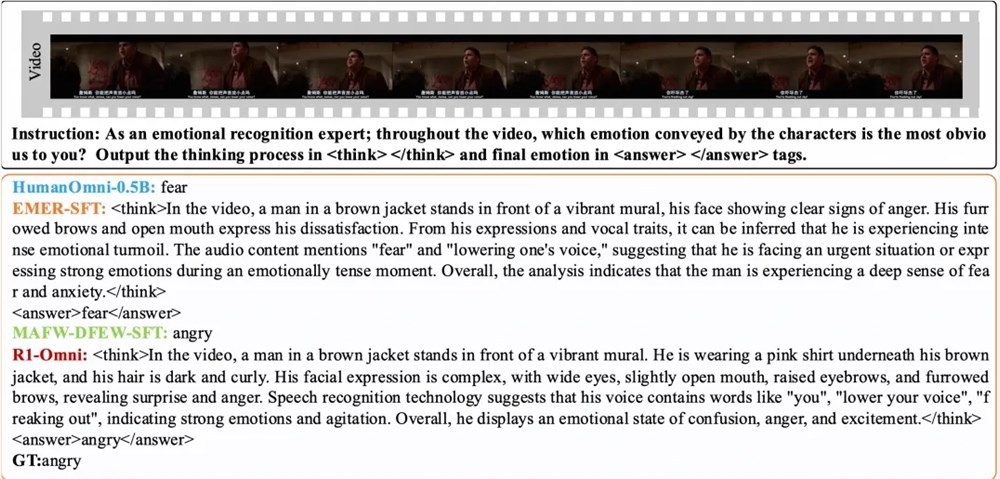

11 марта лабораторная команда Тонгии объявила о модели с открытым исходным кодом R1-Omni, которая принесла новые прорывы для разработки полностью модальных моделей. Модель R1-omni сочетает в себе обучение подкреплению с помощью методов проверки вознаграждения (RLVR), сосредоточив внимание на улучшении возможностей вывода и производительности обобщения в задачах распознавания мультимодальных эмоций. Это инновация не только вводит новую жизнеспособность в область искусственного интеллекта, но также обеспечивает важную техническую поддержку для будущих мультимодальных исследований.

Процесс обучения R1-omni делится на два ключевых этапа. На фазе холодного запуска команда использовала комбинированный набор данных, содержащий 580 видеодантеров для точной настройки, в основном из набора данных об объяснениях мультимодальных рассуждений (EMER) и набора данных Humanomni. Цель этого этапа состоит в том, чтобы заложить основу для способности мышления модели и гарантировать, что она обладает определенной мультимодальной способностью распознавать эмоции, прежде чем вступить в стадию RLVR, тем самым обеспечивая стабильность, эффективность и стабильность последующего обучения. На этом этапе обучения модель может первоначально понимать и обрабатывать мультимодальные данные, закладывая прочную основу для последующей оптимизации.

Впоследствии, на стадии RLVR, модель дополнительно оптимизируется посредством обучения подкреплению и проверки механизма вознаграждения. Ключ к этой стадии заключается в разработке модели стратегии и функции вознаграждения. Стратегическая модель отвечает за обработку мультимодальных входных данных, состоящих из видео кадров и аудио -потоков, генерируя ответы кандидатов с подробными процессами вывода, показывая, как модель интегрирует визуальную и слуховую информацию для рисования прогнозов. Функция вознаграждения вдохновлена DeepSeek R1 и разделена на две части: точное вознаграждение и вознаграждение формата, которые вместе образуют окончательную награду. Этот дизайн не только побуждает модель генерировать правильные прогнозы, но также гарантирует, что выход структурирован и соответствует предустановленным форматам, тем самым улучшая общую производительность модели.

Результаты эксперимента показывают, что R1-OMNI имеет среднее увеличение более чем на 35% по сравнению с исходной базовой моделью на тех же наборах тестов на распределение DFEW и MAFW, а средний увеличение более чем на 10% по сравнению с моделью контролируемой точной настройки (SFT) в невзвеноме средней скорости отзыва (UAR). На различных распределенных тестах Ravdess, его средневзвешенная частота отзыва (война) и UAR увеличились более чем на 13%, демонстрируя превосходные возможности обобщения. Кроме того, R1-OMNI также имеет значительные преимущества прозрачности. С помощью метода RLVR роль аудио и видео информации в модели становится более ясной и более заметной и может четко продемонстрировать ключевую роль каждой модальной информации о конкретных эмоциональных суждениях, предоставляя важную ссылку для понимания процесса принятия моделей принятия решений и будущих исследований.

бумага:

https://arxiv.org/abs/2503.05379

GitHub:

https://github.com/humanmllm/r1-omni

Модель:

https://www.modelscope.cn/models/iic/r1-omni-0.5b