El 11 de marzo, el equipo del Laboratorio Tongyi anunció el modelo R1-OMNI de código abierto, que ha traído nuevos avances al desarrollo de modelos totalmente modales. El modelo R1-AMNI combina el aprendizaje de refuerzo con métodos de recompensa verificable (RLVR), centrándose en mejorar las capacidades de inferencia y el rendimiento de la generalización en las tareas de reconocimiento de emociones multimodales. Esta innovación no solo inyecta una nueva vitalidad en el campo de la inteligencia artificial, sino que también proporciona un importante apoyo técnico para futuras investigaciones multimodales.

El proceso de entrenamiento de R1-AMNI se divide en dos etapas clave. Durante la fase de inicio en frío, el equipo utilizó un conjunto de datos combinado que contenía 580 datos de video para ajustar, principalmente del conjunto de datos de razonamiento de emociones multimodales explicables (EMER) y el conjunto de datos HumanOmni. El propósito de esta etapa es sentar las bases para la capacidad de razonamiento del modelo y garantizar que tenga cierta capacidad de reconocimiento de emociones multimodales antes de ingresar a la etapa RLVR, asegurando así la estabilidad, eficiencia y estabilidad de la capacitación posterior. A través de esta etapa de capacitación, el modelo inicialmente puede comprender y procesar los datos multimodales, estableciendo una base sólida para la optimización posterior.

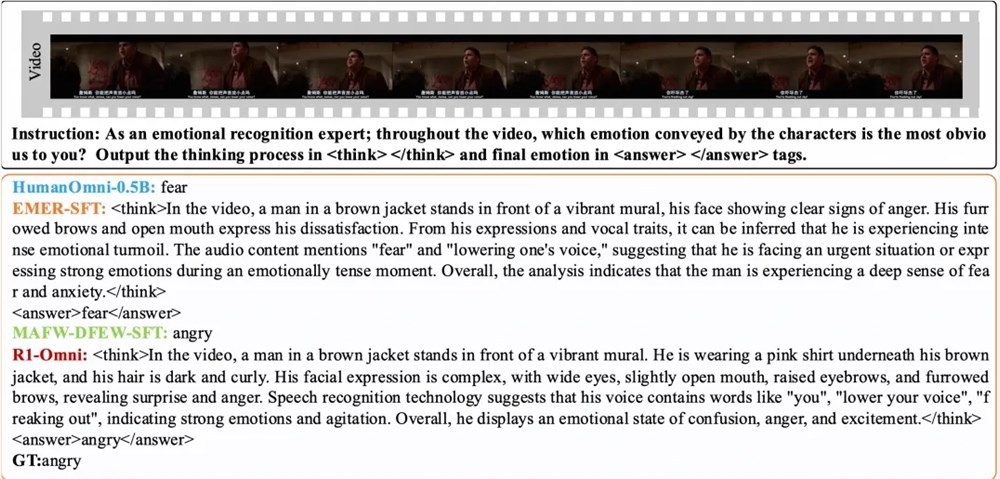

Posteriormente, en la etapa RLVR, el modelo se optimiza aún más a través del aprendizaje de refuerzo y el mecanismo de recompensa verificable. La clave de esta etapa radica en el diseño del modelo de estrategia y la función de recompensa. El modelo de estrategia es responsable del procesamiento de datos de entrada multimodal compuestos de marcos de video y transmisiones de audio, generando respuestas candidatas con procesos de inferencia detallados, que muestra cómo el modelo integra información visual y auditiva para dibujar predicciones. La función de recompensa está inspirada en Deepseek R1 y se divide en dos partes: recompensa de precisión y recompensa de formato, que en conjunto forman la recompensa final. Este diseño no solo alienta al modelo a generar predicciones correctas, sino que también garantiza que la salida esté estructurada y se ajuste a formatos preestablecidos, mejorando así el rendimiento general del modelo.

Los resultados experimentales muestran que R1-AMNI tiene un aumento promedio de más del 35% en comparación con el modelo de referencia original en el mismo conjunto de pruebas de distribución DFEW y MAFW, y un aumento promedio de más del 10% en comparación con el modelo supervisado de ajuste fino (SFT) en la tasa de recuerdo promedio no ponderado (UAR). En diferentes conjuntos de pruebas distribuidas Ravdess, su tasa de recuperación promedio ponderada (WAR) y UAR aumentaron en más del 13%, lo que demuestra excelentes capacidades de generalización. Además, R1-AMNI también tiene ventajas de transparencia significativas. A través del método RLVR, el papel de la información de audio y video en el modelo se vuelve más claro y más visible, y puede demostrar claramente el papel clave de cada información modal sobre juicios emocionales específicos, proporcionando una referencia importante para comprender el proceso de toma de decisiones del modelo y la investigación futura.

papel:

https://arxiv.org/abs/2503.05379

GitHub:

https://github.com/humanmllm/r1-omni

Modelo:

https://www.modelscope.cn/models/iic/r1-omni-0.5b