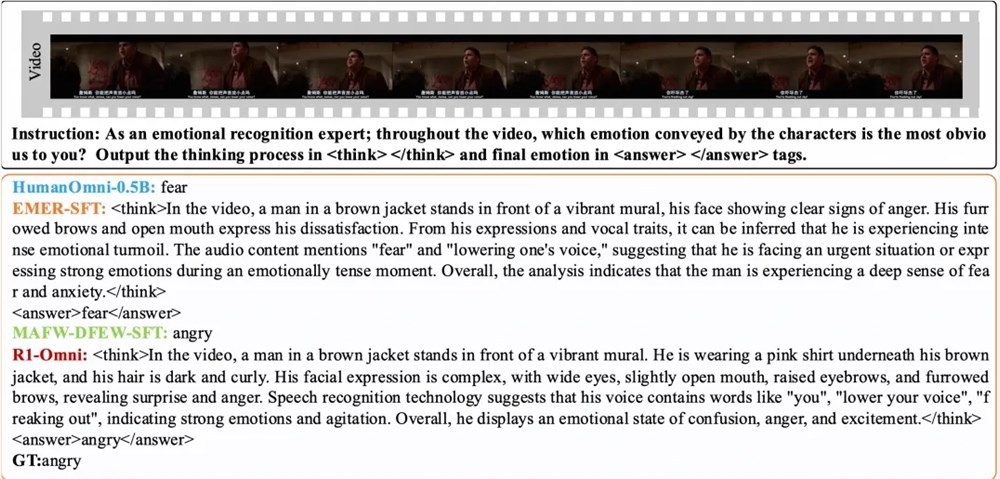

Pada 11 Maret, tim Laboratorium Tongyi mengumumkan model Open Source R1-OMNI, yang telah membawa terobosan baru ke pengembangan model semua modal. Model R1-OMNI menggabungkan pembelajaran penguatan dengan metode imbalan yang dapat diverifikasi (RLVR), dengan fokus pada peningkatan kemampuan inferensi dan kinerja generalisasi dalam tugas pengenalan emosi multimoda. Inovasi ini tidak hanya menyuntikkan vitalitas baru ke bidang kecerdasan buatan, tetapi juga memberikan dukungan teknis yang penting untuk penelitian multimodal di masa depan.

Proses pelatihan R1-OMNI dibagi menjadi dua tahap utama. Selama fase awal dingin, tim menggunakan dataset gabungan yang berisi 580 data video untuk penyempurnaan, terutama dari dataset penalaran emosi multimoda (EMER) yang dapat dijelaskan dan dataset Humanomni. Tujuan dari tahap ini adalah untuk meletakkan dasar bagi kemampuan penalaran model dan memastikan bahwa ia memiliki kemampuan pengenalan emosi multimoda tertentu sebelum memasuki tahap RLVR, sehingga memastikan stabilitas, efisiensi, dan stabilitas pelatihan selanjutnya. Melalui tahap pelatihan ini, model ini awalnya dapat memahami dan memproses data multimodal, meletakkan dasar yang kuat untuk optimasi berikutnya.

Selanjutnya, pada tahap RLVR, model ini dioptimalkan lebih lanjut melalui pembelajaran penguatan dan mekanisme hadiah yang dapat diverifikasi. Kunci dari tahap ini terletak pada desain model strategi dan fungsi penghargaan. Model strategi bertanggung jawab untuk memproses data input multimodal yang terdiri dari frame video dan aliran audio, menghasilkan respons kandidat dengan proses inferensi terperinci, menunjukkan bagaimana model mengintegrasikan informasi visual dan pendengaran untuk menggambar prediksi. Fungsi hadiah diilhami oleh Deepseek R1 dan dibagi menjadi dua bagian: hadiah presisi dan hadiah format, yang bersama -sama membentuk hadiah terakhir. Desain ini tidak hanya mendorong model untuk menghasilkan prediksi yang benar, tetapi juga memastikan bahwa output terstruktur dan sesuai dengan format yang telah ditentukan, sehingga meningkatkan kinerja keseluruhan model.

Hasil eksperimen menunjukkan bahwa R1-OMNI memiliki peningkatan rata-rata lebih dari 35% dibandingkan dengan model baseline asli pada uji distribusi yang sama set DFEW dan MAFW, dan peningkatan rata-rata lebih dari 10% dibandingkan dengan model fine-tuning (SFT) yang diawasi dalam tingkat penarikan rata-rata yang tidak tertimbang (UAR). Pada set tes terdistribusi yang berbeda, Ravdess, tingkat penarikan rata -rata tertimbang (perang) dan UAR keduanya meningkat lebih dari 13%, menunjukkan kemampuan generalisasi yang sangat baik. Selain itu, R1-OMNI juga memiliki keunggulan transparansi yang signifikan. Melalui metode RLVR, peran informasi audio dan video dalam model menjadi lebih jelas dan lebih terlihat, dan dapat dengan jelas menunjukkan peran kunci dari setiap informasi modal tentang penilaian emosional spesifik, memberikan referensi penting untuk memahami model proses pengambilan keputusan dan penelitian di masa depan.

kertas:

https://arxiv.org/abs/2503.05379

GitHub:

https://github.com/humanmllm/r1-omni

Model:

https://www.modelscope.cn/models/iic/r1-omni-0.5b