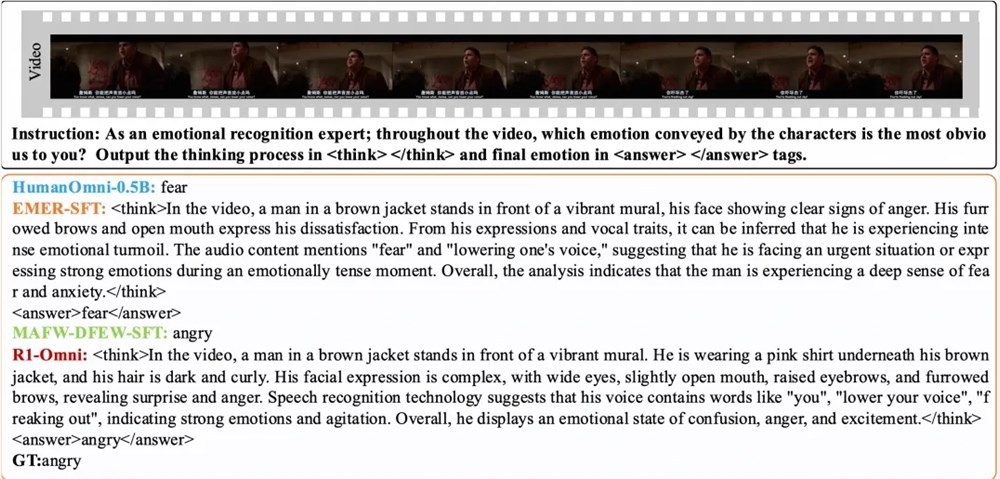

3月11日、Tongyi研究所チームは、すべてのモーダルモデルの開発に新しいブレークスルーをもたらしたオープンソースR1-OMNIモデルを発表しました。 R1-OMNIモデルは、強化学習と検証可能な報酬(RLVR)メソッドを組み合わせて、マルチモーダル感情認識タスクの推論能力と一般化パフォーマンスの改善に焦点を当てています。このイノベーションは、人工知能の分野に新しい活力を注入するだけでなく、将来のマルチモーダル研究のための重要な技術サポートも提供します。

R1-OMNIのトレーニングプロセスは、2つの重要な段階に分かれています。コールドスタートフェーズ中、チームは、主に説明可能なマルチモーダル感情推論(EMER)データセットとHanumniデータセットから、微調整のために580のビデオデータを含む複合データセットを使用しました。この段階の目的は、モデルの推論能力の基礎を築き、RLVR段階に入る前に特定のマルチモーダル感情認識能力を確保し、それによってその後のトレーニングの安定性、効率、安定性を確保することです。トレーニングのこの段階を通じて、モデルは最初にマルチモーダルデータを理解して処理し、その後の最適化のための強固な基盤を築くことができます。

その後、RLVR段階では、モデルは強化学習と検証可能な報酬メカニズムを通じてさらに最適化されます。この段階の鍵は、戦略モデルと報酬機能の設計にあります。戦略モデルは、ビデオフレームとオーディオストリームで構成されるマルチモーダル入力データの処理、詳細な推論プロセスで候補応答を生成し、モデルが視覚情報と聴覚情報を統合して予測を引き出す方法を示します。報酬関数は、Deepseek R1に触発され、2つの部分に分かれています:精密報酬とフォーマット報酬は、最終的な報酬を形成します。この設計は、モデルが正しい予測を生成することを奨励するだけでなく、出力が構造化され、プリセット形式に準拠することを保証し、それによりモデルの全体的なパフォーマンスを改善します。

実験結果は、R1-OMNIが同じ分布テストセットDFEWおよびMAFWの元のベースラインモデルと比較して平均35%を超えることを示しており、非重量の平均リコール率(UAR)の監視された微調整(SFT)モデルと比較して10%以上増加しています。さまざまな分散テストセットのRavdessでは、その加重平均リコール率(戦争)とUARの両方が13%以上増加し、優れた一般化能力を示しています。さらに、R1-OMNIには大きな透明性の利点もあります。 RLVRメソッドを通じて、モデルにおけるオーディオおよびビデオ情報の役割はより明確で目立つようになり、特定の感情的判断に関する各モーダル情報の重要な役割を明確に実証し、モデルの意思決定プロセスと将来の研究を理解するための重要な参照を提供します。

紙:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/humanmllm/r1-omni

モデル:

https://www.modelscope.cn/models/iic/r1-omni-0.5b