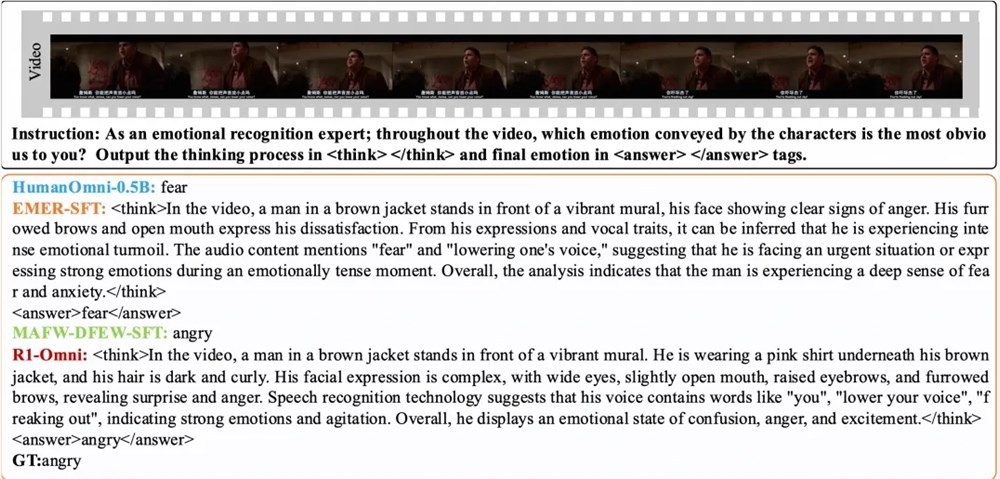

Le 11 mars, l'équipe du Tongyi Laboratory a annoncé le modèle R1-OMNI open source, qui a apporté de nouvelles percées au développement de modèles entièrement modaux. Le modèle R1-OMNI combine l'apprentissage du renforcement avec des méthodes de récompense vérifiable (RLVR), en se concentrant sur l'amélioration des capacités d'inférence et les performances de généralisation dans les tâches de reconnaissance des émotions multimodales. Cette innovation injecte non seulement une nouvelle vitalité dans le domaine de l'intelligence artificielle, mais fournit également un soutien technique important pour la recherche multimodale future.

Le processus de formation de R1-OMNI est divisé en deux étapes clés. Pendant la phase de démarrage à froid, l'équipe a utilisé un ensemble de données combiné contenant 580 données vidéo pour le réglage fin, principalement à partir de l'ensemble de données explicable du raisonnement d'émotion multimodal (Emer) et de l'ensemble de données Humanomni. Le but de cette étape est de jeter les bases de la capacité de raisonnement du modèle et de s'assurer qu'elle a une certaine capacité de reconnaissance des émotions multimodales avant d'entrer sur le stade RLVR, garantissant ainsi la stabilité, l'efficacité et la stabilité de la formation ultérieure. À travers cette étape de la formation, le modèle peut initialement comprendre et traiter les données multimodales, jetant une base solide pour l'optimisation ultérieure.

Par la suite, au stade RLVR, le modèle est encore optimisé par l'apprentissage du renforcement et le mécanisme de récompense vérifiable. La clé de cette étape réside dans la conception du modèle de stratégie et de la fonction de récompense. Le modèle de stratégie est responsable du traitement des données d'entrée multimodales composées de trames vidéo et de flux audio, générant des réponses des candidats avec des processus d'inférence détaillés, montrant comment le modèle intègre des informations visuelles et auditives pour dessiner des prédictions. La fonction de récompense est inspirée par Deepseek R1 et est divisée en deux parties: récompense de précision et récompense de format, qui forment ensemble la récompense finale. Cette conception encourage non seulement le modèle à générer des prédictions correctes, mais garantit également que la sortie est structurée et est conforme aux formats prédéfinis, améliorant ainsi les performances globales du modèle.

Les résultats expérimentaux montrent que R1-OMNI a une augmentation moyenne de plus de 35% par rapport au modèle de base d'origine sur les mêmes tests de distribution DFEW et MAFW, et une augmentation moyenne de plus de 10% par rapport au modèle de réglage fin supervisé (SFT) dans le taux de rappel moyen non pondéré (UAR). Sur différents ensembles de tests distribués Ravdess, son taux de rappel moyen pondéré (guerre) et UAR ont tous deux augmenté de plus de 13%, démontrant d'excellentes capacités de généralisation. De plus, R1-OMNI présente également des avantages de transparence importants. Grâce à la méthode RLVR, le rôle des informations audio et vidéo dans le modèle devient plus clair et plus visible, et peut clairement démontrer le rôle clé de chaque information modale sur des jugements émotionnels spécifiques, en fournissant une référence importante pour comprendre le processus de prise de décision du modèle et la recherche future.

papier:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/humanmllm/r1-omni

Modèle:

https://www.modelscope.cn/models/iic/r1-omni-0.5b