في 11 مارس ، أعلن فريق مختبر Tongyi عن نموذج R1-Omni مفتوح المصدر ، والذي حقق اختراقات جديدة لتطوير نماذج جميع الوسائط. يجمع نموذج R1-OMNI بين التعلم التعزيز مع أساليب المكافآت (RLVR) التي يمكن التحقق منها ، مع التركيز على تحسين قدرات الاستدلال وأداء التعميم في مهام التعرف على العاطفة متعددة الوسائط. لا يضخ هذا الابتكار حيوية جديدة في مجال الذكاء الاصطناعي فحسب ، بل يوفر أيضًا دعمًا فنيًا مهمًا للبحوث المتعددة الوسائط المستقبلية.

تنقسم عملية تدريب R1-OMNI إلى مرحلتين رئيسيتين. خلال مرحلة البدء الباردة ، استخدم الفريق مجموعة بيانات مجتمعة تحتوي على 580 بيانات فيديو للضبط الدقيق ، وخاصة من مجموعة بيانات التفكير المتعددة القابلة للتفسير (EMER) ومجموعة بيانات HumanOmni. الغرض من هذه المرحلة هو وضع الأساس لقدرة التفكير النموذجية والتأكد من أن لديه قدرة على التعرف على المشاعر المتعددة الوسائط قبل الدخول إلى مرحلة RLVR ، وبالتالي ضمان استقرار وكفاءة واستقرار التدريب اللاحق. من خلال هذه المرحلة من التدريب ، يمكن للنموذج في البداية فهم البيانات المتعددة الوسائط ومعالجتها ، مما يضع أساسًا متينًا للتحسين اللاحق.

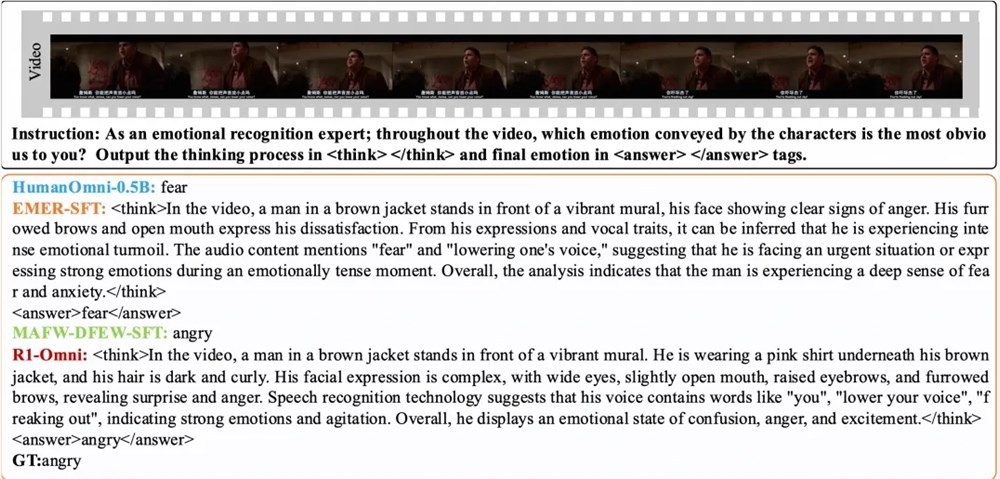

بعد ذلك ، في مرحلة RLVR ، يتم تحسين النموذج بشكل أكبر من خلال التعلم التعزيز وآلية المكافأة القابلة للتحقق. يكمن مفتاح هذه المرحلة في تصميم نموذج الإستراتيجية ووظيفة المكافأة. يكون نموذج الإستراتيجية مسؤولاً عن معالجة بيانات الإدخال متعددة الوسائط المكونة من إطارات الفيديو وتدفقات الصوت ، مما يولد استجابات المرشحين مع عمليات استنتاج مفصلة ، مما يوضح كيف يدمج النموذج المعلومات البصرية والأساسية لرسم التنبؤات. وظيفة المكافأة مستوحاة من DeepSeek R1 وهي مقسمة إلى جزأين: مكافأة الدقة ومكافأة التنسيق ، والتي تشكل معا المكافأة النهائية. لا يشجع هذا التصميم النموذج على توليد التنبؤات الصحيحة فحسب ، بل يضمن أيضًا تنظيم الإخراج ويتوافق مع التنسيقات المسبقة ، وبالتالي تحسين الأداء العام للنموذج.

تظهر النتائج التجريبية أن R1-OMNI لديها زيادة في المتوسط بأكثر من 35 ٪ مقارنة مع نموذج خط الأساس الأصلي على نفس اختبار التوزيع DFEW و MAFW ، وزيادة متوسط تزيد عن 10 ٪ مقارنة مع النموذج الخاضع للضوء (SFT) في متوسط معدل الاستدعاء غير المرغوب فيه (UAR). في مجموعات الاختبارات الموزعة المختلفة ، زاد متوسط معدل استدعاءه المرجح (WAR) و UAR بأكثر من 13 ٪ ، مما يدل على قدرات تعميم ممتازة. بالإضافة إلى ذلك ، يتمتع R1-OMNI أيضًا بمزايا شفافية كبيرة. من خلال طريقة RLVR ، يصبح دور معلومات الصوت والفيديو في النموذج أكثر وضوحًا وأكثر وضوحًا ، ويمكن أن يوضح بوضوح الدور الرئيسي لكل معلومات مشروطة عن أحكام عاطفية محددة ، مما يوفر مرجعًا مهمًا لفهم عملية صنع القرار النموذجية والبحث المستقبلي.

ورق:

https://arxiv.org/abs/2503.05379

جيثب:

https://github.com/humanmllm/r1-omni

نموذج:

https://www.modelscope.cn/models/iic/r1-omni-0.5b