Em 11 de março, a equipe de laboratório de Tongyi anunciou o modelo de código aberto R1-OMNI, que trouxe novos avanços no desenvolvimento de modelos todos os modais. O modelo R1-OMNI combina o aprendizado de reforço com métodos de recompensa verificável (RLVR), concentrando-se em melhorar as capacidades de inferência e o desempenho da generalização em tarefas multimodais de reconhecimento de emoções. Essa inovação não apenas injeta nova vitalidade no campo da inteligência artificial, mas também fornece suporte técnico importante para futuras pesquisas multimodais.

O processo de treinamento do R1-omni é dividido em dois estágios-chave. Durante a fase de partida a frio, a equipe usou um conjunto de dados combinado contendo 580 dados de vídeo para ajuste fino, principalmente a partir do conjunto de dados explicáveis de raciocínio de emoção multimodal (EMER) e o conjunto de dados Humanomni. O objetivo deste estágio é estabelecer a base da capacidade de raciocínio do modelo e garantir que ele tenha certa capacidade de reconhecimento de emoções multimodais antes de entrar no estágio da RLVR, garantindo assim a estabilidade, a eficiência e a estabilidade do treinamento subsequente. Nesse estágio de treinamento, o modelo pode entender e processar inicialmente dados multimodais, estabelecendo uma base sólida para a otimização subsequente.

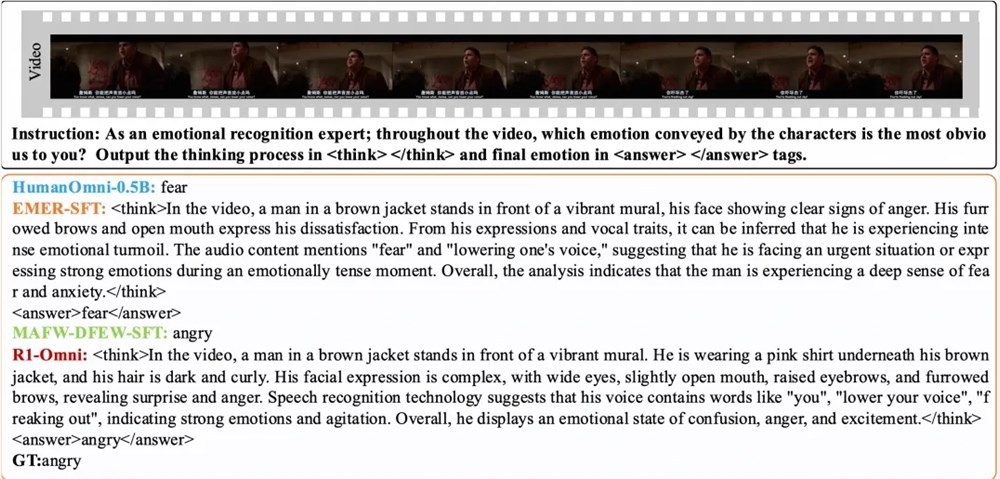

Posteriormente, no estágio RLVR, o modelo é otimizado ainda mais por meio de aprendizado de reforço e mecanismo de recompensa verificável. A chave para esse estágio está no design do modelo de estratégia e da função de recompensa. O modelo de estratégia é responsável pelo processamento de dados de entrada multimodal compostos por quadros de vídeo e fluxos de áudio, gerando respostas de candidatos com processos detalhados de inferência, mostrando como o modelo integra informações visuais e auditivas para desenhar previsões. A função de recompensa é inspirada no Deepseek R1 e é dividida em duas partes: recompensa de precisão e recompensa de formato, que juntos formam a recompensa final. Esse design não apenas incentiva o modelo a gerar previsões corretas, mas também garante que a saída seja estruturada e esteja em conformidade com os formatos predefinidos, melhorando assim o desempenho geral do modelo.

Os resultados experimentais mostram que o R1-OMNI tem um aumento médio de mais de 35% em comparação com o modelo de linha de base original nos mesmos testes de distribuição DFEW e MAFW e um aumento médio de mais de 10% em comparação com o modelo de ajuste fino (SFT) supervisionado na taxa média de recuperação (UAR). Em diferentes conjuntos de testes distribuídos, sua taxa média ponderada de recall (guerra) e UAR aumentaram mais de 13%, demonstrando excelentes capacidades de generalização. Além disso, o R1-OMNI também possui vantagens significativas de transparência. Por meio do método RLVR, o papel das informações de áudio e vídeo no modelo se torna mais claro e mais visível e pode demonstrar claramente o papel principal de cada informação modal sobre julgamentos emocionais específicos, fornecendo uma referência importante para entender o processo de tomada de decisão e pesquisas futuras.

papel:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/humanmllm/r1-omni

Modelo:

https://www.modelscope.cn/models/iic/r1-omni-0.5b