เมื่อเร็ว ๆ นี้ บริษัท Tongyi ได้ประกาศแหล่งที่มาของรุ่นล่าสุดของ Tongyi Wanxiang Movie Wan2.1 ซึ่งได้รับความสนใจอย่างกว้างขวางในด้านปัญญาประดิษฐ์ WAN2.1 เป็นแบบจำลอง AI ที่มุ่งเน้นไปที่การสร้างวิดีโอคุณภาพสูง ด้วยประสิทธิภาพที่โดดเด่นในการจัดการการเคลื่อนไหวที่ซับซ้อนการฟื้นฟูกฎหมายทางกายภาพที่แท้จริงปรับปรุงพื้นผิวของภาพยนตร์และโทรทัศน์และคำแนะนำในการเพิ่มประสิทธิภาพ WAN2.1 ได้กลายเป็นเครื่องมือแรกสำหรับผู้สร้างนักพัฒนาและผู้ใช้องค์กรที่จะยอมรับยุค AI

ในชุดการประเมินผลที่เชื่อถือได้ Vbench, Tongyi Wanxiang Wan2.1 ติดอันดับที่มีคะแนนรวม 86.22%นำเสนอรุ่นการสร้างวิดีโอที่รู้จักกันดีอื่น ๆ อย่างมีนัยสำคัญทั้งในและต่างประเทศเช่น Sora, Minimax, Luma, Gen3 และ Pika ความสำเร็จนี้เกิดจาก DIT กระแสหลักของ WAN2.1 และกระบวนทัศน์การไหลเวียนของเส้นทางการไหลเวียนเชิงเส้นและได้บรรลุความก้าวหน้าที่สำคัญในความสามารถในการสร้างผ่านชุดของนวัตกรรมทางเทคโนโลยี ในหมู่พวกเขาโมดูล VAE สาเหตุ 3 มิติที่พัฒนาขึ้นเองและมีประสิทธิภาพตระหนักถึงการบีบอัดช่องว่างวิดีโอที่ซ่อนอยู่ 256 เท่าและรองรับการเข้ารหัสที่มีประสิทธิภาพและการถอดรหัสวิดีโอที่มีความยาวใด ๆ ผ่านกลไกการแคชคุณลักษณะในขณะที่ลดการใช้หน่วยความจำในระหว่างการอนุมาน 29% นอกจากนี้โมเดลมีข้อได้เปรียบด้านประสิทธิภาพที่สำคัญในสภาพแวดล้อม A800GPU เดียวพร้อมความเร็วในการสร้างวิดีโอเร็วกว่าวิธีการที่ทันสมัยที่มีอยู่เดิม 2.5 เท่า

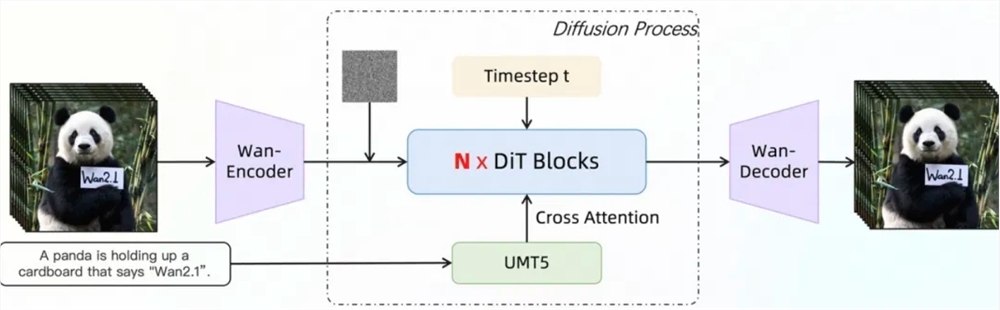

สถาปัตยกรรมการแพร่กระจายวิดีโอของ WAN2.1 ของ WAN2.1 แบบจำลองการพึ่งพาระยะเวลาระยะยาวผ่านกลไกความสนใจอย่างเต็มที่เพื่อสร้างวิดีโอคุณภาพสูงและพื้นที่ที่สอดคล้องกัน กลยุทธ์การฝึกอบรมใช้วิธีการฝึกอบรมทีละขั้นตอน 6 ขั้นตอนซึ่งค่อยๆเปลี่ยนจากการฝึกอบรมข้อมูลภาพความละเอียดต่ำไปสู่การฝึกอบรมข้อมูลวิดีโอความละเอียดสูงและปรับแต่งผ่านข้อมูลคำอธิบายประกอบคุณภาพสูงเพื่อให้แน่ใจว่าประสิทธิภาพที่ยอดเยี่ยมของแบบจำลองในความละเอียดที่แตกต่างกันและสถานการณ์ที่ซับซ้อน ในแง่ของการประมวลผลข้อมูล WAN2.1 ได้ออกแบบกระบวนการทำความสะอาดข้อมูลสี่ขั้นตอนโดยมุ่งเน้นไปที่ขนาดพื้นฐานคุณภาพของภาพและคุณภาพการเคลื่อนไหวเพื่อคัดกรองข้อมูลคุณภาพสูงและหลากหลายจากชุดข้อมูลเริ่มต้นที่มีเสียงดังเพื่อส่งเสริมการฝึกอบรมที่มีประสิทธิภาพ

WAN2.1 ใช้กลยุทธ์ที่หลากหลายในแง่ของการฝึกอบรมแบบจำลองและการเพิ่มประสิทธิภาพประสิทธิภาพการอนุมาน ในระหว่างขั้นตอนการฝึกอบรมกลยุทธ์การกระจายที่แตกต่างกันจะถูกนำมาใช้สำหรับข้อความโมดูลการเข้ารหัสวิดีโอและโมดูล DIT และการหลีกเลี่ยงความซ้ำซ้อนในการคำนวณผ่านการสลับกลยุทธ์ที่มีประสิทธิภาพ ในแง่ของการเพิ่มประสิทธิภาพหน่วยความจำวิดีโอกลยุทธ์การเพิ่มประสิทธิภาพหน่วยความจำวิดีโอแบบเลเยอร์จะถูกนำมาใช้และรวมกับกลไกการจัดการหน่วยความจำวิดีโอ Pytorch เพื่อแก้ปัญหาการกระจายตัวของหน่วยความจำวิดีโอ ในขั้นตอนการอนุมานการเร่งความเร็วแบบกระจายหลายการ์ดใช้เพื่อใช้วิธีการรวมของ FSDP และ 2D CP และปรับปรุงประสิทธิภาพเพิ่มเติมด้วยวิธีการเชิงปริมาณ

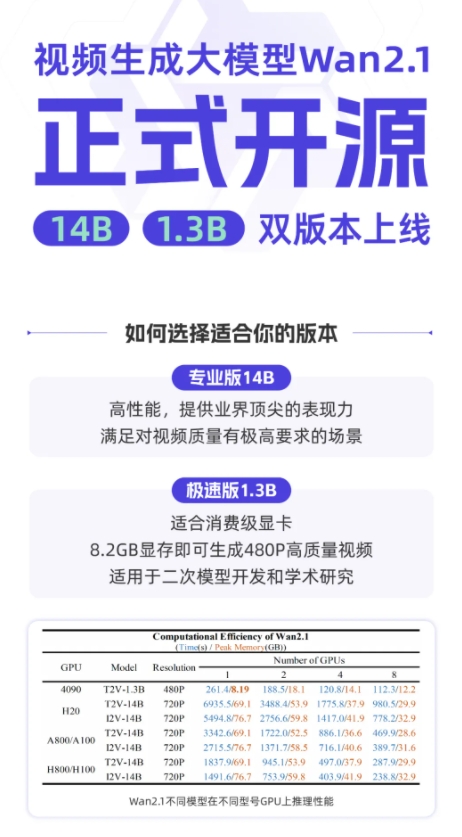

ในปัจจุบัน Tongyi Wanxiang Wan2.1 ได้รับการเปิดแหล่งที่มาบนแพลตฟอร์มเช่น GitHub, Hugging Face และ Mopa Community ซึ่งสนับสนุนเฟรมเวิร์กกระแสหลักที่หลากหลาย นักพัฒนาและนักวิจัยสามารถสัมผัสได้อย่างรวดเร็วผ่าน Gradio หรือใช้การใช้เหตุผลเร่งความเร็วแบบขนาน XDIT เพื่อปรับปรุงประสิทธิภาพ ในเวลาเดียวกันโมเดลกำลังเร่งการเข้าถึง diffusers และ comfyui เพื่อลดความซับซ้อนของการใช้เหตุผลและกระบวนการปรับใช้ให้ลดระดับการพัฒนาและให้ผู้ใช้มีตัวเลือกที่ยืดหยุ่นไม่ว่าจะเป็นการพัฒนาต้นแบบอย่างรวดเร็ว

GitHub: https: //github.com/wan-video

HuggingFace: https: //huggingface.co/wan-ai

ประสบการณ์ออนไลน์: https://tongyi.aliyun.com/wanxiang