في الآونة الأخيرة ، أعلنت شركة Tongyi عن المصدر المفتوح لأحدث نموذج فيلم Tongyi Wanxiang Wan2.1 ، الذي اجتذب اهتمامًا واسع النطاق في مجال الذكاء الاصطناعي. Wan2.1 هو نموذج منظمة العفو الدولية يركز على توليد الفيديو عالي الجودة. من خلال أدائها المتميز في التعامل مع الحركة المعقدة ، واستعادة القوانين الفيزيائية الحقيقية ، وتحسين نسيج الأفلام والتلفزيون ، وتحسين التعليمات ، أصبح WAN2.1 أول أداة للمبدعين والمطورين ومستخدمي المؤسسة لاحتضان عصر الذكاء الاصطناعي.

في مجموعة التقييم الموثوق ، تصدرت Tongyi Wanxiang Wan2.1 القائمة برصيد إجمالي قدرها 86.22 ٪ ، مما يؤدي بشكل كبير إلى نماذج أخرى لتوليد الفيديو المعروفة في الداخل والخارج ، مثل Sora و Minimax و Luma و Gen3 و Pika. يرجع هذا الإنجاز إلى نموذج مطابقة لتدفق مسار WAN2.1 من WAN2.1 ، وقد حقق تطورات كبيرة في قدرات التوليد من خلال سلسلة من الابتكارات التكنولوجية. من بينها ، تحقق وحدة VAE المسببة ثلاثية الأبعاد المتطورة والفعالة 256 مرة انضغاط فيديو خفي 256 مرة ، ويدعم تشفير وفك تشفير مقاطع الفيديو ذات الطول من خلال آلية التخزين المؤقت للميزات ، مع تقليل استخدام الذاكرة أثناء الاستدلال بنسبة 29 ٪. بالإضافة إلى ذلك ، يتمتع النموذج بميزة أداء كبيرة في بيئة A800GPU واحدة مع سرعات إعادة بناء الفيديو أسرع 2.5 مرة من الأساليب الحديثة.

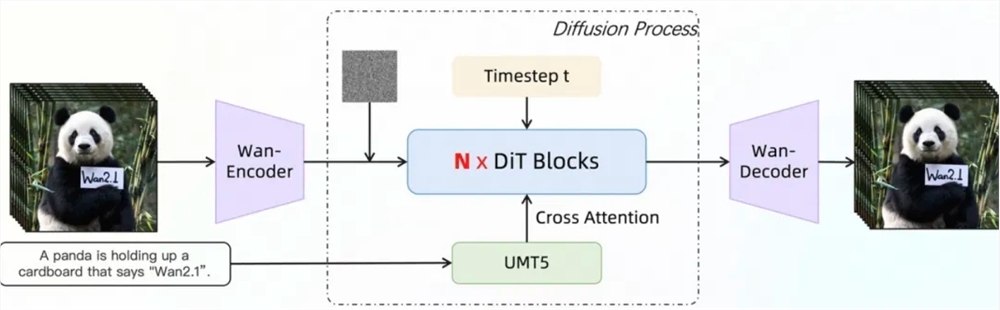

بنية محول نشر الفيديو من WAN2.1 نماذج فعالة تبعية طويلة الأجل للوقت من خلال آلية الانتباه الكاملة لتوليد مقاطع فيديو عالية الجودة ومتسقة للمساحة الزمنية. تتبنى استراتيجيتها التدريبية طريقة تدريب خطوة بخطوة من 6 مراحل ، والتي تنتقل تدريجياً من تدريب بيانات الصور المنخفضة الدقة إلى تدريب بيانات الفيديو عالية الدقة ، وأخيراً ضبطها من خلال بيانات التعليقات التوضيحية عالية الجودة لضمان الأداء الممتاز للنموذج في قرارات مختلفة وسيناريوهات معقدة. من حيث معالجة البيانات ، صمم WAN2.1 عملية تنظيف البيانات من أربع خطوات ، مع التركيز على الأبعاد الأساسية والجودة المرئية وجودة الحركة ، لفحص بيانات عالية الجودة ومتنوعة من مجموعات البيانات الأولية الصاخبة لتعزيز التدريب الفعال.

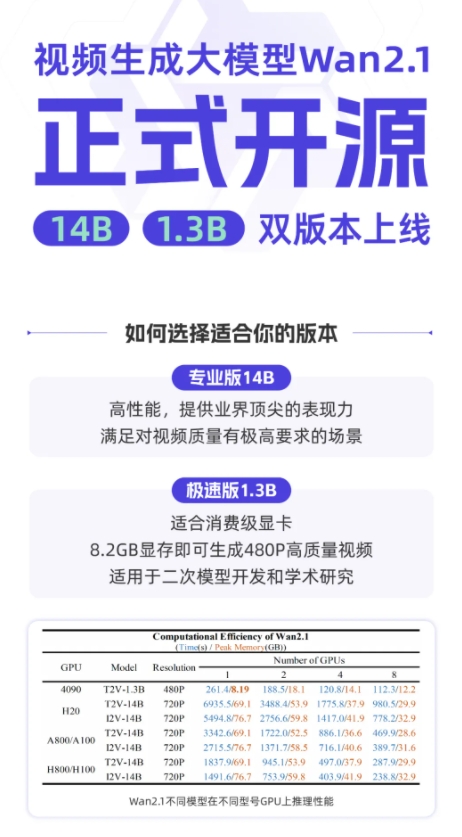

يعتمد WAN2.1 مجموعة متنوعة من الاستراتيجيات من حيث التدريب النموذجي وتحسين كفاءة الاستدلال. خلال مرحلة التدريب ، يتم اعتماد استراتيجيات موزعة مختلفة للنص ، وحدات ترميز الفيديو ووحدات DIT ، ويتم تجنب التكرار الحسابي من خلال تبديل الإستراتيجية الفعالة. فيما يتعلق بتحسين ذاكرة الفيديو ، يتم اعتماد استراتيجية تحسين ذاكرة الفيديو ذات الطبقات ودمجها مع آلية إدارة ذاكرة الفيديو Pytorch لحل مشكلة تجزئة ذاكرة الفيديو. في مرحلة الاستدلال ، يتم استخدام التسارع الموزع متعدد البطاقات لاستخدام الطريقة المشتركة لـ FSDP و 2D CP ، وزيادة تحسين الأداء من خلال الطرق الكمية.

في الوقت الحاضر ، تم الحصول على Tongyi Wanxiang Wan2.1 على منصات مثل GitHub و Ungging Face و Mopa Community ، ودعم مجموعة متنوعة من الأطر السائدة. يمكن للمطورين والباحثين تجربتها بسرعة من خلال Gradio ، أو استخدام التفكير المتسارع XDIT لتحسين الكفاءة. في الوقت نفسه ، يقوم النموذج بتسريع الوصول إلى الناشرين و Comfyui لتبسيط عملية التفكير والنشر بنقرة واحدة ، وتخفيض عتبة التطوير ، وتزويد المستخدمين بخيارات مرنة ، سواء كان ذلك تطوير النموذج الأولي أو نشر إنتاج فعال ، يمكن تنفيذه بسهولة.

Github: https: //github.com/wan-video

Luggingface: https: //huggingface.co/wan-ai

الخبرة عبر الإنترنت: https://tongyi.aliyun.com/wanxiang