Recentemente, a Tongyi Company anunciou o código aberto do seu mais recente modelo de filme de Tongyi Wanxiang Wan2.1, que atraiu atenção generalizada no campo da inteligência artificial. O WAN2.1 é um modelo de IA com foco na geração de vídeo de alta qualidade. Com seu excelente desempenho no manuseio de movimentos complexos, restaurando leis físicas reais, melhorando a textura do cinema e da televisão e otimizando as instruções, o WAN2.1 tornou -se a primeira ferramenta para criadores, desenvolvedores e usuários da empresa a adotar a era da IA.

No conjunto de avaliação autoritário, o Tongyi Wanxiang Wan2.1 liderou a lista com uma pontuação total de 86,22%, liderando significativamente outros modelos de geração de vídeo bem conhecidos em casa e no exterior, como Sora, Minimax, Luma, Gen3 e Pika. Essa conquista se deve ao DIT principal do WAN2.1 e ao paradigma de combinação de fluxo de trajetória de ruído linear e alcançou avanços significativos nas capacidades de geração por meio de uma série de inovações tecnológicas. Entre eles, o módulo 3D causal 3D auto-desenvolvido e eficiente realiza 256 vezes a compactação de espaço oculta de vídeo sem perdas e suporta codificação e decodificação eficientes de vídeos de qualquer comprimento através do mecanismo de cache de recursos, reduzindo o uso da memória durante 29%. Além disso, o modelo tem uma vantagem significativa de desempenho em um único ambiente A800GPU com velocidades de reconstrução de vídeo 2,5 vezes mais rapidamente do que os métodos de última geração existentes.

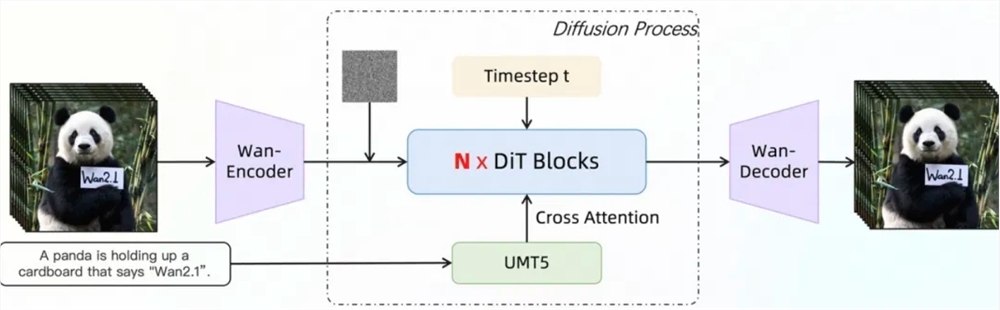

A arquitetura de transformadores de difusão em vídeo do WAN2.1 modela efetivamente as dependências espaciais de longo prazo através de todo o mecanismo de atenção para gerar vídeos de alta qualidade e espaço-espaço. Sua estratégia de treinamento adota um método de treinamento passo a passo de 6 estágios, que gradualmente faz a transição do pré-treinamento de dados de imagem de baixa resolução para o treinamento de dados de vídeo de alta resolução e, finalmente, ajustam-os por meio de dados de anotação de alta qualidade para garantir o excelente desempenho do modelo em diferentes resoluções e cenários complexos. Em termos de processamento de dados, o WAN2.1 projetou um processo de limpeza de dados de quatro etapas, com foco em dimensões básicas, qualidade visual e qualidade do movimento, para exibir dados de alta qualidade e diversos dados iniciais de dados iniciais para promover um treinamento eficaz.

O WAN2.1 adota uma variedade de estratégias em termos de treinamento modelo e otimização de eficiência de inferência. Durante a fase de treinamento, diferentes estratégias distribuídas são adotadas para texto, módulos de codificação de vídeo e módulos de DIT e redundância computacional é evitada através de comutação de estratégia eficiente. Em termos de otimização de memória de vídeo, uma estratégia de otimização de memória em camadas é adotada e combinada com o mecanismo de gerenciamento de memória de vídeo pytorch para resolver o problema da fragmentação de memória de vídeo. No estágio de inferência, a aceleração distribuída de vários cards é usada para usar o método combinado de FSDP e 2D CP e melhorar ainda mais o desempenho por meio de métodos quantitativos.

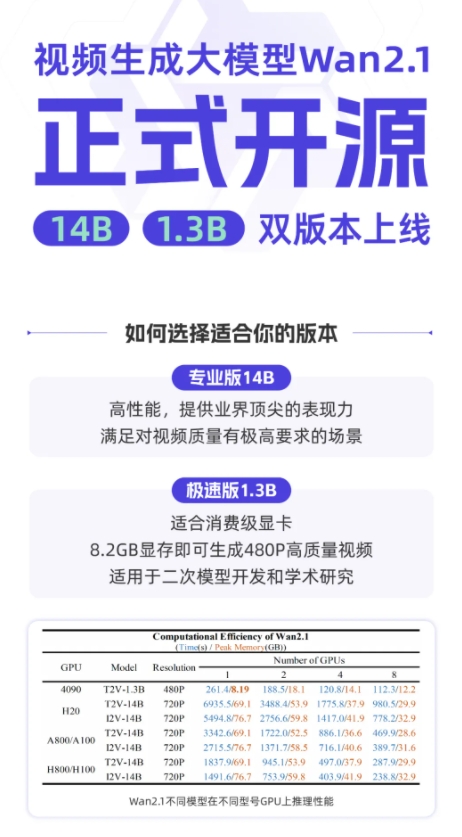

Atualmente, Tongyi Wanxiang Wan2.1 foi de origem aberta em plataformas como o Github, abraçando o rosto e a comunidade Mopa, apoiando uma variedade de estruturas convencionais. Desenvolvedores e pesquisadores podem experimentá -lo rapidamente através do Gradio ou usar o raciocínio acelerado paralelo do XDIT para melhorar a eficiência. Ao mesmo tempo, o modelo está acelerando o acesso a difusores e conformários para simplificar o processo de raciocínio e implantação com um clique, diminuir o limiar de desenvolvimento e fornecer aos usuários opções flexíveis, seja no desenvolvimento de protótipos e eficientes eficientes, pode ser facilmente implementado.

Github: https: //github.com/wan-video

Huggingface: https: //huggingface.co/wan-ai

Experiência on -line: https://tongyi.aliyun.com/wanxiang