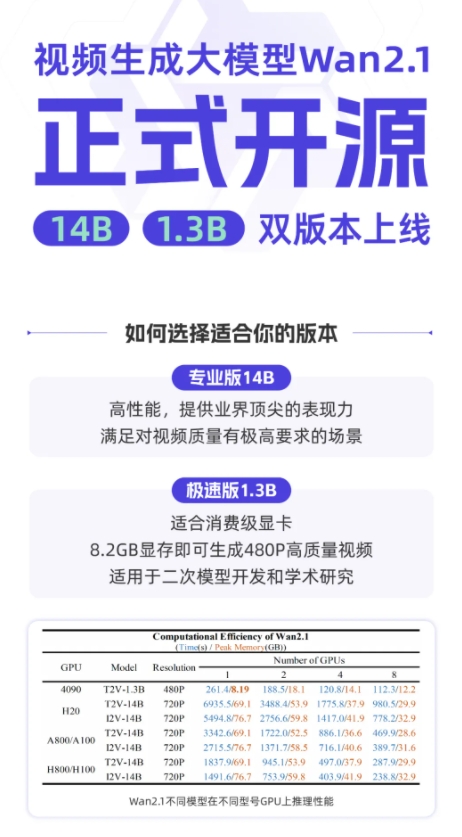

Recientemente, Tongyi Company anunció el código abierto de su último modelo de película Tongyi Wanxiang Wan2.1, que ha atraído una atención generalizada en el campo de la inteligencia artificial. WAN2.1 es un modelo de IA que se centra en la generación de videos de alta calidad. Con su rendimiento sobresaliente en el manejo de un movimiento complejo, restaurar leyes físicas reales, mejorar la textura del cine y la televisión, y optimizar las instrucciones, WAN2.1 se ha convertido en la primera herramienta para que los creadores, desarrolladores y usuarios empresariales adopten la era de la IA.

En el conjunto de evaluación autorizada Vbench, Tongyi Wanxiang Wan2.1 encabezó la lista con una puntuación total de 86.22%, lo que llevó significativamente a otros modelos de generación de videos conocidos en el hogar y en el extranjero, como Sora, Minimax, Luma, Gen3 y Pika. Este logro se debe al paradigma de flujo de flujo de trayectoria de ruido lineal de WAN2.1, y ha logrado avances significativos en las capacidades de generación a través de una serie de innovaciones tecnológicas. Entre ellos, el módulo VAE causal 3D autodesarrollado y eficiente se realiza 256 veces la compresión del espacio oculto de video sin pérdidas, y admite la codificación y decodificación eficientes de videos de cualquier longitud a través del mecanismo de almacenamiento en caché de características, al tiempo que reduce el uso de la memoria durante la inferencia en un 29%. Además, el modelo tiene una ventaja de rendimiento significativa en un solo entorno A800GPU con velocidades de reconstrucción de video 2.5 veces más rápido que los métodos de vanguardia existentes.

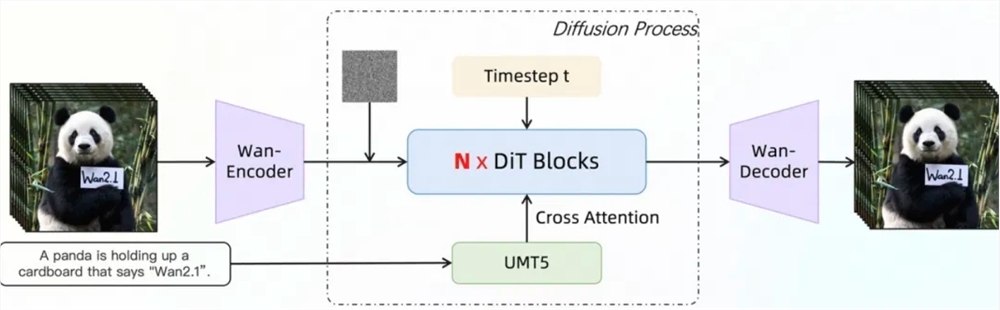

La arquitectura del transformador de difusión de video de WAN2.1 modela efectivamente las dependencias de espacio-tiempo a largo plazo a través del mecanismo de atención completa para generar videos de alta calidad y espacio-espacio. Su estrategia de capacitación adopta un método de entrenamiento paso a paso de 6 etapas, que pasa gradualmente de la capacitación previa de datos de imagen de baja resolución a la capacitación de datos de video de alta resolución, y finalmente lo ajusta a través de datos de anotación de alta calidad para garantizar el excelente rendimiento del modelo en diferentes resoluciones y escenarios complejos. En términos de procesamiento de datos, WAN2.1 diseñó un proceso de limpieza de datos de cuatro pasos, centrándose en dimensiones básicas, calidad visual y calidad de movimiento, para detectar datos de alta calidad y diversos de conjuntos de datos iniciales ruidosos para promover una capacitación efectiva.

WAN2.1 adopta una variedad de estrategias en términos de capacitación modelo y optimización de eficiencia de inferencia. Durante la fase de entrenamiento, se adoptan diferentes estrategias distribuidas para texto, módulos de codificación de video y módulos DIT, y se evita la redundancia computacional a través del cambio de estrategia eficiente. En términos de optimización de la memoria de video, se adopta y combina una estrategia de optimización de memoria de video en capas con el mecanismo de gestión de la memoria de video Pytorch para resolver el problema de la fragmentación de la memoria de video. En la etapa de inferencia, se utiliza la aceleración distribuida de tarjetas múltiples para usar el método combinado de FSDP y CP 2D, y mejorar aún más el rendimiento a través de métodos cuantitativos.

En la actualidad, Tongyi Wanxiang Wan2.1 ha sido abierto en plataformas como Github, abrazando la cara y la comunidad MOPA, que apoya una variedad de marcos convencionales. Los desarrolladores e investigadores pueden experimentarlo rápidamente a través de Gradio, o usar el razonamiento acelerado paralelo XDIT para mejorar la eficiencia. Al mismo tiempo, el modelo está acelerando el acceso a difusores y cómodos para simplificar el proceso de razonamiento y implementación de un solo clic, reducir el umbral de desarrollo y proporcionar a los usuarios opciones flexibles, ya sea un desarrollo de prototipo rápido o una implementación de producción eficiente, se puede implementar fácilmente.

Github: https: //github.com/wan-video

Huggingface: https: //huggingface.co/wan-ai

Experiencia en línea: https://tongyi.aliyun.com/wanxiang