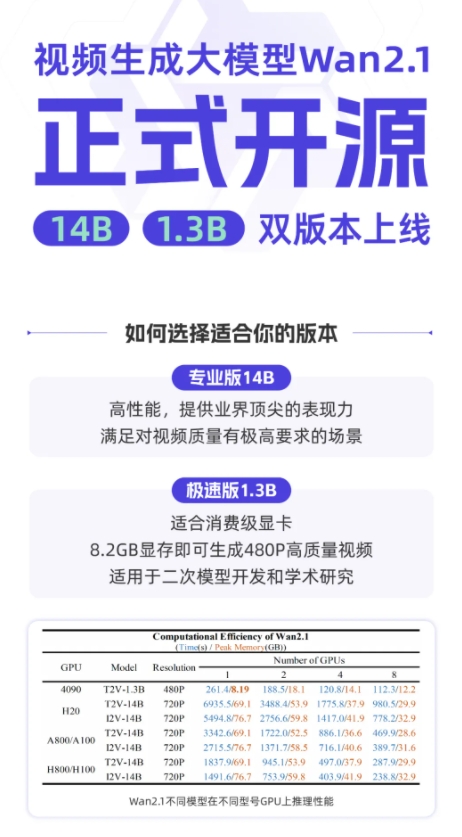

Недавно компания Tongyi объявила об открытом исходном коде его новейшей модели фильма Tongyi Wanxiang WAN2.1, которая привлекло широкое внимание в области искусственного интеллекта. WAN2.1-это модель ИИ, посвященная высококачественному генерации видео. Благодаря своей выдающейся производительности в обращении с сложным движением, восстановлением реальных физических законов, улучшением текстуры кино и телевидения и оптимизации инструкций, WAN2.1 стал первым инструментом для создателей, разработчиков и предприятий, которые придерживались эры ИИ.

В авторитетной оценке набор VBENCH Tongyi Wanxiang WAN2.1 возглавил список с общим баллом 86,22%, что значительно привело к другим известным моделям генерации видео и за рубежом, такими как Sora, Minimax, Luma, Gen3 и Pika. Это достижение связано с основной DIT и линейной траекторией WAN2.1, соответствующей парадигме траектории шума, и достигла значительных достижений в возможностях генерации благодаря серии технологических инноваций. Среди них саморазвитый и эффективный 3D-причинный модуль VAE реализует скрытое сжатие пространства в 256 раз и поддерживает эффективное кодирование и декодирование видео любой длины с помощью механизма кэширования признаков, одновременно уменьшая использование памяти во время вывода на 29%. Кроме того, модель имеет значительное преимущество в производительности в одной среде A800GPU с скоростями реконструкции видео в 2,5 раза быстрее, чем существующие современные методы.

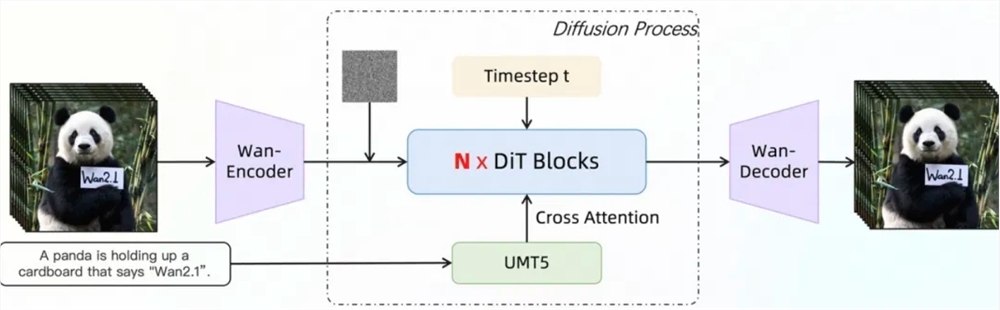

Архитектура диффузионного трансформатора WAN2.1 эффективно моделирует долгосрочные зависимости пространства-времени с помощью механизма полного внимания, чтобы создать высококачественные и промежуточные видеоролики. Его стратегия обучения принимает 6-ступенчатый пошаговый метод обучения, который постепенно переходит от предварительного обучения данных изображений с низким разрешением к обучению видеоданных с высоким разрешением и, наконец, настраивать их с помощью высококачественных данных аннотаций, чтобы обеспечить превосходную производительность модели в различных разрешениях и сложных сценариях. С точки зрения обработки данных, WAN2.1 разработал четырехэтапный процесс очистки данных, сосредоточившись на основных аспектах, визуальном качеством и качеством движения, чтобы проверить высококачественные и разнообразные данные из шумных начальных наборов данных для продвижения эффективного обучения.

WAN2.1 принимает различные стратегии с точки зрения модельного обучения и оптимизации эффективности вывода. На этапе обучения различные распределенные стратегии применяются для текста, модулей кодирования видео и модулей DIT, а также вычислительную избыточность избегают с помощью эффективного переключения стратегии. С точки зрения оптимизации видео памяти, используется слоистая стратегия оптимизации видео памяти и в сочетании с механизмом управления видео памяти Pytorch для решения проблемы фрагментации видео памяти. На стадии вывода многократное распределенное ускорение используется для использования комбинированного метода FSDP и 2D CP, а также для повышения производительности с помощью количественных методов.

В настоящее время Tongyi Wanxiang WAN2.1 был открыт на таких платформах, как GitHub, обнимающееся лицо и сообщество MOPA, поддерживая различные основные рамки. Разработчики и исследователи могут быстро испытать это через Gradio или использовать параллельные ускоренные рассуждения XDIT для повышения эффективности. В то же время модель ускоряет доступ к диффузорам и Comfyui, чтобы упростить процесс рассуждений и развертывания одного клика, снизить порог разработки и предоставить пользователям гибкий выбор, будь то быстрое разработка прототипа или эффективное развертывание производства, это может быть легко реализовано.

GitHub: https: //github.com/wan-video

Huggingface: https: //huggingface.co/wan-ai

Опыт онлайн: https://tongyi.aliyun.com/wanxiang