最近、Tongyi Companyは、最新のTongyi Wanxiang Movie Model Wan2.1のオープンソースを発表しました。 WAN2.1は、高品質のビデオ生成に焦点を当てたAIモデルです。複雑な動きの取り扱い、実際の物理的法則の回復、映画やテレビのテクスチャの改善、および指示の最適化における優れたパフォーマンスにより、WAN2.1は、AI時代を採用するクリエイター、開発者、エンタープライズユーザーが最初のツールになりました。

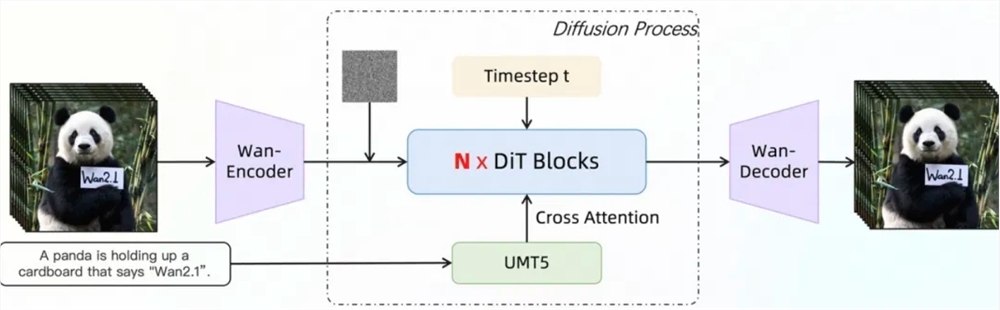

権威ある評価セットvbenchで、Tongyi wanxiang wan2.1は合計スコア86.22%でリストのトップになり、Sora、Minimax、Luma、Gen3、Pikaなど、在宅および海外で他の有名なビデオ生成モデルを大幅にリードしました。この成果は、WAN2.1の主流のDITおよび線形ノイズ軌道の流れのパラダイムによるものであり、一連の技術革新を通じて生成能力の大きな進歩を達成しています。その中で、自己開発で効率的な3D因果VAEモジュールは、256倍のロスレスビデオ隠されたスペース圧縮を実現し、機能キャッシングメカニズムを介して任意の長さのビデオの効率的なエンコードとデコードをサポートし、推論中のメモリ使用量を29%削減します。さらに、このモデルは、既存の最先端の方法よりも2.5倍高速なビデオ再建速度を備えた、単一のA800GPU環境で大きなパフォーマンスの利点があります。

WAN2.1のビデオ拡散変圧器アーキテクチャは、高品質および時間空間の無意味なビデオを生成するための完全な注意メカニズムを通じて、長期の時空依存関係を効果的にモデル化します。そのトレーニング戦略は、6段階のステップバイステップトレーニング方法を採用しています。これは、低解像度の画像データの事前トレーニングから高解像度のビデオデータのトレーニングへと徐々に移行し、最終的に高品質の注釈データを通じて微調整して、異なる解像度と複雑なシナリオでモデルの優れたパフォーマンスを確保します。データ処理の観点から、WAN2.1は、基本的な次元、視覚品質、および動きの品質に焦点を当てた4段階のデータクリーニングプロセスを設計し、効果的なトレーニングを促進するために騒々しい初期データセットから高品質で多様なデータをスクリーニングしました。

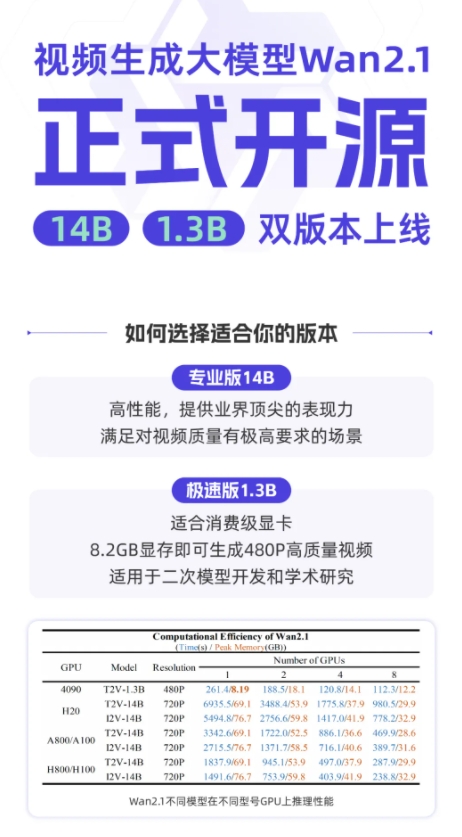

WAN2.1は、モデルトレーニングと推論効率の最適化に関して、さまざまな戦略を採用しています。トレーニング段階では、テキスト、ビデオエンコードモジュール、DITモジュールにさまざまな分散戦略が採用され、効率的な戦略の切り替えを通じて計算冗長性が回避されます。ビデオメモリの最適化に関しては、ビデオメモリの断片化の問題を解決するために、層状のビデオメモリ最適化戦略が採用され、Pytorchビデオメモリ管理メカニズムと組み合わされています。推論段階では、Multi-Card分布の加速度を使用して、FSDPと2D CPの組み合わせ方法を使用し、定量的方法を通じてパフォーマンスをさらに向上させます。

現在、Tongyi Wanxiang Wan2.1は、Github、Hugging Face、Mopaコミュニティなどのプラットフォームで開かれており、さまざまな主流のフレームワークをサポートしています。開発者と研究者は、グラデーションを通じて迅速に体験することも、XDIT平行した加速推論を使用して効率を向上させることもできます。同時に、モデルはディフューザーとcomfyuiへのアクセスを加速して、ワンクリックの推論と展開プロセスを簡素化し、開発のしきい値を下げ、迅速なプロトタイプ開発であろうと効率的な生産展開であろうと、ユーザーに柔軟な選択肢を提供することができます。

github:https://github.com/wan-video

Huggingface:https://huggingface.co/wan-ai

オンラインエクスペリエンス:https://tongyi.aliyun.com/wanxiang