Baru -baru ini, Tongyi Company mengumumkan open source dari model film Tongyi Wanxiang terbaru Wan2.1, yang telah menarik perhatian luas di bidang kecerdasan buatan. WAN2.1 adalah model AI yang berfokus pada pembuatan video berkualitas tinggi. Dengan kinerja yang luar biasa dalam menangani gerakan yang kompleks, memulihkan hukum fisik yang nyata, meningkatkan tekstur film dan televisi, dan mengoptimalkan instruksi, WAN2.1 telah menjadi alat pertama bagi pencipta, pengembang, dan pengguna perusahaan untuk merangkul era AI.

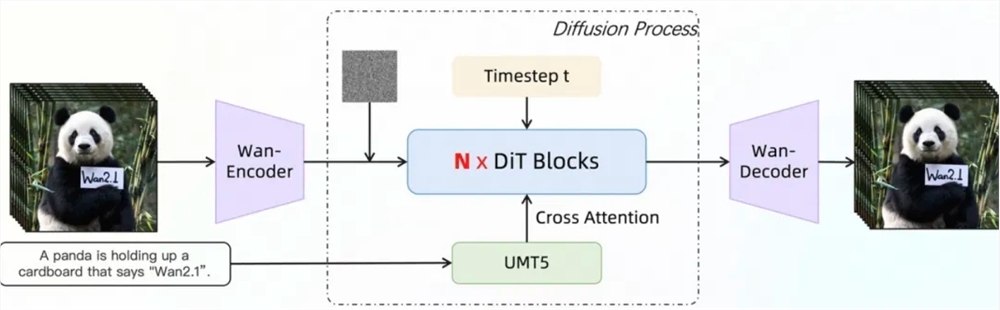

Dalam set evaluasi otoritatif VBENCH, Tongyi Wanxiang Wan2.1 menduduki puncak daftar dengan skor total 86,22%, secara signifikan memimpin model generasi video terkenal lainnya di rumah dan di luar negeri, seperti Sora, Minimax, Luma, Gen3 dan Pika. Pencapaian ini disebabkan oleh Dit Mainstream Dit dan linier linier linier. Di antara mereka, modul VAE kausal 3D yang dikembangkan sendiri dan efisien mewujudkan kompresi ruang tersembunyi video tanpa kehilangan 256 kali, dan mendukung pengkodean dan decoding video yang efisien dengan mekanisme caching fitur, sambil mengurangi penggunaan memori selama inferensi sebesar 29%. Selain itu, model ini memiliki keunggulan kinerja yang signifikan dalam lingkungan A800GPU tunggal dengan kecepatan rekonstruksi video 2,5 kali lebih cepat daripada metode canggih yang ada.

Arsitektur transformator difusi video WAN2.1 secara efektif memodelkan ketergantungan ruang-waktu jangka panjang melalui mekanisme perhatian penuh untuk menghasilkan video berkualitas tinggi dan konsisten waktu. Strategi pelatihannya mengadopsi metode pelatihan langkah demi langkah 6-tahap, yang secara bertahap beralih dari pra-pelatihan data gambar resolusi rendah ke pelatihan data video resolusi tinggi, dan akhirnya menyempurnakannya melalui data anotasi berkualitas tinggi untuk memastikan kinerja model yang sangat baik dalam resolusi yang berbeda dan skenario kompleks. Dalam hal pemrosesan data, WAN2.1 merancang proses pembersihan data empat langkah, dengan fokus pada dimensi dasar, kualitas visual dan kualitas gerak, untuk menyaring data berkualitas tinggi dan beragam dari set data awal yang bising untuk mempromosikan pelatihan yang efektif.

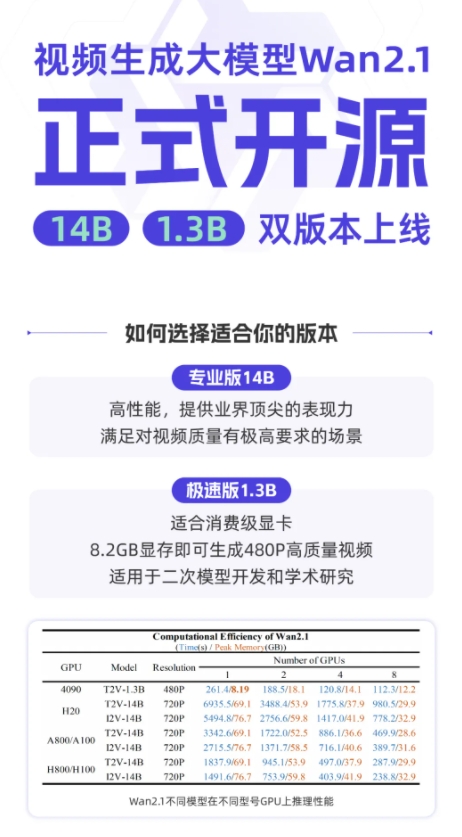

WAN2.1 mengadopsi berbagai strategi dalam hal pelatihan model dan optimasi efisiensi inferensi. Selama fase pelatihan, strategi terdistribusi yang berbeda diadopsi untuk teks, modul pengkodean video dan modul DIT, dan redundansi komputasi dihindari melalui pergantian strategi yang efisien. Dalam hal optimasi memori video, strategi optimasi memori video berlapis diadopsi dan dikombinasikan dengan mekanisme manajemen memori video Pytorch untuk menyelesaikan masalah fragmentasi memori video. Pada tahap inferensi, akselerasi terdistribusi multi-kartu digunakan untuk menggunakan metode gabungan FSDP dan 2D CP, dan lebih lanjut meningkatkan kinerja melalui metode kuantitatif.

Saat ini, Tongyi Wanxiang Wan2.1 telah bersumber terbuka pada platform seperti GitHub, memeluk komunitas wajah dan MOPA, mendukung berbagai kerangka kerja utama. Pengembang dan peneliti dapat mengalaminya dengan cepat melalui Gradio, atau menggunakan penalaran yang dipercepat paralel XDIT untuk meningkatkan efisiensi. Pada saat yang sama, model ini mempercepat akses ke diffuser dan comfyui untuk menyederhanakan proses penalaran dan penyebaran satu klik, menurunkan ambang batas pengembangan, dan memberikan pilihan fleksibel kepada pengguna, apakah itu pengembangan prototipe yang cepat atau penyebaran produksi yang efisien, dapat dengan mudah diimplementasikan.

GitHub: https: //github.com/wan-video

Huggingface: https: //huggingface.co/wan-ai

Pengalaman Online: https://tongyi.aliyun.com/wanxiang