Récemment, Tongyi Company a annoncé l'open source de son dernier modèle de film de Tongyi Wanxiang Wan2.1, qui a attiré une attention généralisée dans le domaine de l'intelligence artificielle. WAN2.1 est un modèle d'IA se concentrant sur la génération vidéo de haute qualité. Avec ses performances exceptionnelles dans la gestion des mouvements complexes, la restauration de lois physiques réelles, l'amélioration de la texture du cinéma et de la télévision et de l'optimisation des instructions, WAN2.1 est devenu le premier outil pour les créateurs, les développeurs et les utilisateurs d'entreprise à adopter l'ère AI.

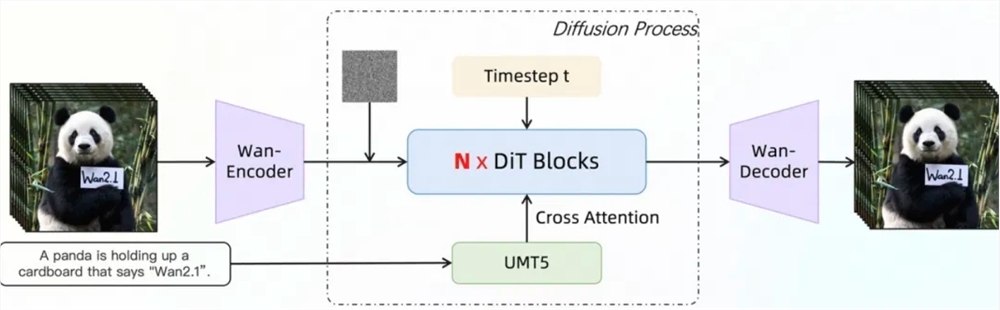

Dans l'ensemble d'évaluation faisant autorité Vbench, Tongyi Wanxiang Wan2.1 a dominé la liste avec un score total de 86,22%, menant considérablement d'autres modèles de génération de vidéos bien connus au pays et à l'étranger, tels que Sora, Minimax, Luma, Gen3 et Pika. Cette réalisation est due au paradigme de correspondance du DIT traditionnel et de la trajectoire du bruit linéaire de WAN2.1 et a réalisé des progrès importants dans les capacités de génération grâce à une série d'innovations technologiques. Parmi eux, le module VAE 3D développé et efficace réalise 256 fois la compression de l'espace caché sans perte, et prend en charge un codage et un décodage efficaces des vidéos de toute longueur par le mécanisme de mise en cache des caractéristiques, tout en réduisant l'utilisation de la mémoire pendant l'inférence de 29%. De plus, le modèle a un avantage de performance significatif dans un seul environnement A800GPU avec des vitesses de reconstruction vidéo 2,5 fois plus rapides que les méthodes de pointe existantes.

L'architecture du transformateur de diffusion vidéo de WAN2.1 modélise efficacement les dépendances à long terme dans l'espace-temps grâce au mécanisme d'attention complet pour générer des vidéos cohérentes de haute qualité et de temps. Sa stratégie de formation adopte une méthode de formation étape par étape en 6 étapes, qui passe progressivement de la pré-formation des données d'image à basse résolution à la formation de données vidéo à haute résolution, et enfin de l'intégration de l'informatique via des données d'annotation de haute qualité pour assurer l'excellente performance du modèle dans différentes résolutions et scénarios complexes. En termes de traitement des données, WAN2.1 a conçu un processus de nettoyage de données en quatre étapes, en se concentrant sur les dimensions de base, la qualité visuelle et la qualité du mouvement, pour filtrer les données de haute qualité et diverses des ensembles de données initiaux bruyants pour promouvoir une formation efficace.

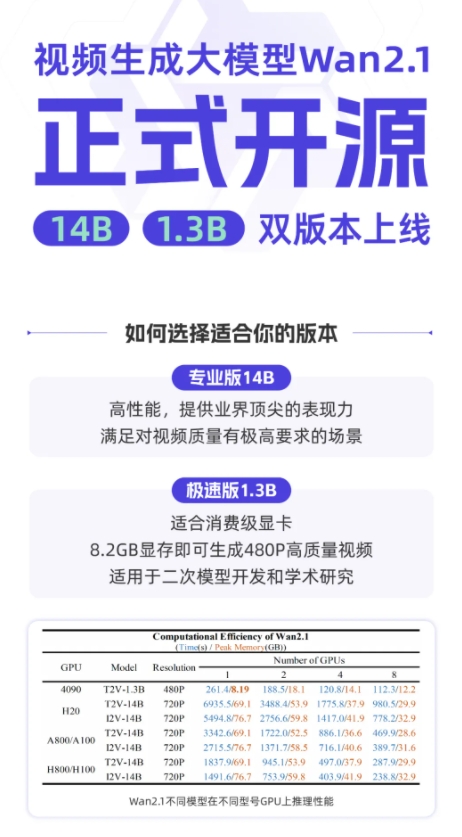

WAN2.1 adopte une variété de stratégies en termes de formation modèle et d'optimisation de l'efficacité d'inférence. Pendant la phase de formation, différentes stratégies distribuées sont adoptées pour le texte, les modules de codage vidéo et les modules DIT et la redondance de calcul sont évitées grâce à une commutation de stratégie efficace. En termes d'optimisation de la mémoire vidéo, une stratégie d'optimisation de la mémoire vidéo en couches est adoptée et combinée avec le mécanisme de gestion de la mémoire vidéo Pytorch pour résoudre le problème de la fragmentation de la mémoire vidéo. Au stade d'inférence, l'accélération distribuée multi-cartes est utilisée pour utiliser la méthode combinée de FSDP et CP 2D, et améliore encore les performances par des méthodes quantitatives.

À l'heure actuelle, Tongyi Wanxiang Wan2.1 a été ouvert sur des plateformes telles que Github, Hugging Face et Mopa Community, soutenant une variété de cadres traditionnels. Les développeurs et les chercheurs peuvent en faire l'expérience rapidement via Gradio ou utiliser le raisonnement accéléré parallèle Xdit pour améliorer l'efficacité. Dans le même temps, le modèle accélère l'accès aux diffuseurs et au comfyui pour simplifier le processus de raisonnement et de déploiement en un clic, abaisser le seuil de développement et fournir aux utilisateurs des choix flexibles, qu'il s'agisse d'un développement prototype rapide ou d'un déploiement de production efficace, il peut être facilement mis en œuvre.

Github: https: //github.com/wan-video

Huggingface: https: //huggingface.co/wan-ai

Expérience en ligne: https://tongyi.aliyun.com/wanxiang