[หน้ากระดาษ] [YouTube Talk 1] [YouTube Talk 2] [บล็อกกลาง]

[การตีความภาษาจีนเกี่ยวกับหัวใจของเครื่อง] [การตีความภาษาจีนของบิตควอนตัม] [การตีความภาษาจีนของมนุษย์อนุกรมเวลา] [การตีความภาษาจีนของครัวอัลกอริทึม AI] [การตีความภาษาจีนของการตีความจีน Zhihu]

- โปรดแจ้งให้เราทราบหากคุณพบข้อผิดพลาดหรือมีข้อเสนอแนะ!

- หากคุณพบว่าทรัพยากรนี้มีประโยชน์โปรดพิจารณาที่จะแสดงที่เก็บนี้และอ้างอิงการวิจัยของเรา:

@inproceedings{jin2023time,

title={{Time-LLM}: Time series forecasting by reprogramming large language models},

author={Jin, Ming and Wang, Shiyu and Ma, Lintao and Chu, Zhixuan and Zhang, James Y and Shi, Xiaoming and Chen, Pin-Yu and Liang, Yuxuan and Li, Yuan-Fang and Pan, Shirui and Wen, Qingsong},

booktitle={International Conference on Learning Representations (ICLR)},

year={2024}

}

ข่าว (ส.ค. 2024): Time-LLM ได้รับการรับรองโดย XIMOUSIPIZATION TECHYRECE CO. , Ltd. (XMO) สำหรับการพยากรณ์พลังงานแสงอาทิตย์ลมและสภาพอากาศ

ข่าว (พฤษภาคม 2024): Time-LLM รวมอยู่ใน NeuralForecast ขอขอบคุณเป็นพิเศษสำหรับผู้สนับสนุน @jqgoh และ @marcopeix!

ข่าว (มีนาคม 2567): Time-LLM ได้รับการอัพเกรดเพื่อทำหน้าที่เป็นกรอบทั่วไปสำหรับการเปลี่ยนรูปแบบภาษาที่หลากหลายในการพยากรณ์อนุกรมเวลา ตอนนี้มันเริ่มต้นที่จะสนับสนุน LLAMA-7B และรวมถึงความเข้ากันได้กับ PLMS ขนาดเล็กเพิ่มเติมอีกสองรายการ (GPT-2 และ BERT) เพียงแค่ปรับ --llm_model และ --llm_dim เพื่อสลับแบ็คโบน

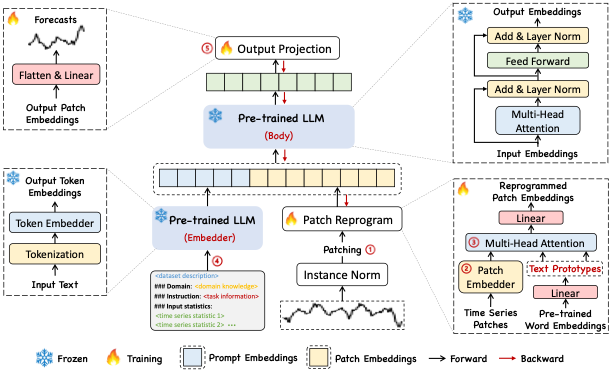

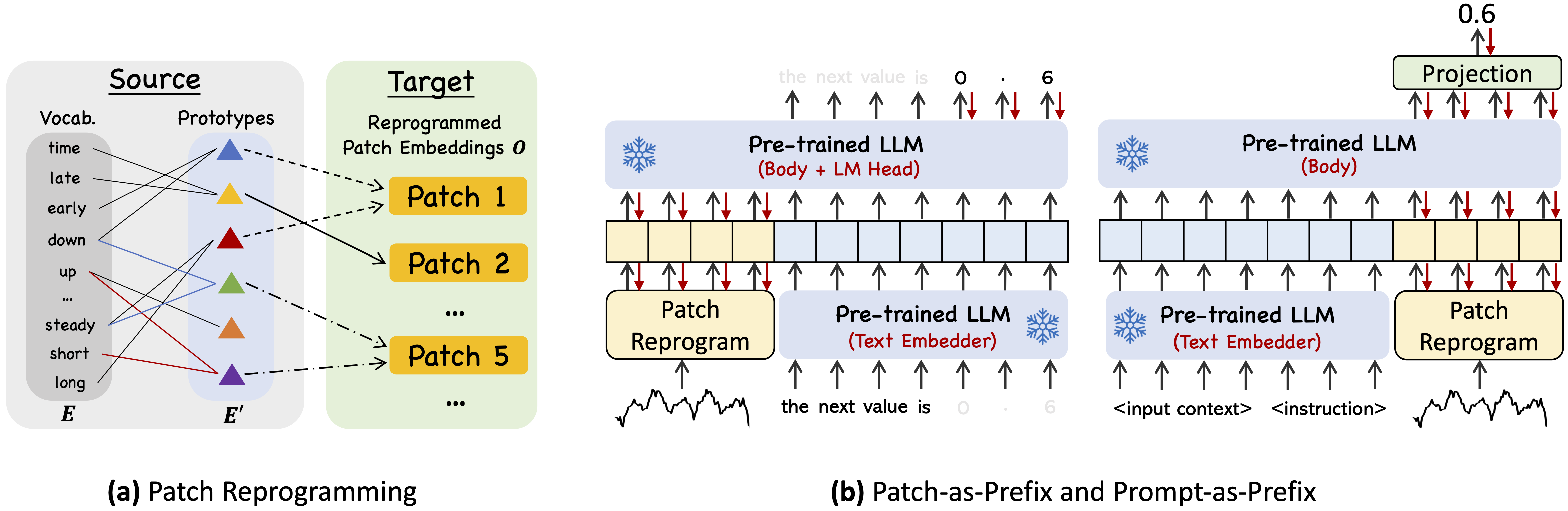

Time-LLM เป็นกรอบการเขียนโปรแกรม reprogramming เพื่อเปลี่ยน LLMS สำหรับการพยากรณ์อนุกรมเวลาทั่วไปด้วยแบบจำลองภาษาแบ็คโบนยังคงอยู่เหมือนเดิม โดยเฉพาะอย่างยิ่งเราแสดงให้เห็นว่าการวิเคราะห์อนุกรมเวลา (เช่นการพยากรณ์) สามารถใช้เป็น "งานภาษา" อื่นที่สามารถแก้ไขได้อย่างมีประสิทธิภาพโดย LLM นอกชั้นวาง

ใช้ Python 3.11 จาก Miniconda

เพื่อติดตั้งการพึ่งพาทั้งหมด:

pip install -r requirements.txt

คุณสามารถเข้าถึงชุดข้อมูลที่ประมวลผลล่วงหน้าได้จาก [Google Drive] จากนั้นวางเนื้อหาที่ดาวน์โหลดไว้ใต้ ./dataset

./dataset./scripts scripts ตัวอย่างเช่นคุณสามารถประเมินชุดข้อมูล ETT ได้โดย: bash ./scripts/TimeLLM_ETTh1.sh bash ./scripts/TimeLLM_ETTh2.sh bash ./scripts/TimeLLM_ETTm1.sh bash ./scripts/TimeLLM_ETTm2.sh โปรดดูที่ run_main.py , run_m4.py และ run_pretrain.py สำหรับคำอธิบายโดยละเอียดของแต่ละพารามิเตอร์

1, Timemixer ++: เครื่องรูปแบบอนุกรมเวลาทั่วไปสำหรับการวิเคราะห์การทำนายสากล ใน Arxiv 2024. [GitHub repo]

ผู้เขียน : Shiyu Wang, Jiawei Li, Xiaoming Shi, Zhou Ye, Baichuan Mo, Wenze Lin, Shengtong Ju, Zhixuan Chu, Ming Jin

@article { wang2024timemixer++ ,

title = { TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis } ,

author = { Wang, Shiyu and Li, Jiawei and Shi, Xiaoming and Ye, Zhou and Mo, Baichuan and Lin, Wenze and Ju, Shengtong and Chu, Zhixuan and Jin, Ming } ,

journal = { arXiv preprint arXiv:2410.16032 } ,

year = { 2024 }

}2, โมเดลพื้นฐานสำหรับการวิเคราะห์อนุกรมเวลา: การสอนและการสำรวจ ใน KDD 2024

ผู้เขียน : Yuxuan Liang, Haomin Wen, Yuqi Nie, Yushan Jiang, Ming Jin, Dongjin Song, Shirui Pan, Qingsong Wen*

@inproceedings { liang2024foundation ,

title = { Foundation models for time series analysis: A tutorial and survey } ,

author = { Liang, Yuxuan and Wen, Haomin and Nie, Yuqi and Jiang, Yushan and Jin, Ming and Song, Dongjin and Pan, Shirui and Wen, Qingsong } ,

booktitle = { ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2024) } ,

year = { 2024 }

}3, ตำแหน่งกระดาษ: โมเดลภาษาขนาดใหญ่สามารถบอกเราเกี่ยวกับการวิเคราะห์อนุกรมเวลา ใน ICML 2024

ผู้เขียน : หมิงจิน, ยาสานจาง, เหว่ยเฉิน, เคซินจาง, Yuxuan เหลียง*, บินหยาง, Jindong Wang, Shirui Pan, Qingsong Wen*

@inproceedings { jin2024position ,

title = { Position Paper: What Can Large Language Models Tell Us about Time Series Analysis } ,

author = { Ming Jin and Yifan Zhang and Wei Chen and Kexin Zhang and Yuxuan Liang and Bin Yang and Jindong Wang and Shirui Pan and Qingsong Wen } ,

booktitle = { International Conference on Machine Learning (ICML 2024) } ,

year = { 2024 }

}4, โมเดลขนาดใหญ่สำหรับอนุกรมเวลาและข้อมูล spatio-temporal: การสำรวจและแนวโน้ม ใน Arxiv 2023. [GitHub repo]

ผู้เขียน : หมิงจิน, Qingsong Wen*, Yuxuan Liang, Chaoli Zhang, Siqiao Xue, Xue Wang, James Zhang, Yi Wang, Haifeng Chen, Xiaoli Li Xiong (IEEE Fellow)

@article { jin2023lm4ts ,

title = { Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook } ,

author = { Ming Jin and Qingsong Wen and Yuxuan Liang and Chaoli Zhang and Siqiao Xue and Xue Wang and James Zhang and Yi Wang and Haifeng Chen and Xiaoli Li and Shirui Pan and Vincent S. Tseng and Yu Zheng and Lei Chen and Hui Xiong } ,

journal = { arXiv preprint arXiv:2310.10196 } ,

year = { 2023 }

}5, Transformers In Time Series: การสำรวจ ใน ijcai 2023. [GitHub repo]

ผู้เขียน : Qingsong Wen, Tian Zhou, Chaoli Zhang, Weiqi Chen, Ziqing MA, Junchi Yan, เหลียงซัน

@inproceedings { wen2023transformers ,

title = { Transformers in time series: A survey } ,

author = { Wen, Qingsong and Zhou, Tian and Zhang, Chaoli and Chen, Weiqi and Ma, Ziqing and Yan, Junchi and Sun, Liang } ,

booktitle = { International Joint Conference on Artificial Intelligence(IJCAI) } ,

year = { 2023 }

}6, Timemixer: การผสม multiscale decomposale สำหรับการพยากรณ์อนุกรมเวลา ใน ICLR 2024. [GitHub repo]

ผู้เขียน : Shiyu Wang, Haixu Wu, Xiaoming Shi, Tengge Hu, Huakun Luo, Lintao MA, James Y. Zhang, Jun Zhou

@inproceedings { wang2023timemixer ,

title = { TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting } ,

author = { Wang, Shiyu and Wu, Haixu and Shi, Xiaoming and Hu, Tengge and Luo, Huakun and Ma, Lintao and Zhang, James Y and ZHOU, JUN } ,

booktitle = { International Conference on Learning Representations (ICLR) } ,

year = { 2024 }

}การใช้งานของเราปรับเวลา Series-Series-Library และ OFA (GPT4TS) เป็นฐานรหัสและมีการแก้ไขอย่างกว้างขวางตามวัตถุประสงค์ของเรา เราขอขอบคุณผู้เขียนที่แบ่งปันการใช้งานและทรัพยากรที่เกี่ยวข้อง