[ペーパーページ] [YouTube Talk 1] [YouTube Talk 2] [Medium Blog]

[機械の中心の中国の解釈] [量子ビットの中国の解釈] [時系列人間の中国の解釈] [AIアルゴリズムキッチンの中国の解釈] [Zhihu中国の解釈の中国の解釈]

?間違いを見つけたり、提案がある場合はお知らせください!

?このリソースが役立つと思われる場合は、このリポジトリを主演させ、調査を引用することを検討してください。

@inproceedings{jin2023time,

title={{Time-LLM}: Time series forecasting by reprogramming large language models},

author={Jin, Ming and Wang, Shiyu and Ma, Lintao and Chu, Zhixuan and Zhang, James Y and Shi, Xiaoming and Chen, Pin-Yu and Liang, Yuxuan and Li, Yuan-Fang and Pan, Shirui and Wen, Qingsong},

booktitle={International Conference on Learning Representations (ICLR)},

year={2024}

}

ニュース(2024年8月):Time-LLMは、Ximou Optimization Technology Co.、Ltd。(XMO)で太陽、風、気象予測のために採用されています。

ニュース(2024年5月):Time-llmはNeuralForeCastに含まれています。寄稿者@jqgohと@marcopeixに感謝します!

News (2024年3月):Time-LLMは、幅広い言語モデルを時系列予測に再利用するための一般的なフレームワークとして役立つようにアップグレードされました。現在、llama-7bをサポートするデフォルトで、2つの追加の小型PLM(GPT-2とBERT)との互換性が含まれています。 --llm_modelと--llm_dimを調整するだけで、バックボーンを切り替えます。

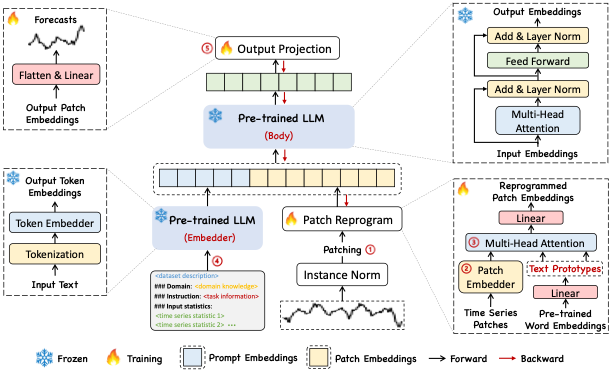

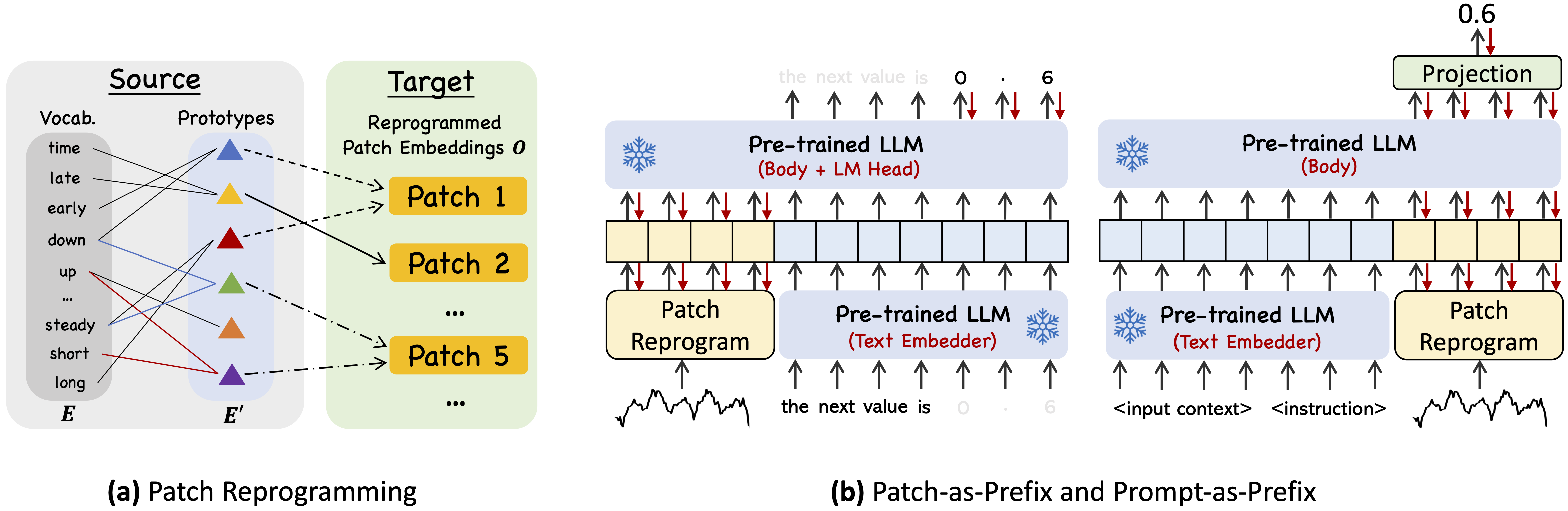

Time-LLMは、バックボーン言語モデルを伴う一般的な時系列予測のLLMSを再利用するための再プログラミングフレームワークです。特に、時系列分析(例えば、予測)は、既製のLLMによって効果的に取り組むことができるもう1つの「言語タスク」としてキャストできることを示しています。

MinicondaのPython 3.11を使用します

すべての依存関係をインストールするには:

pip install -r requirements.txt

[Google Drive]から事前に処理されたデータセットにアクセスし、ダウンロードしたコンテンツを./datasetの下に配置できます。

./dataset datasetの下に配置します./scripts scriptsの下でデモンストレーション目的のために5つの実験スクリプトを提供します。たとえば、以下でETTデータセットで評価できます。 bash ./scripts/TimeLLM_ETTh1.sh bash ./scripts/TimeLLM_ETTh2.sh bash ./scripts/TimeLLM_ETTm1.sh bash ./scripts/TimeLLM_ETTm2.sh各ハイパーパラメーターの詳細な説明については、 run_main.py 、 run_m4.py 、 run_pretrain.pyを参照してください。

1、Timemixer ++: ARXIV 2024の普遍的な予測分析のための一般的な時系列パターンマシン。 [Github Repo]

著者:Shiyu Wang、Jiawei Li、Xiaoming Shi、Zhou Ye、Baichuan MO、Wenze Lin、Shengtong JU、Zhixuan Chu、Ming Jin

@article { wang2024timemixer++ ,

title = { TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis } ,

author = { Wang, Shiyu and Li, Jiawei and Shi, Xiaoming and Ye, Zhou and Mo, Baichuan and Lin, Wenze and Ju, Shengtong and Chu, Zhixuan and Jin, Ming } ,

journal = { arXiv preprint arXiv:2410.16032 } ,

year = { 2024 }

}2、時系列分析のための基礎モデル: KDD 2024のチュートリアルと調査。

著者:Yuxuan Liang、Haomin Wen、Yuqi Nie、Yushan Jiang、Ming Jin、Dongjin Song、Shirui Pan、Qingsong Wen*

@inproceedings { liang2024foundation ,

title = { Foundation models for time series analysis: A tutorial and survey } ,

author = { Liang, Yuxuan and Wen, Haomin and Nie, Yuqi and Jiang, Yushan and Jin, Ming and Song, Dongjin and Pan, Shirui and Wen, Qingsong } ,

booktitle = { ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2024) } ,

year = { 2024 }

}3、ポジションペーパー:大規模な言語モデルは、 ICML 2024で時系列分析について教えてくれます。

著者:Ming Jin、Yifan Zhang、Wei Chen、Kexin Zhang、Yuxuan Liang*、Bin Yang、Jindong Wang、Shirui Pan、Qingsong Wen*

@inproceedings { jin2024position ,

title = { Position Paper: What Can Large Language Models Tell Us about Time Series Analysis } ,

author = { Ming Jin and Yifan Zhang and Wei Chen and Kexin Zhang and Yuxuan Liang and Bin Yang and Jindong Wang and Shirui Pan and Qingsong Wen } ,

booktitle = { International Conference on Machine Learning (ICML 2024) } ,

year = { 2024 }

}4、時系列および時空間データの大規模なモデル: Arxiv 2023の調査と見通し。[Github Repo]

著者:Ming Jin、Qingsong Wen*、Yuxuan Liang、Chaoli Zhang、Siqiao Xue、Xue Wang、James Zhang、Yi Wang、Haifeng Chen、Xiaoli Li(Ieee Fellow)、Shirui Pan*、Vincent S. Tseng(Ieee fellow)、yu zheng perfer) Xiong(IEEEフェロー)

@article { jin2023lm4ts ,

title = { Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook } ,

author = { Ming Jin and Qingsong Wen and Yuxuan Liang and Chaoli Zhang and Siqiao Xue and Xue Wang and James Zhang and Yi Wang and Haifeng Chen and Xiaoli Li and Shirui Pan and Vincent S. Tseng and Yu Zheng and Lei Chen and Hui Xiong } ,

journal = { arXiv preprint arXiv:2310.10196 } ,

year = { 2023 }

}5、時系列の変圧器:調査、IJCAI 2023。[Github Repo]

著者:Qingsong Wen、Tian Zhou、Chaoli Zhang、Weiqi Chen、Ziqing MA、Junchi Yan、Liang Sun

@inproceedings { wen2023transformers ,

title = { Transformers in time series: A survey } ,

author = { Wen, Qingsong and Zhou, Tian and Zhang, Chaoli and Chen, Weiqi and Ma, Ziqing and Yan, Junchi and Sun, Liang } ,

booktitle = { International Joint Conference on Artificial Intelligence(IJCAI) } ,

year = { 2023 }

}6、 Timemixer:ICLR 2024の時系列予測の分解可能なマルチスケールミキシング。 [Github Repo]

著者:Shiyu Wang、Haixu Wu、Xiaoming Shi、Tengge Hu、Huakun Luo、Lintao MA、James Y. Zhang、Jun Zhou

@inproceedings { wang2023timemixer ,

title = { TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting } ,

author = { Wang, Shiyu and Wu, Haixu and Shi, Xiaoming and Hu, Tengge and Luo, Huakun and Ma, Lintao and Zhang, James Y and ZHOU, JUN } ,

booktitle = { International Conference on Learning Representations (ICLR) } ,

year = { 2024 }

}私たちの実装は、時系列のライブラリーとOFA(GPT4TS)をコードベースに適応させ、それを私たちの目的に広範囲に変更しました。実装と関連するリソースを共有してくれた著者に感謝します。