[Página de papel] [YouTube Talk 1] [YouTube Talk 2] [Blog Medio]

[Interpretación china del corazón de la máquina] [Interpretación china de bits cuánticos] [Interpretación china de series de tiempo humanos] [Interpretación china de la cocina de algoritmo de IA] [Interpretación china de la interpretación china de Zhihu]

? ¡Háganos saber si descubre un error o tiene alguna sugerencia!

? Si encuentra útil este recurso, considere protagonizar este repositorio y cite nuestra investigación:

@inproceedings{jin2023time,

title={{Time-LLM}: Time series forecasting by reprogramming large language models},

author={Jin, Ming and Wang, Shiyu and Ma, Lintao and Chu, Zhixuan and Zhang, James Y and Shi, Xiaoming and Chen, Pin-Yu and Liang, Yuxuan and Li, Yuan-Fang and Pan, Shirui and Wen, Qingsong},

booktitle={International Conference on Learning Representations (ICLR)},

year={2024}

}

Noticias (agosto de 2024): Time-LLM ha sido adoptado por Ximou Optimization Technology Co., Ltd. (XMO) para el pronóstico solar, eólico y meteorológico.

Noticias (mayo de 2024): Time-LLM se ha incluido en NeuralForecast. ¡Un agradecimiento especial al colaborador @JQGOH y @Marcopeix!

Noticias (marzo de 2024): Time-LLM se ha actualizado para servir como un marco general para reutilizar una amplia gama de modelos de idiomas para el pronóstico de series temporales. Ahora es predeterminado a soportar LLAMA-7B e incluye compatibilidad con dos PLM más pequeños adicionales (GPT-2 y BERT). Simplemente ajuste --llm_model y --llm_dim para cambiar de backbones.

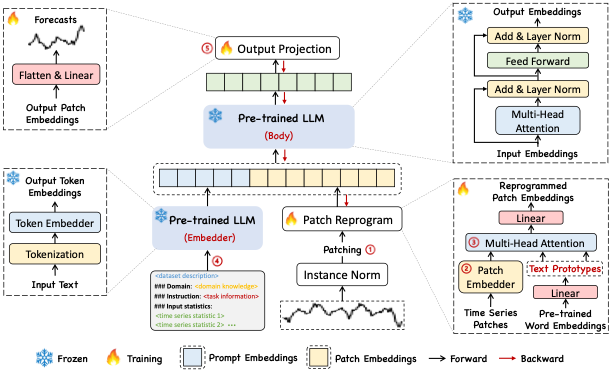

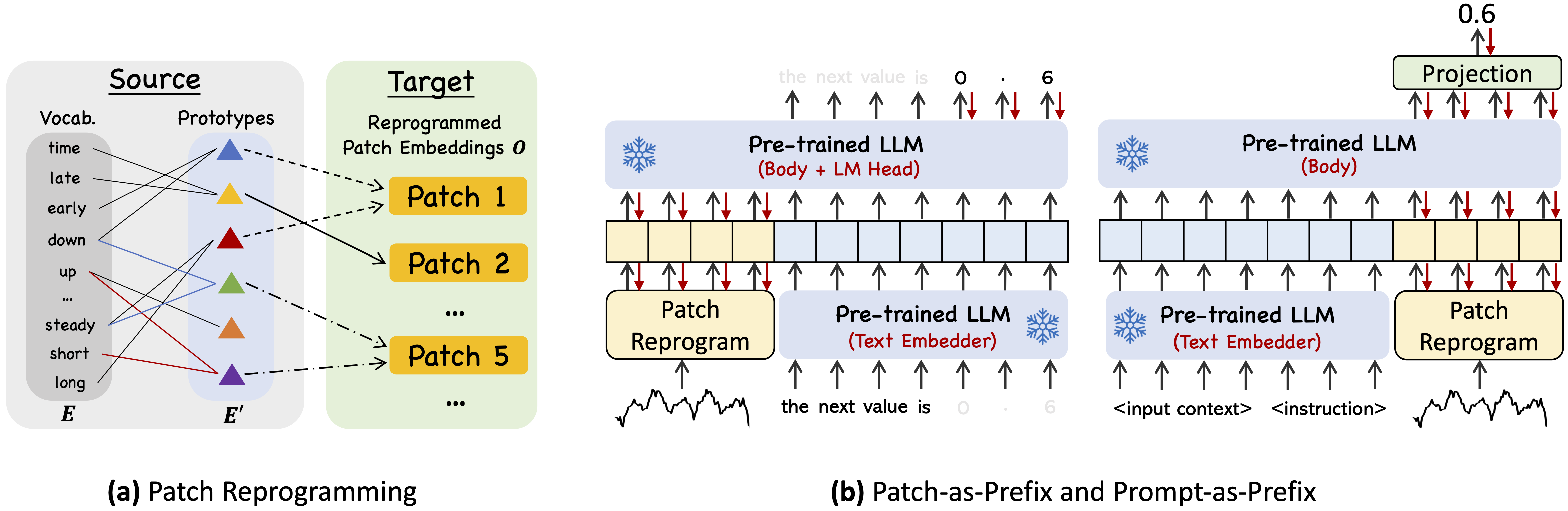

Time-LLM es un marco de reprogramación para reutilizar LLM para el pronóstico general de las series temporales con los modelos de lenguaje de la columna vertebral mantenidos intactos. En particular, mostramos que el análisis de series de tiempo (por ejemplo, pronóstico) se puede emitir como otra "tarea de lenguaje" que puede abordarse de manera efectiva por un LLM listo para usar.

Use Python 3.11 de Miniconda

Para instalar todas las dependencias:

pip install -r requirements.txt

Puede acceder a los conjuntos de datos preprocesados de pozo desde [Google Drive], luego colocar el contenido descargado en ./dataset

./dataset./scripts . Por ejemplo, puede evaluar en conjuntos de datos ETT por: bash ./scripts/TimeLLM_ETTh1.sh bash ./scripts/TimeLLM_ETTh2.sh bash ./scripts/TimeLLM_ETTm1.sh bash ./scripts/TimeLLM_ETTm2.sh Consulte run_main.py , run_m4.py y run_pretrain.py para obtener la descripción detallada de cada hiperparámetro.

1, Timemixer ++: una máquina de patrones de series temporales generales para el análisis predictivo universal , en ARXIV 2024. [Repo de GitHub]

Autores : Shiyu Wang, Jiawei Li, Xiaoming Shi, Zhou Ye, Baichuan MO, Wenze Lin, Shengtong JU, Zhixuan Chu, Ming Jin

@article { wang2024timemixer++ ,

title = { TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis } ,

author = { Wang, Shiyu and Li, Jiawei and Shi, Xiaoming and Ye, Zhou and Mo, Baichuan and Lin, Wenze and Ju, Shengtong and Chu, Zhixuan and Jin, Ming } ,

journal = { arXiv preprint arXiv:2410.16032 } ,

year = { 2024 }

}2, Modelos de base para el análisis de series de tiempo: un tutorial y encuesta , en KDD 2024.

Autores : Yuxuan Liang, Haomin Wen, Yuqi Nie, Yushan Jiang, Ming Jin, Dongjin Song, Shirui Pan, Qingsong Wen*

@inproceedings { liang2024foundation ,

title = { Foundation models for time series analysis: A tutorial and survey } ,

author = { Liang, Yuxuan and Wen, Haomin and Nie, Yuqi and Jiang, Yushan and Jin, Ming and Song, Dongjin and Pan, Shirui and Wen, Qingsong } ,

booktitle = { ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2024) } ,

year = { 2024 }

}3, Documento de posición: ¿Qué pueden decirnos los modelos de idiomas grandes sobre el análisis de series de tiempo , en ICML 2024?

Autores : Ming Jin, Yifan Zhang, Wei Chen, Kexin Zhang, Yuxuan Liang*, Bin Yang, Jindong Wang, Shirui Pan, Qingsong Wen*

@inproceedings { jin2024position ,

title = { Position Paper: What Can Large Language Models Tell Us about Time Series Analysis } ,

author = { Ming Jin and Yifan Zhang and Wei Chen and Kexin Zhang and Yuxuan Liang and Bin Yang and Jindong Wang and Shirui Pan and Qingsong Wen } ,

booktitle = { International Conference on Machine Learning (ICML 2024) } ,

year = { 2024 }

}4, Modelos grandes para series de tiempo y datos espacio-temporales: una encuesta y perspectiva , en ARXIV 2023. [Repo de GitHub]

Authors : Ming Jin, Qingsong Wen*, Yuxuan Liang, Chaoli Zhang, Siqiao Xue, Xue Wang, James Zhang, Yi Wang, Haifeng Chen, Xiaoli Li (IEEE Fellow), Shirui Pan*, Vincent S. Tseng (IEEE Fellow), Yu Zheng (IEEE Fellow), Lei Chen (IEEE Fellow), Hui Xiong (IEEE Fellow)

@article { jin2023lm4ts ,

title = { Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook } ,

author = { Ming Jin and Qingsong Wen and Yuxuan Liang and Chaoli Zhang and Siqiao Xue and Xue Wang and James Zhang and Yi Wang and Haifeng Chen and Xiaoli Li and Shirui Pan and Vincent S. Tseng and Yu Zheng and Lei Chen and Hui Xiong } ,

journal = { arXiv preprint arXiv:2310.10196 } ,

year = { 2023 }

}5, Transformers in Time Series: una encuesta , en IJCAI 2023. [Repo de Github]

Autores : Qingsong Wen, Tian Zhou, Chaoli Zhang, Weiqi Chen, Ziqing MA, Junchi Yan, Liang Sun

@inproceedings { wen2023transformers ,

title = { Transformers in time series: A survey } ,

author = { Wen, Qingsong and Zhou, Tian and Zhang, Chaoli and Chen, Weiqi and Ma, Ziqing and Yan, Junchi and Sun, Liang } ,

booktitle = { International Joint Conference on Artificial Intelligence(IJCAI) } ,

year = { 2023 }

}6, Timemixer: Mezcla multiescala descomponible para el pronóstico de series de tiempo , en ICLR 2024. [Repo de GitHub]

Autores : Shiyu Wang, Haixu Wu, Xiaoming Shi, Tengge Hu, Huakun Luo, Lintao MA, James Y. Zhang, Jun Zhou

@inproceedings { wang2023timemixer ,

title = { TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting } ,

author = { Wang, Shiyu and Wu, Haixu and Shi, Xiaoming and Hu, Tengge and Luo, Huakun and Ma, Lintao and Zhang, James Y and ZHOU, JUN } ,

booktitle = { International Conference on Learning Representations (ICLR) } ,

year = { 2024 }

}Nuestra implementación adapta la biblioteca de series de tiempo y OFA (GPT4TS) como la base de código y la ha modificado ampliamente a nuestros propósitos. Agradecemos a los autores por compartir sus implementaciones y recursos relacionados.