[Papierseite] [YouTube Talk 1] [YouTube Talk 2] [Medium Blog]

[Chinesische Interpretation des Herzens der Maschine] [chinesische Interpretation von Quantenbits] [Chinesische Interpretation von Zeitreihen Menschen] [Chinesische Interpretation der KI -Algorithmusküche] [Chinesische Interpretation der chinesischen Interpretation von Zhihu]

? Bitte lassen Sie uns wissen, wenn Sie einen Fehler herausfinden oder Vorschläge haben!

? Wenn Sie diese Ressource hilfreich finden, sollten Sie dieses Repository in Betracht ziehen und unsere Forschung anführen:

@inproceedings{jin2023time,

title={{Time-LLM}: Time series forecasting by reprogramming large language models},

author={Jin, Ming and Wang, Shiyu and Ma, Lintao and Chu, Zhixuan and Zhang, James Y and Shi, Xiaoming and Chen, Pin-Yu and Liang, Yuxuan and Li, Yuan-Fang and Pan, Shirui and Wen, Qingsong},

booktitle={International Conference on Learning Representations (ICLR)},

year={2024}

}

Nachrichten (August 2024): Time-LlM wurde von Ximou Optimization Technology Co., Ltd. (XMO) für Solar-, Wind- und Wettervorhersagen übernommen.

Nachrichten (Mai 2024): ZeitlM wurde in NeuralForecast aufgenommen. Besonderer Dank geht an den Mitarbeiter @jqgoh und @Marcopeix!

Nachrichten (März 2024): Time-LlM wurde als allgemeiner Rahmen für die Umwandlung eines breiten Spektrums von Sprachmodellen auf Zeitreihenprognosen verbessert. Es wird nun standardmäßig unterstützt, um LLAMA-7B zu unterstützen und die Kompatibilität mit zwei zusätzlichen kleineren PLMs (GPT-2 und Bert) zu enthalten. Einfach einstellen --llm_model und --llm_dim um die Rückgrat zu wechseln.

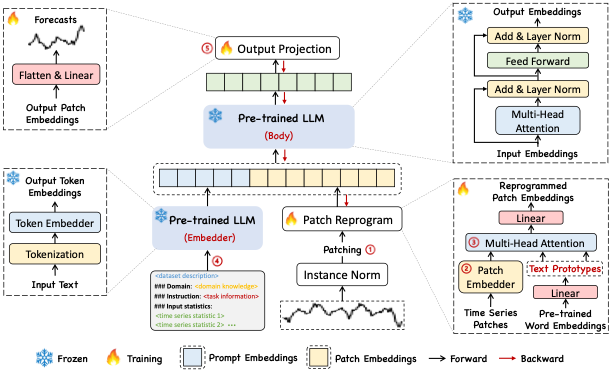

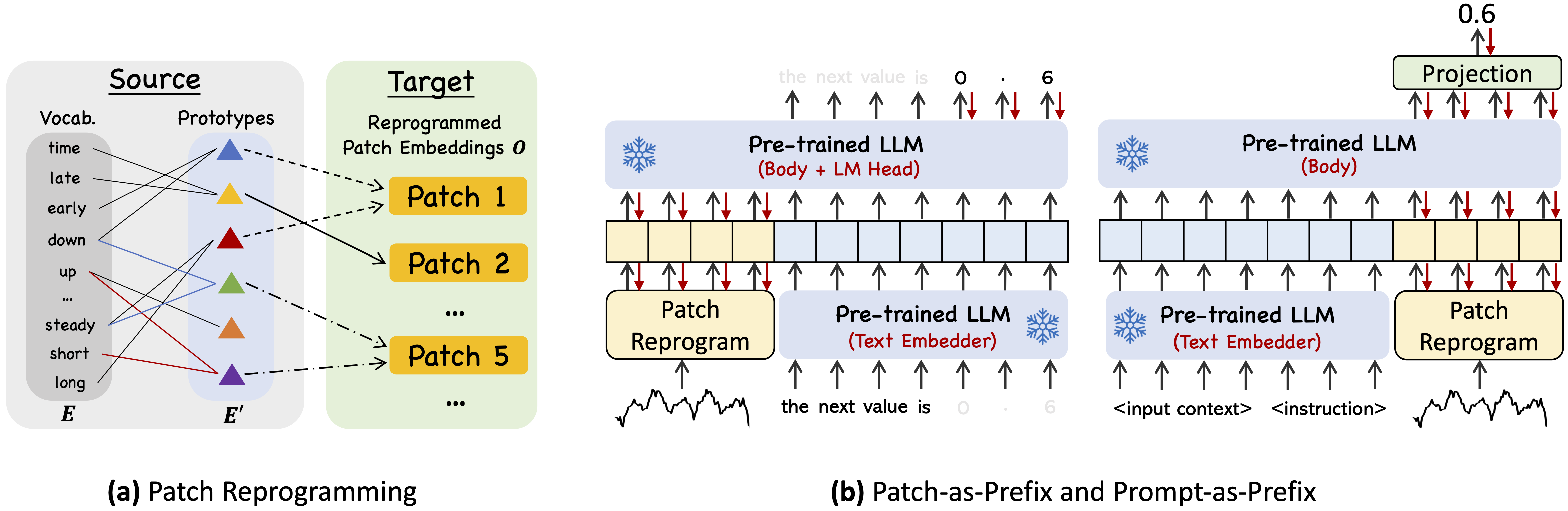

Time-LlM ist ein Reprogrammierungsrahmen, um LLMs für die allgemeine Zeitreihenprognose mit den Backbone-Sprachmodellen intakt zu repurpurieren. Insbesondere zeigen wir, dass die Zeitreihenanalyse (z. B. Prognose) als eine weitere "Sprachaufgabe" gegossen werden kann, die effektiv von einem llm-self-LLM angegangen werden kann.

Verwenden Sie Python 3.11 von Miniconda

So installieren Sie alle Abhängigkeiten:

pip install -r requirements.txt

Sie können auf die gut vorverarbeiteten Datensätze von [Google Drive] zugreifen und dann den heruntergeladenen Inhalt unter ./dataset platzieren

./dataset./scripts . Beispielsweise können Sie auf ETT -Datensätzen bewerten nach: bash ./scripts/TimeLLM_ETTh1.sh bash ./scripts/TimeLLM_ETTh2.sh bash ./scripts/TimeLLM_ETTm1.sh bash ./scripts/TimeLLM_ETTm2.sh Weitere Informationen finden Sie unter run_main.py , run_m4.py und run_pretrain.py um die detaillierte Beschreibung jedes Hyperparameters zu erhalten.

1, Timemixer ++: Eine allgemeine Zeitreihenmustermaschine für die universelle Vorhersageanalyse in ARXIV 2024. [Github Repo]

Autoren : Shiyu Wang, Jiawei Li, Xiaoming Shi, Zhou Ye, Baichuan MO, Wenze Lin, Shengtong Ju, Zhixuan Chu, Ming Jin

@article { wang2024timemixer++ ,

title = { TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis } ,

author = { Wang, Shiyu and Li, Jiawei and Shi, Xiaoming and Ye, Zhou and Mo, Baichuan and Lin, Wenze and Ju, Shengtong and Chu, Zhixuan and Jin, Ming } ,

journal = { arXiv preprint arXiv:2410.16032 } ,

year = { 2024 }

}2, Grundmodelle für die Zeitreihenanalyse: Ein Tutorial und eine Umfrage in KDD 2024.

Autoren : Yuxuan Liang, Haomin Wen, Yuqi Nie, Yushan Jiang, Ming Jin, Dongjin Song, Shirui Pan, Qingsong Wen*

@inproceedings { liang2024foundation ,

title = { Foundation models for time series analysis: A tutorial and survey } ,

author = { Liang, Yuxuan and Wen, Haomin and Nie, Yuqi and Jiang, Yushan and Jin, Ming and Song, Dongjin and Pan, Shirui and Wen, Qingsong } ,

booktitle = { ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2024) } ,

year = { 2024 }

}3, Positionspapier: Was können Großsprachenmodelle über die Zeitreihenanalyse in ICML 2024 erzählen.

Autoren : Ming Jin, Yifan Zhang, Wei Chen, Kexin Zhang, Yuxuan Liang*, bin Yang, Jindong Wang, Shirui Pan, Qingsong Wen*

@inproceedings { jin2024position ,

title = { Position Paper: What Can Large Language Models Tell Us about Time Series Analysis } ,

author = { Ming Jin and Yifan Zhang and Wei Chen and Kexin Zhang and Yuxuan Liang and Bin Yang and Jindong Wang and Shirui Pan and Qingsong Wen } ,

booktitle = { International Conference on Machine Learning (ICML 2024) } ,

year = { 2024 }

}4, Große Modelle für Zeitreihen und räumlich-zeitliche Daten: eine Umfrage und eine Aussicht , in Arxiv 2023. [Github Repo]

Authors : Ming Jin, Qingsong Wen*, Yuxuan Liang, Chaoli Zhang, Siqiao Xue, Xue Wang, James Zhang, Yi Wang, Haifeng Chen, Xiaoli Li (IEEE Fellow), Shirui Pan*, Vincent S. Tseng (IEEE Fellow), Yu Zheng (IEEE Fellow), Lei Chen (IEEE Fellow), Hui Xiong (IEEE Fellow)

@article { jin2023lm4ts ,

title = { Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook } ,

author = { Ming Jin and Qingsong Wen and Yuxuan Liang and Chaoli Zhang and Siqiao Xue and Xue Wang and James Zhang and Yi Wang and Haifeng Chen and Xiaoli Li and Shirui Pan and Vincent S. Tseng and Yu Zheng and Lei Chen and Hui Xiong } ,

journal = { arXiv preprint arXiv:2310.10196 } ,

year = { 2023 }

}5, Transformers in Time Series: Eine Umfrage in IJCAI 2023. [Github Repo]

Autoren : Qingsong Wen, Tian Zhou, Chaoli Zhang, Weiqi Chen, Ziqing MA, Junchi Yan, Liang Sun

@inproceedings { wen2023transformers ,

title = { Transformers in time series: A survey } ,

author = { Wen, Qingsong and Zhou, Tian and Zhang, Chaoli and Chen, Weiqi and Ma, Ziqing and Yan, Junchi and Sun, Liang } ,

booktitle = { International Joint Conference on Artificial Intelligence(IJCAI) } ,

year = { 2023 }

}6, Timemixer: Zerlegtes Multiskale -Mischung für die Zeitreihenprognose , in ICLR 2024. [Github Repo]

Autoren : Shiyu Wang, Haixu Wu, Xiaoming Shi, Tengge Hu, Huakun Luo, Lintao MA, James Y. Zhang, Jun Zhou

@inproceedings { wang2023timemixer ,

title = { TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting } ,

author = { Wang, Shiyu and Wu, Haixu and Shi, Xiaoming and Hu, Tengge and Luo, Huakun and Ma, Lintao and Zhang, James Y and ZHOU, JUN } ,

booktitle = { International Conference on Learning Representations (ICLR) } ,

year = { 2024 }

}Unsere Implementierung passt die Zeitreihen-Bibliothek und OFA (GPT4Ts) als Codebasis an und hat sie ausgiebig für unsere Zwecke geändert. Wir danken den Autoren für die Teile ihrer Implementierungen und verwandten Ressourcen.