[Page papier] [YouTube Talk 1] [YouTube Talk 2] [Blog moyen]

[Interprétation chinoise du cœur de la machine] [Interprétation chinoise des bits quantiques] [Interprétation chinoise des séries chronologiques humains] [Interprétation chinoise de l'algorithme de cuisine] [Interprétation chinoise de l'interprétation chinoise de Zhihu]

? Veuillez nous faire savoir si vous découvrez une erreur ou si vous avez des suggestions!

? Si vous trouvez cette ressource utile, veuillez considérer pour jouer ce référentiel et citer nos recherches:

@inproceedings{jin2023time,

title={{Time-LLM}: Time series forecasting by reprogramming large language models},

author={Jin, Ming and Wang, Shiyu and Ma, Lintao and Chu, Zhixuan and Zhang, James Y and Shi, Xiaoming and Chen, Pin-Yu and Liang, Yuxuan and Li, Yuan-Fang and Pan, Shirui and Wen, Qingsong},

booktitle={International Conference on Learning Representations (ICLR)},

year={2024}

}

News (août 2024): le temps-llm a été adopté par Ximou Optimization Technology Co., Ltd. (XMO) pour les prévisions solaires, éoliennes et météorologiques.

NOUVELLES (mai 2024): le temps-llm a été inclus dans NeuralForecast. Un merci spécial au contributeur @jqgoh et @marcopeix!

NOUVELLES (mars 2024): le temps-llm a été mis à niveau pour servir de cadre général pour réutiliser un large éventail de modèles linguistiques à la prévision des séries chronologiques. Il est désormais par défaut pour prendre en charge LLAMA-7B et inclure la compatibilité avec deux PLM plus petits supplémentaires (GPT-2 et Bert). Ajustez simplement --llm_model et --llm_dim pour changer de squelette.

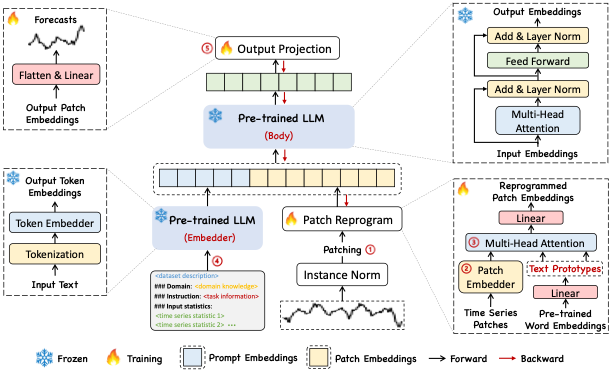

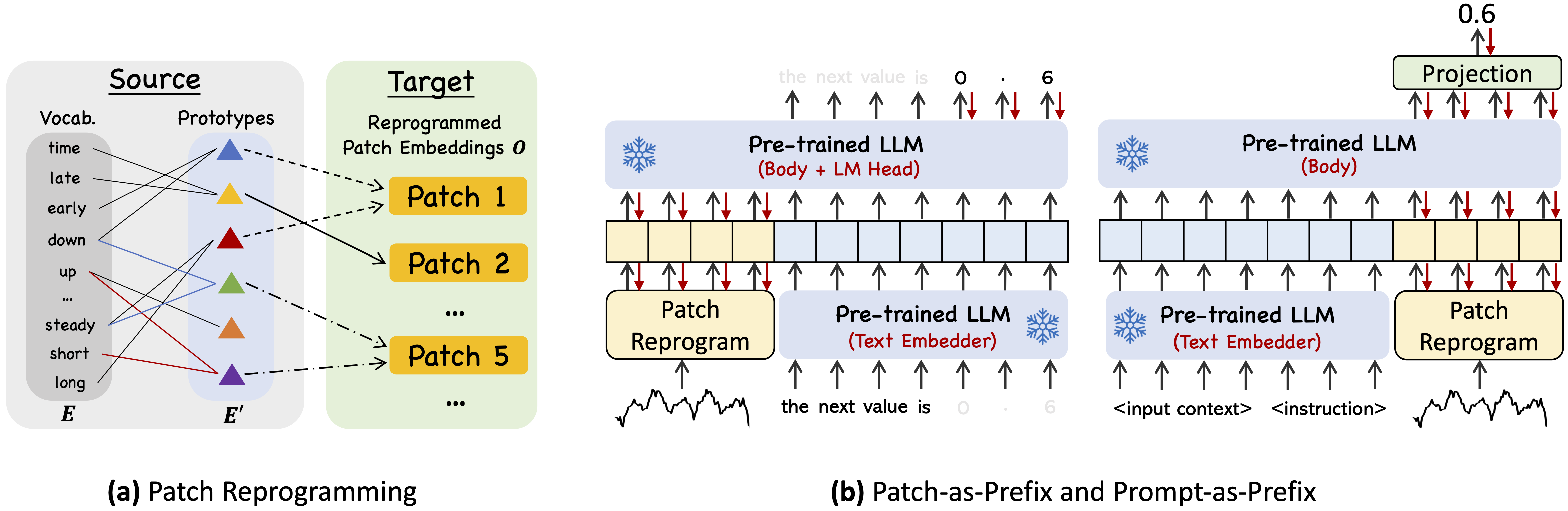

Time-llm est un cadre de reprogrammation pour réutiliser les LLM pour les prévisions de séries chronologiques générales avec les modèles de langage de l'épine dorsale maintenus intacts. Notamment, nous montrons que l'analyse des séries chronologiques (par exemple, les prévisions) peut être lancée comme une autre "tâche de langue" qui peut être terminée efficacement par un LLM standard.

Utilisez Python 3.11 de Miniconda

Pour installer toutes les dépendances:

pip install -r requirements.txt

Vous pouvez accéder aux ensembles de données bien prétraités à partir de [Google Drive], puis placer le contenu téléchargé sous ./dataset

./dataset./scripts . Par exemple, vous pouvez évaluer les ensembles de données ETT par: bash ./scripts/TimeLLM_ETTh1.sh bash ./scripts/TimeLLM_ETTh2.sh bash ./scripts/TimeLLM_ETTm1.sh bash ./scripts/TimeLLM_ETTm2.sh Veuillez vous référer à run_main.py , run_m4.py et run_pretrain.py pour la description détaillée de chaque hyperparamètre.

1, Timemixer ++: une machine de modèle de série temporelle générale pour l'analyse prédictive universelle , dans Arxiv 2024. [Github Repo]

Auteurs : Shiyu Wang, Jiawei Li, XiaoMing Shi, Zhou Ye, Baichuan MO, Wenze Lin, Shengtong JU, Zhixuan Chu, Ming Jin

@article { wang2024timemixer++ ,

title = { TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis } ,

author = { Wang, Shiyu and Li, Jiawei and Shi, Xiaoming and Ye, Zhou and Mo, Baichuan and Lin, Wenze and Ju, Shengtong and Chu, Zhixuan and Jin, Ming } ,

journal = { arXiv preprint arXiv:2410.16032 } ,

year = { 2024 }

}2, Modèles de fondation pour l'analyse des séries chronologiques: un tutoriel et une enquête , dans KDD 2024.

Auteurs : Yuxuan Liang, Haomin Wen, Yuqi Nie, Yushan Jiang, Ming Jin, Dongjin Song, Shirui Pan, Qingsong Wen *

@inproceedings { liang2024foundation ,

title = { Foundation models for time series analysis: A tutorial and survey } ,

author = { Liang, Yuxuan and Wen, Haomin and Nie, Yuqi and Jiang, Yushan and Jin, Ming and Song, Dongjin and Pan, Shirui and Wen, Qingsong } ,

booktitle = { ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2024) } ,

year = { 2024 }

}3, Position Papier: Que peuvent nous dire les modèles de grande langue sur l'analyse des séries chronologiques , dans ICML 2024.

Auteurs : Ming Jin, Yifan Zhang, Wei Chen, Kexin Zhang, Yuxuan Liang *, Bin Yang, Jindong Wang, Shirui Pan, Qingsong Wen *

@inproceedings { jin2024position ,

title = { Position Paper: What Can Large Language Models Tell Us about Time Series Analysis } ,

author = { Ming Jin and Yifan Zhang and Wei Chen and Kexin Zhang and Yuxuan Liang and Bin Yang and Jindong Wang and Shirui Pan and Qingsong Wen } ,

booktitle = { International Conference on Machine Learning (ICML 2024) } ,

year = { 2024 }

}4, grands modèles de séries chronologiques et de données spatio-temporelles: une enquête et des perspectives , dans Arxiv 2023. [Github Repo]

Auteurs : Ming Jin, Qingsong Wen *, Yuxuan Liang, Chaoli Zhang, Siqiao Xue, Xue Wang, James Zhang, Yi Wang, Haifeng Chen, Xiaoli Li (IEEE Fellow), Shiui Pan *, Vincent S. TSeng (IEEE Fellow), Yu Zheng Hui Xiong (IEEE Fellow)

@article { jin2023lm4ts ,

title = { Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook } ,

author = { Ming Jin and Qingsong Wen and Yuxuan Liang and Chaoli Zhang and Siqiao Xue and Xue Wang and James Zhang and Yi Wang and Haifeng Chen and Xiaoli Li and Shirui Pan and Vincent S. Tseng and Yu Zheng and Lei Chen and Hui Xiong } ,

journal = { arXiv preprint arXiv:2310.10196 } ,

year = { 2023 }

}5, Transformers in Chime Series: A Survey , dans Ijcai 2023. [Github Repo]

Auteurs : Qingsong Wen, Tian Zhou, Chaoli Zhang, Weiqi Chen, Ziqing MA, Junchi Yan, Liang Sun

@inproceedings { wen2023transformers ,

title = { Transformers in time series: A survey } ,

author = { Wen, Qingsong and Zhou, Tian and Zhang, Chaoli and Chen, Weiqi and Ma, Ziqing and Yan, Junchi and Sun, Liang } ,

booktitle = { International Joint Conference on Artificial Intelligence(IJCAI) } ,

year = { 2023 }

}6, Timemixer: mélange multi-échelle décomposable pour les prévisions de séries chronologiques , dans ICLR 2024. [Github Repo]

Auteurs : Shiyu Wang, Haixu Wu, Xiaoming Shi, Tengge HU, Huakun Luo, Lintao MA, James Y. Zhang, Jun Zhou

@inproceedings { wang2023timemixer ,

title = { TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting } ,

author = { Wang, Shiyu and Wu, Haixu and Shi, Xiaoming and Hu, Tengge and Luo, Huakun and Ma, Lintao and Zhang, James Y and ZHOU, JUN } ,

booktitle = { International Conference on Learning Representations (ICLR) } ,

year = { 2024 }

}Notre implémentation adapte la série temporelle-bibliothèque et OFA (GPT4TS) comme base de code et l'a largement modifiée à nos fins. Nous remercions les auteurs d'avoir partagé leurs implémentations et leurs ressources connexes.