[صفحة الورق] [YouTube Talk 1] [YouTube Talk 2] [مدونة متوسطة]

[التفسير الصيني لقلب الآلة] [التفسير الصيني للبت الكموميات] [التفسير الصيني للسلاسل الزمنية البشر] [التفسير الصيني لمطبخ خوارزمية الذكاء الاصطناعي] [التفسير الصيني للتفسير الصيني Zhihu]

؟ يرجى إعلامنا إذا اكتشفت خطأ أو لديك أي اقتراحات!

؟ إذا وجدت هذه الموارد مفيدة ، فيرجى النظر في دور البطولة في هذا المستودع واستشهد بحوثنا:

@inproceedings{jin2023time,

title={{Time-LLM}: Time series forecasting by reprogramming large language models},

author={Jin, Ming and Wang, Shiyu and Ma, Lintao and Chu, Zhixuan and Zhang, James Y and Shi, Xiaoming and Chen, Pin-Yu and Liang, Yuxuan and Li, Yuan-Fang and Pan, Shirui and Wen, Qingsong},

booktitle={International Conference on Learning Representations (ICLR)},

year={2024}

}

News (أغسطس 2024): تم اعتماد Time-LLM من قبل شركة Ximou Optimization Technology Co. ، Ltd. (XMO) للتنبؤ بالطاقة الشمسية والرياح والطقس.

الأخبار (مايو 2024): تم تضمين الوقت في NeuralForecast. شكر خاص للمساهم jqgoh و marcopeix!

الأخبار (مارس 2024): تمت ترقية الوقت المحدد لتكون بمثابة إطار عام لإعادة استخدام مجموعة واسعة من نماذج اللغة إلى التنبؤ بسلسلة زمنية. إنها الآن افتراضية لدعم LLAMA-7B وتشمل التوافق مع اثنين من PLMs أصغر إضافية (GPT-2 و BERT). ما عليك سوى ضبط --llm_model و --llm_dim لتبديل العمود الفقري.

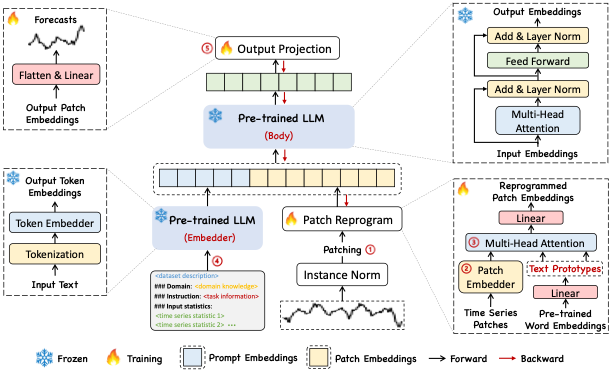

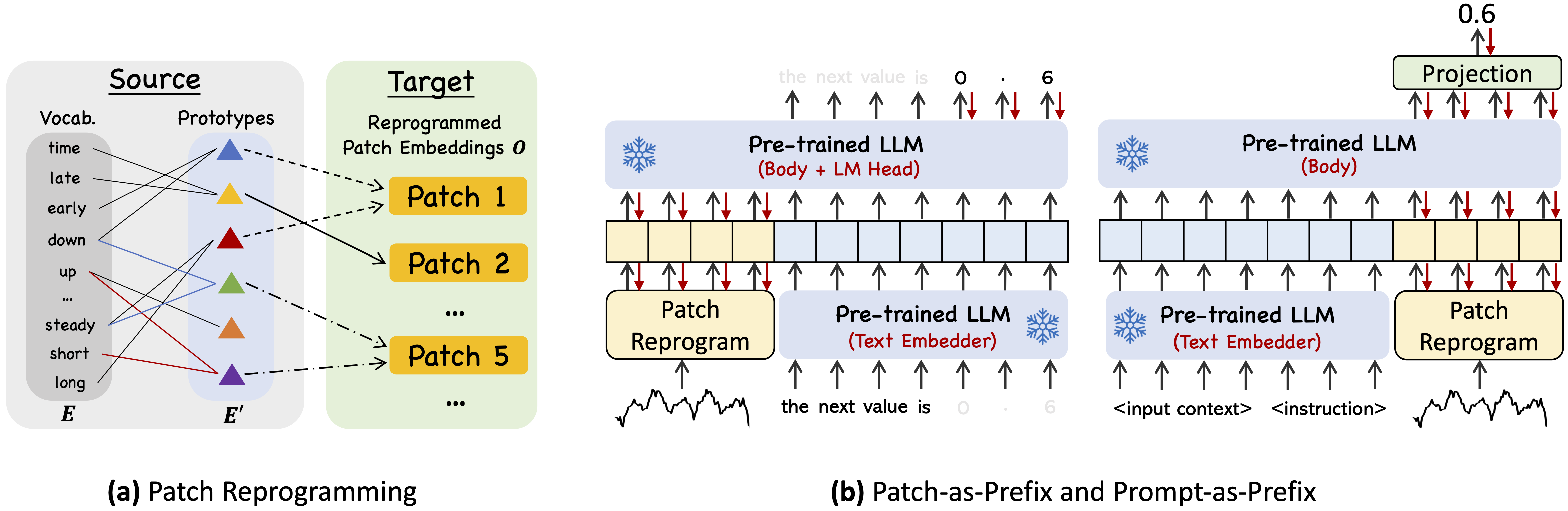

Time-LLM هو إطار إعادة برمجة لإعادة استخدام LLMs للتنبؤ بالسلسلة الزمنية العامة مع نماذج اللغة الفقارية المحفوظة سليمة. والجدير بالذكر أن تحليل السلاسل الزمنية (على سبيل المثال ، التنبؤ) يمكن إلقاؤه على أنه "مهمة لغة أخرى" يمكن معالجتها بفعالية من قبل LLM على الرف.

استخدم Python 3.11 من Miniconda

لتثبيت جميع التبعيات:

pip install -r requirements.txt

يمكنك الوصول إلى مجموعات البيانات التي تم تجهيزها مسبقًا من [Google Drive] ، ثم ضع المحتويات التي تم تنزيلها تحت ./dataset

./dataset./scripts . على سبيل المثال ، يمكنك تقييم مجموعات بيانات ETT بواسطة: bash ./scripts/TimeLLM_ETTh1.sh bash ./scripts/TimeLLM_ETTh2.sh bash ./scripts/TimeLLM_ETTm1.sh bash ./scripts/TimeLLM_ETTm2.sh يرجى الرجوع إلى run_main.py و run_m4.py و run_pretrain.py للحصول على وصف مفصل لكل مقياس فرط.

1 ، Timemixer ++: آلة نمط السلاسل الزمنية العامة للتحليل التنبئي الشامل ، في Arxiv 2024. [Github repo]

المؤلفون : شيو وانغ ، جياوي لي ، شياومنغ شي ، تشو يي ، بايتشوان مو ، وينزي لين ، شينغتونج جو ، تشو تشو ، مينغ جين

@article { wang2024timemixer++ ,

title = { TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis } ,

author = { Wang, Shiyu and Li, Jiawei and Shi, Xiaoming and Ye, Zhou and Mo, Baichuan and Lin, Wenze and Ju, Shengtong and Chu, Zhixuan and Jin, Ming } ,

journal = { arXiv preprint arXiv:2410.16032 } ,

year = { 2024 }

}2 ، نماذج مؤسسة لتحليل السلاسل الزمنية: تعليمي ومسح ، في KDD 2024.

المؤلفون : Yuxuan Liang ، Haomin Wen ، Yuqi Nie ، Yushan Jiang ، Ming Jin ، Dongjin Song ، Shirui Pan ، Qingsong Wen*

@inproceedings { liang2024foundation ,

title = { Foundation models for time series analysis: A tutorial and survey } ,

author = { Liang, Yuxuan and Wen, Haomin and Nie, Yuqi and Jiang, Yushan and Jin, Ming and Song, Dongjin and Pan, Shirui and Wen, Qingsong } ,

booktitle = { ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2024) } ,

year = { 2024 }

}3 ، ورقة الموضع: ما الذي يمكن أن تخبرنا نماذج اللغة الكبيرة عن تحليل السلاسل الزمنية ، في ICML 2024.

المؤلفون : Ming Jin ، Yifan Zhang ، Wei Chen ، Kexin Zhang ، Yuxuan Liang*، Bin Yang ، Jindong Wang ، Shirui Pan ، Qingsong Wen*

@inproceedings { jin2024position ,

title = { Position Paper: What Can Large Language Models Tell Us about Time Series Analysis } ,

author = { Ming Jin and Yifan Zhang and Wei Chen and Kexin Zhang and Yuxuan Liang and Bin Yang and Jindong Wang and Shirui Pan and Qingsong Wen } ,

booktitle = { International Conference on Machine Learning (ICML 2024) } ,

year = { 2024 }

}4 ، نماذج كبيرة للسلسلة الزمنية والبيانات المكانية والزمانية: مسح والتوقعات ، في Arxiv 2023. [Github repo]

المؤلفون : Ming Jin ، Qingsong Wen*، Yuxuan Liang ، Chaoli Zhang ، Siqiao Xue ، Xue Wang ، James Zhang ، Yi Wang ، Haifeng Chen ، Xiaoli Li (IEEE Family) ، Shirui Pan* هوي شيونج (زميل IEEE)

@article { jin2023lm4ts ,

title = { Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook } ,

author = { Ming Jin and Qingsong Wen and Yuxuan Liang and Chaoli Zhang and Siqiao Xue and Xue Wang and James Zhang and Yi Wang and Haifeng Chen and Xiaoli Li and Shirui Pan and Vincent S. Tseng and Yu Zheng and Lei Chen and Hui Xiong } ,

journal = { arXiv preprint arXiv:2310.10196 } ,

year = { 2023 }

}5 ، المحولات في السلسلة الزمنية: مسح ، في IJCAI 2023. [Github repo]

المؤلفون : Qingsong Wen ، Tian Zhou ، Chaoli Zhang ، Weiqi Chen ، Ziqing MA ، Junchi Yan ، Liang Sun

@inproceedings { wen2023transformers ,

title = { Transformers in time series: A survey } ,

author = { Wen, Qingsong and Zhou, Tian and Zhang, Chaoli and Chen, Weiqi and Ma, Ziqing and Yan, Junchi and Sun, Liang } ,

booktitle = { International Joint Conference on Artificial Intelligence(IJCAI) } ,

year = { 2023 }

}6 ، Timemixer: خلط متعدد القابلات للتنبؤ بسلسلة زمنية ، في ICLR 2024. [Github repo]

المؤلفون : شيو وانغ ، هايكسو وو ، شياومنغ شي ، تينغج هو ، هواكون لوو ، لينتيو ما ، جيمس ي. تشانغ ، جون تشو

@inproceedings { wang2023timemixer ,

title = { TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting } ,

author = { Wang, Shiyu and Wu, Haixu and Shi, Xiaoming and Hu, Tengge and Luo, Huakun and Ma, Lintao and Zhang, James Y and ZHOU, JUN } ,

booktitle = { International Conference on Learning Representations (ICLR) } ,

year = { 2024 }

}يتكيف تنفيذنا لمكتبات السلسلة الزمنية و OFA (GPT4TS) كقاعدة التعليمات البرمجية وقاموا بتعديلها على نطاق واسع إلى أغراضنا. نشكر المؤلفين على مشاركة تطبيقاتهم والموارد ذات الصلة.