[Paper Page] [YouTube Talk 1] [YouTube Talk 2] [Medium Blog]

[Китайская интерпретация сердца машины] [Китайская интерпретация квантовых битов] [Китайская интерпретация времени людей] [китайская интерпретация кухни алгоритма ИИ] [Китайская интерпретация китайской интерпретации Чхиху]

? Пожалуйста, дайте нам знать, если вы узнаете ошибку или у вас есть какие -либо предложения!

? Если вы обнаружите этот ресурс полезным, пожалуйста, рассмотрите этот репозиторий и процитируйте наше исследование:

@inproceedings{jin2023time,

title={{Time-LLM}: Time series forecasting by reprogramming large language models},

author={Jin, Ming and Wang, Shiyu and Ma, Lintao and Chu, Zhixuan and Zhang, James Y and Shi, Xiaoming and Chen, Pin-Yu and Liang, Yuxuan and Li, Yuan-Fang and Pan, Shirui and Wen, Qingsong},

booktitle={International Conference on Learning Representations (ICLR)},

year={2024}

}

Новости (август 2024 г.): Time-LLM был принят Ximou Optimization Technology Co., Ltd. (XMO) для солнечной, ветровой и погодной прогнозирования.

Новости (май 2024 г.): Time-LLM был включен в NeuralForeCast. Особое спасибо участнику @jqgoh и @marcopeix!

Новости (март 2024 г.): Time-LLM была обновлена, чтобы служить общей рамки для перепрофилирования широкого спектра языковых моделей для прогнозирования временных рядов. Теперь он по умолчанию поддерживает Llama-7B и включает в себя совместимость с двумя дополнительными меньшими PLMS (GPT-2 и BERT). Просто настраивайте --llm_model и --llm_dim , чтобы переключить основы.

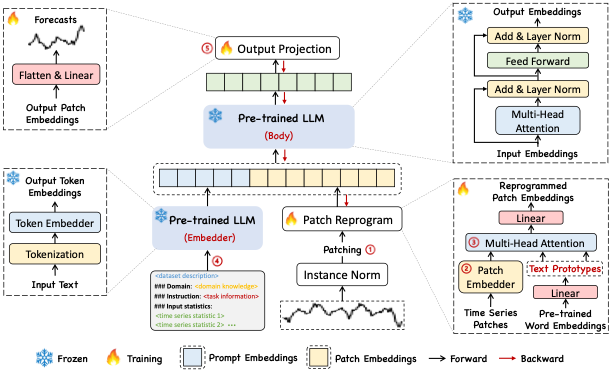

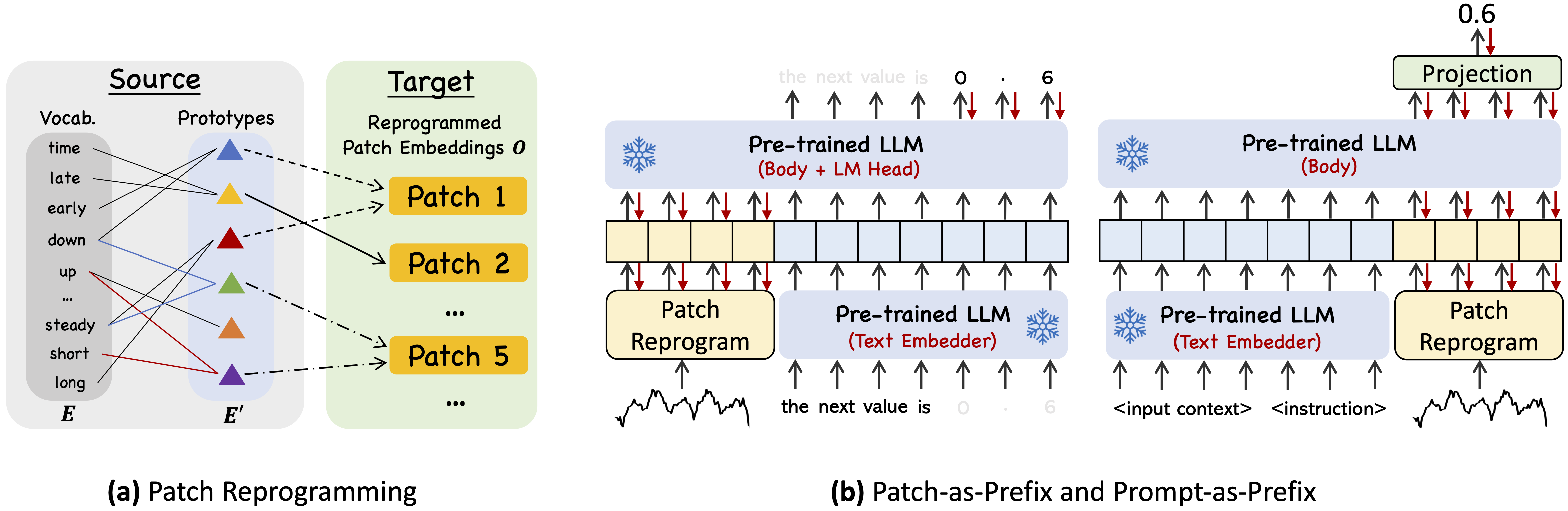

Time-LLM-это структура перепрограммирования для перепропрограммирования LLM для общего прогнозирования временных рядов с помощью моделей языка основных целей, которые остаются нетронутыми. Примечательно, что мы показываем, что анализ временных рядов (например, прогнозирование) может быть выполнена как еще одна «языковая задача», которая может быть эффективно решена с помощью готового LLM.

Используйте Python 3.11 от Miniconda

Чтобы установить все зависимости:

pip install -r requirements.txt

Вы можете получить доступ к хорошо обработанным наборам данных из [Google Drive], а затем разместить загруженное содержимое под ./dataset

./dataset./scripts Например, вы можете оценить наборы данных ETT с помощью: bash ./scripts/TimeLLM_ETTh1.sh bash ./scripts/TimeLLM_ETTh2.sh bash ./scripts/TimeLLM_ETTm1.sh bash ./scripts/TimeLLM_ETTm2.sh Пожалуйста, обратитесь к run_main.py , run_m4.py и run_pretrain.py для подробного описания каждого гиперпараметра.

1, Timemixer ++: общий шаблон временных рядов для универсального прогнозного анализа , в Arxiv 2024. [Github Repo]

Авторы : Шию Ванг, Цзявей Ли, Сюминг Ши, Чжоу Ю, Бачуань Мо, Вензе Лин, Шенгтонг Джу, Чжиксуань Чу, Мин Цзинь

@article { wang2024timemixer++ ,

title = { TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis } ,

author = { Wang, Shiyu and Li, Jiawei and Shi, Xiaoming and Ye, Zhou and Mo, Baichuan and Lin, Wenze and Ju, Shengtong and Chu, Zhixuan and Jin, Ming } ,

journal = { arXiv preprint arXiv:2410.16032 } ,

year = { 2024 }

}2, Фонд -модели для анализа временных рядов: учебник и опрос , в KDD 2024.

Авторы : Юксюан Лян, Хаомин Вен, Юки Ни, Юшан Цзян, Мин Цзинь, Дунджин Сонг, Шируи Пан, Цинсонг Вэнь*

@inproceedings { liang2024foundation ,

title = { Foundation models for time series analysis: A tutorial and survey } ,

author = { Liang, Yuxuan and Wen, Haomin and Nie, Yuqi and Jiang, Yushan and Jin, Ming and Song, Dongjin and Pan, Shirui and Wen, Qingsong } ,

booktitle = { ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2024) } ,

year = { 2024 }

}3, Позиционная статья: что могут рассказать о больших языковых моделях об анализе временных рядов , в ICML 2024.

Авторы : Мин Джин, Ифан Чжан, Вэй Чен, Кексин Чжан, Юксюан Лян*, бин Ян, Джиндонг Ван, Шируи Пан, Цинсонг Вэнь*

@inproceedings { jin2024position ,

title = { Position Paper: What Can Large Language Models Tell Us about Time Series Analysis } ,

author = { Ming Jin and Yifan Zhang and Wei Chen and Kexin Zhang and Yuxuan Liang and Bin Yang and Jindong Wang and Shirui Pan and Qingsong Wen } ,

booktitle = { International Conference on Machine Learning (ICML 2024) } ,

year = { 2024 }

}4, большие модели для временных рядов и пространственно-временных данных: опрос и перспективы , в Arxiv 2023. [Github Repo]

Authors : Ming Jin, Qingsong Wen*, Yuxuan Liang, Chaoli Zhang, Siqiao Xue, Xue Wang, James Zhang, Yi Wang, Haifeng Chen, Xiaoli Li (IEEE Fellow), Shirui Pan*, Vincent S. Tseng (IEEE Fellow), Yu Zheng (IEEE Fellow), Lei Chen (IEEE Fellow), Hui Xiong (парень из IEEE)

@article { jin2023lm4ts ,

title = { Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook } ,

author = { Ming Jin and Qingsong Wen and Yuxuan Liang and Chaoli Zhang and Siqiao Xue and Xue Wang and James Zhang and Yi Wang and Haifeng Chen and Xiaoli Li and Shirui Pan and Vincent S. Tseng and Yu Zheng and Lei Chen and Hui Xiong } ,

journal = { arXiv preprint arXiv:2310.10196 } ,

year = { 2023 }

}5, Трансформеры во временных рядах: опрос , в IJCAI 2023. [GitHub Repo]

Авторы : Qingsong Wen, Tian Zhou, Chaoli Zhang, Weiqi Chen, Ziqing MA, Junchi Yan, Liang Sun

@inproceedings { wen2023transformers ,

title = { Transformers in time series: A survey } ,

author = { Wen, Qingsong and Zhou, Tian and Zhang, Chaoli and Chen, Weiqi and Ma, Ziqing and Yan, Junchi and Sun, Liang } ,

booktitle = { International Joint Conference on Artificial Intelligence(IJCAI) } ,

year = { 2023 }

}6, Timemixer: разложение многомасштабного микширования для прогнозирования временных рядов , в ICLR 2024. [Github Repo]

Авторы : Шию Ванг, Хайсу Ву, Сяминг Ши, Тенгге Ху, Хуакун Луо, Линтао М.А., Джеймс Я. Чжан, Джун Чжоу

@inproceedings { wang2023timemixer ,

title = { TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting } ,

author = { Wang, Shiyu and Wu, Haixu and Shi, Xiaoming and Hu, Tengge and Luo, Huakun and Ma, Lintao and Zhang, James Y and ZHOU, JUN } ,

booktitle = { International Conference on Learning Representations (ICLR) } ,

year = { 2024 }

}Наша реализация адаптирует временной серии и OFA (GPT4TS) в качестве базы кода и широко изменяла ее в наших целях. Мы благодарим авторов за то, что они поделились их реализациями и связанными с ними ресурсами.