[종이 페이지] [YouTube Talk 1] [YouTube Talk 2] [중간 블로그]

[기계의 심장에 대한 중국어 해석] [양자 비트의 중국 해석] [시계열 인간의 중국 해석] [AI 알고리즘 주방의 중국 해석] [Zhihu 중국 해석의 중국 해석]

? 실수를 발견하거나 제안이 있으면 알려주십시오!

? 이 리소스가 도움이되면이 리포지토리를 별표로 표시하고 우리의 연구를 인용하십시오.

@inproceedings{jin2023time,

title={{Time-LLM}: Time series forecasting by reprogramming large language models},

author={Jin, Ming and Wang, Shiyu and Ma, Lintao and Chu, Zhixuan and Zhang, James Y and Shi, Xiaoming and Chen, Pin-Yu and Liang, Yuxuan and Li, Yuan-Fang and Pan, Shirui and Wen, Qingsong},

booktitle={International Conference on Learning Representations (ICLR)},

year={2024}

}

뉴스 (2024 년 8 월) : Time-LLM은 Ximou Optimization Technology Co., Ltd. (XMO)가 태양, 바람 및 일기 예보를 위해 채택했습니다.

뉴스 (2024 년 5 월) : Time-LLM이 Neuralforecast에 포함되었습니다. 기고자 @jqgoh 및 @marcopeix에게 특별한 감사를드립니다!

뉴스 (2024 년 3 월) : Time-LLM은 광범위한 언어 모델을 시계열 예측에 대한 일반적인 프레임 워크 역할을하도록 업그레이드되었습니다. 이제 LLAMA-7B를 지원하는 기본값을 기본적으로 수행하고 2 개의 추가 더 작은 PLM (GPT-2 및 BERT)과의 호환성을 포함합니다. 백본을 전환하기 위해 --llm_model 및 --llm_dim 조정하기 만하면됩니다.

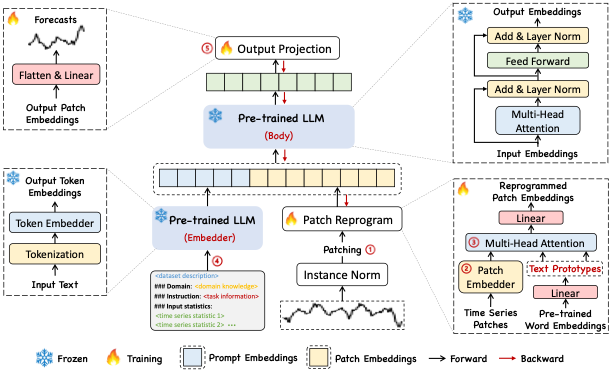

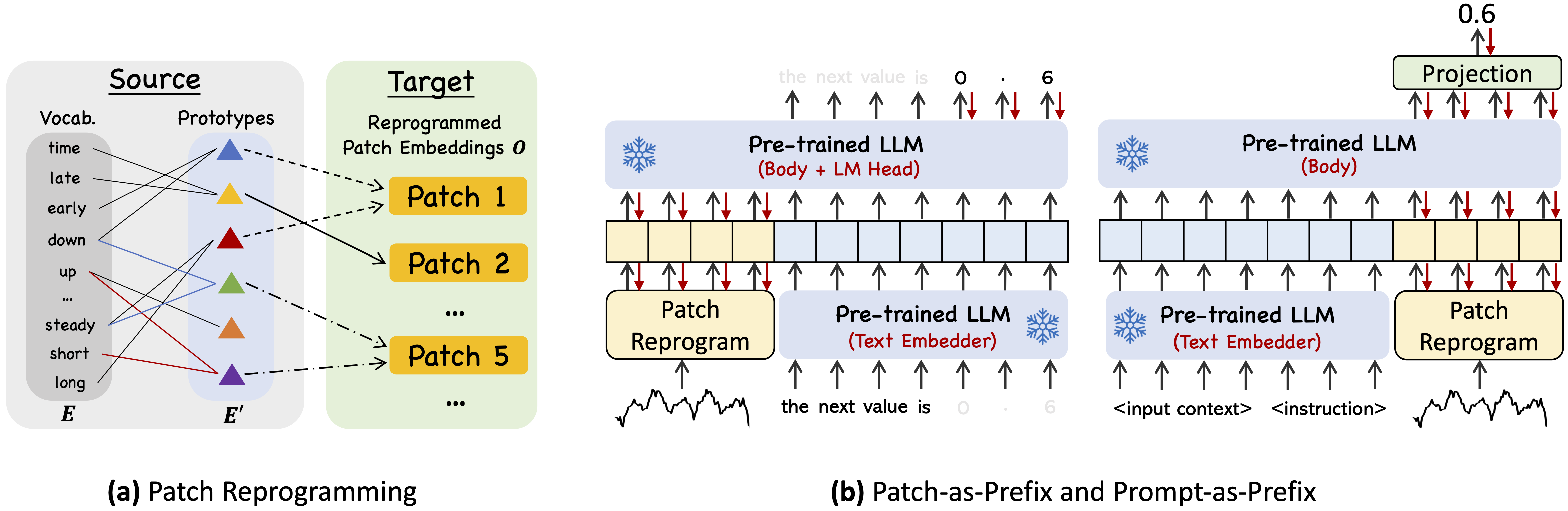

Time-LLM은 백본 언어 모델을 그대로 유지하여 일반 시계열 예측을 위해 LLM을 용도 변경하기위한 재 프로그래밍 프레임 워크입니다. 특히, 우리는 시계열 분석 (예 : 예측)이 상용 LLM에 의해 효과적으로 해결 될 수있는 또 다른 "언어 작업"으로 캐스팅 될 수 있음을 보여줍니다.

Miniconda에서 Python 3.11을 사용하십시오

모든 종속성을 설치하려면 :

pip install -r requirements.txt

[Google Drive]에서 잘 사전 처리 된 데이터 세트에 액세스 한 다음 다운로드 된 내용을 ./dataset 아래에 배치 할 수 있습니다.

./dataset 아래에 배치하십시오./scripts 에서 데모 목적을위한 5 가지 실험 스크립트를 제공합니다. 예를 들어, ETT 데이터 세트에서 다음을 평가할 수 있습니다. bash ./scripts/TimeLLM_ETTh1.sh bash ./scripts/TimeLLM_ETTh2.sh bash ./scripts/TimeLLM_ETTm1.sh bash ./scripts/TimeLLM_ETTm2.sh 각 하이퍼 파라미터에 대한 자세한 설명은 run_main.py , run_m4.py 및 run_pretrain.py 를 참조하십시오.

1, Timemixer ++ : ARXIV 2024에서 보편적 예측 분석을위한 일반적인 시계열 패턴 기계 . [GitHub Repo]

저자 : Shiyu Wang, Jiawei Li, Xiaoming Shi, Zhou Ye, Baichuan MO, Wenze Lin, Shengtong Ju, Zhixuan Chu, Ming Jin

@article { wang2024timemixer++ ,

title = { TimeMixer++: A General Time Series Pattern Machine for Universal Predictive Analysis } ,

author = { Wang, Shiyu and Li, Jiawei and Shi, Xiaoming and Ye, Zhou and Mo, Baichuan and Lin, Wenze and Ju, Shengtong and Chu, Zhixuan and Jin, Ming } ,

journal = { arXiv preprint arXiv:2410.16032 } ,

year = { 2024 }

}2, 시계열 분석을위한 기초 모델 : KDD 2024의 튜토리얼 및 설문 조사.

저자 : Yuxuan Liang, Haomin Wen, Yuqi Nie, Yushan Jiang, Ming Jin, Dongjin Song, Shirui Pan, Qingsong Wen*

@inproceedings { liang2024foundation ,

title = { Foundation models for time series analysis: A tutorial and survey } ,

author = { Liang, Yuxuan and Wen, Haomin and Nie, Yuqi and Jiang, Yushan and Jin, Ming and Song, Dongjin and Pan, Shirui and Wen, Qingsong } ,

booktitle = { ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2024) } ,

year = { 2024 }

}3, 위치 종이 : ICML 2024에서 대형 언어 모델이 시계열 분석에 대해 알려줄 수있는 것은 무엇입니까 ?

저자 : Ming Jin, Yifan Zhang, Wei Chen, Kexin Zhang, Yuxuan Liang*, Bin Yang, Jindong Wang, Shirui Pan, Qingsong Wen*

@inproceedings { jin2024position ,

title = { Position Paper: What Can Large Language Models Tell Us about Time Series Analysis } ,

author = { Ming Jin and Yifan Zhang and Wei Chen and Kexin Zhang and Yuxuan Liang and Bin Yang and Jindong Wang and Shirui Pan and Qingsong Wen } ,

booktitle = { International Conference on Machine Learning (ICML 2024) } ,

year = { 2024 }

}4, 시계열 및 시공간 데이터에 대한 대형 모델 : ARXIV 2023의 설문 조사 및 전망. [Github Repo]

저자 : Ming Jin, Qingsong Wen*, Yuxuan Liang, Chaoli Zhang, Siqiao Xue, Xue Wang, James Zhang, Yi Wang, Haifeng Chen, Xiaoli Li (IEEE Fellow), Shirui Pan*, Vincent S. Tseng (IEEE Fellow), Yu Zheng (ieee) Hui Xiong (IEEE Fellow)

@article { jin2023lm4ts ,

title = { Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook } ,

author = { Ming Jin and Qingsong Wen and Yuxuan Liang and Chaoli Zhang and Siqiao Xue and Xue Wang and James Zhang and Yi Wang and Haifeng Chen and Xiaoli Li and Shirui Pan and Vincent S. Tseng and Yu Zheng and Lei Chen and Hui Xiong } ,

journal = { arXiv preprint arXiv:2310.10196 } ,

year = { 2023 }

}5, 시계열의 변압기 : IJCAI 2023의 설문 조사 . [Github Repo]

저자 : Qingsong Wen, Tian Zhou, Chaoli Zhang, Weiqi Chen, Ziqing MA, Junchi Yan, Liang Sun

@inproceedings { wen2023transformers ,

title = { Transformers in time series: A survey } ,

author = { Wen, Qingsong and Zhou, Tian and Zhang, Chaoli and Chen, Weiqi and Ma, Ziqing and Yan, Junchi and Sun, Liang } ,

booktitle = { International Joint Conference on Artificial Intelligence(IJCAI) } ,

year = { 2023 }

}6, Timemixer : ICLR 2024에서 시계열 예측을위한 분해용 멀티 스케일 믹싱 . [Github Repo]

저자 : Shiyu Wang, Haixu Wu, Xiaoming Shi, Tengge Hu, Huakun Luo, Lintao MA, James Y. Zhang, Jun Zhou

@inproceedings { wang2023timemixer ,

title = { TimeMixer: Decomposable Multiscale Mixing for Time Series Forecasting } ,

author = { Wang, Shiyu and Wu, Haixu and Shi, Xiaoming and Hu, Tengge and Luo, Huakun and Ma, Lintao and Zhang, James Y and ZHOU, JUN } ,

booktitle = { International Conference on Learning Representations (ICLR) } ,

year = { 2024 }

}우리의 구현은 시계열 라이브러리와 OFA (GPT4T)를 코드 기반으로 조정하고 우리의 목적으로 광범위하게 수정했습니다. 구현 및 관련 리소스를 공유해 주신 저자에게 감사드립니다.