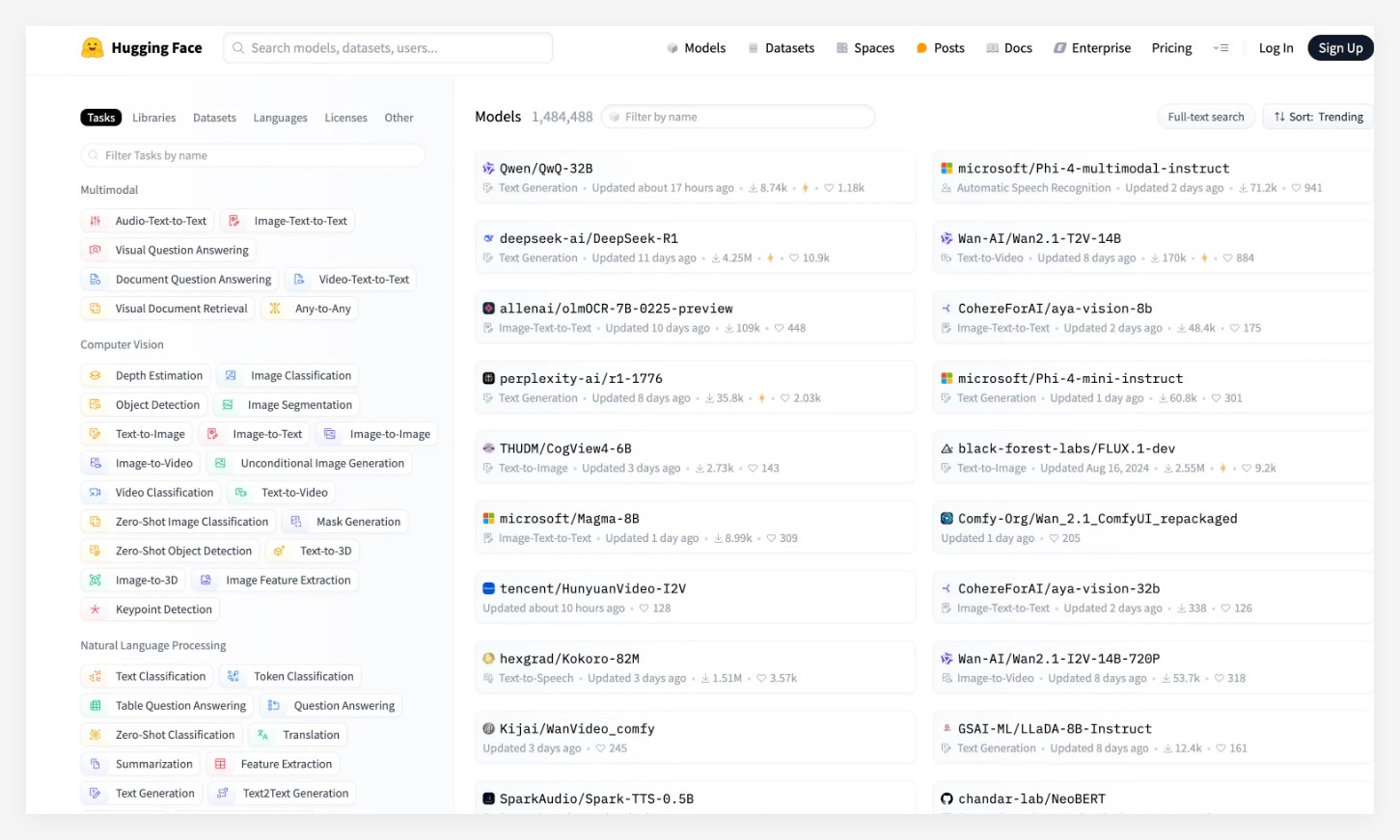

В последнем обновлении Huggingface, крупнейшего в мире сообщества с открытым исходным кодом в мире Alibaba недавно запустила модель вывода Tongyi Qianwen QWQ-32B, успешно выиграв первое место в списке Big Model. Эта модель привлекло широкое внимание после ее выпуска, превзойдя известные модели, такие как Microsoft PHI-4 и Deepseek-R1, и продемонстрировал сильную производительность.

Модель QWQ-32B сделала качественный скачок в математике, обработке кода и общих возможностях, особенно ее небольшом количестве параметров, что делает ее общую производительность сопоставимой с показателями DeepSeek-R1. Кроме того, проектирование этой модели позволяет пользователям реализовать локальное развертывание на графических картах потребителей, что значительно снижает стоимость приложения модели. Этот прорыв предоставляет большему количеству пользователей более удобный и экономичный выбор приложений для искусственного интеллекта.

Среди множества авторитетных тестов модель QWQ-32B показала очень хорошо, почти полностью превзойдя O1-Mini OpenAI и сравнимая с производительностью DeepSeek-R1. Особенно в оценке AIME24, набор для математических способностей и LiveCodeBench, оценки QWQ-32B сравнимы с DeepSeek-R1, намного опережая O1-Mini и ее модель дистилляции R1 того же размера.

В настоящее время модель QWQ-32B была открыта на таких платформах, как сообщество Modai, HuggingFace и GitHub, на основе протокола Loose Apache2.0. Любой может скачать и развернуть его на местном уровне бесплатно. В то же время пользователи также могут напрямую позвонить в службу API модели через платформу Alibaba Cloud Bailian.

Ключевые моменты: модель QWQ-32B занимает первое место в списке HuggingFace, превосходя несколько известных моделей. Эта модель достигает прорывов в затратах на производительность и применения и поддерживает локальное развертывание видеокарт потребительского уровня. Отличная производительность в нескольких тестах, сравнимая с самой сильной моделью Deepseek-R1.