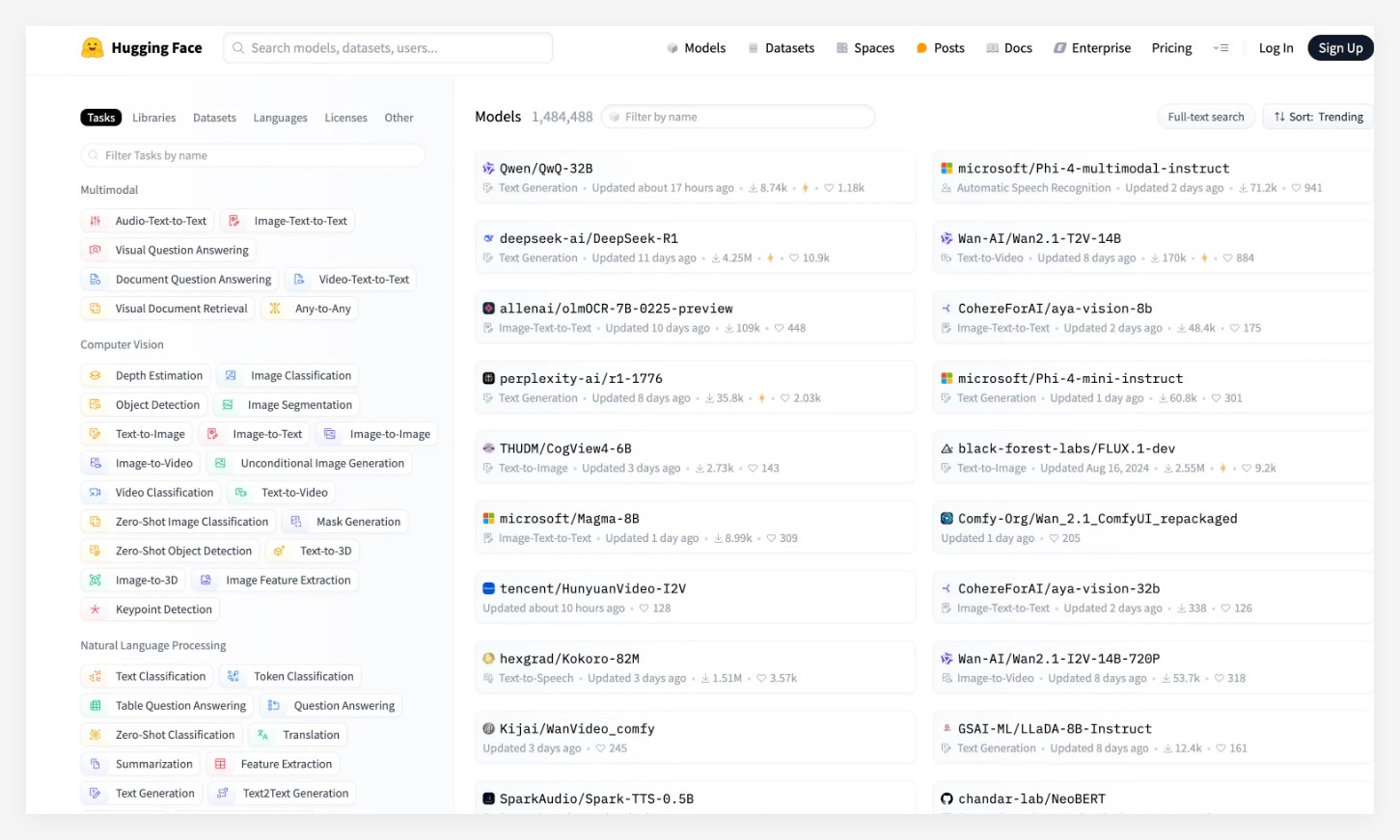

세계 최대의 AI 오픈 소스 커뮤니티 인 Huggingf 이 모델은 출시 후 광범위한 관심을 끌었으며 Microsoft의 PHI-4 및 DeepSeek-R1과 같은 잘 알려진 모델을 능가하고 강력한 성능을 보여줍니다.

QWQ-32B 모델은 수학, 코드 처리 및 일반 기능, 특히 적은 수의 매개 변수에서 질적 도약을 만들었으며, 이는 전체 성능을 DeepSeek-R1과 비교할 수있게합니다. 또한이 모델의 디자인을 통해 사용자는 소비자 그래픽 카드에 로컬 배포를 구현하여 모델 응용 프로그램 비용을 크게 줄일 수 있습니다. 이 획기적인 획기적인 사용자는보다 편리하고 경제적 인 AI 응용 프로그램 선택을 제공합니다.

여러 권위있는 벤치 마크 중에서 QWQ-32B 모델은 매우 잘 수행되어 OpenAI의 O1-MINI를 거의 완전히 능가했으며 DeepSeek-R1의 성능과 비슷했습니다. 특히 수학 능력 및 LiveCodeBench에 대한 AIME24 평가 세트에서 QWQ-32B 점수는 O1-MINI 및 동일한 크기의 R1 증류 모델보다 훨씬 앞서 DeepSeek-R1과 비슷합니다.

현재 QWQ-32B 모델은 Loose Apache2.0 프로토콜을 기반으로 Modai Community, Huggingface 및 Github와 같은 플랫폼에서 공개되었습니다. 누구나 로컬로 무료로 다운로드하여 배포 할 수 있습니다. 동시에, 사용자는 Alibaba Cloud Bailian 플랫폼을 통해 모델 API 서비스를 직접 호출 할 수 있습니다.

핵심 사항 : QWQ-32B 모델은 Huggingface 목록에서 1 위를 차지하여 여러 잘 알려진 모델을 능가합니다. 이 모델은 성능 및 응용 프로그램 비용의 돌파구를 달성하고 소비자 등급 그래픽 카드의 로컬 배치를 지원합니다. 가장 강력한 모델 DeepSeek-R1과 비교할 수있는 여러 벤치 마크에서 우수한 성능.