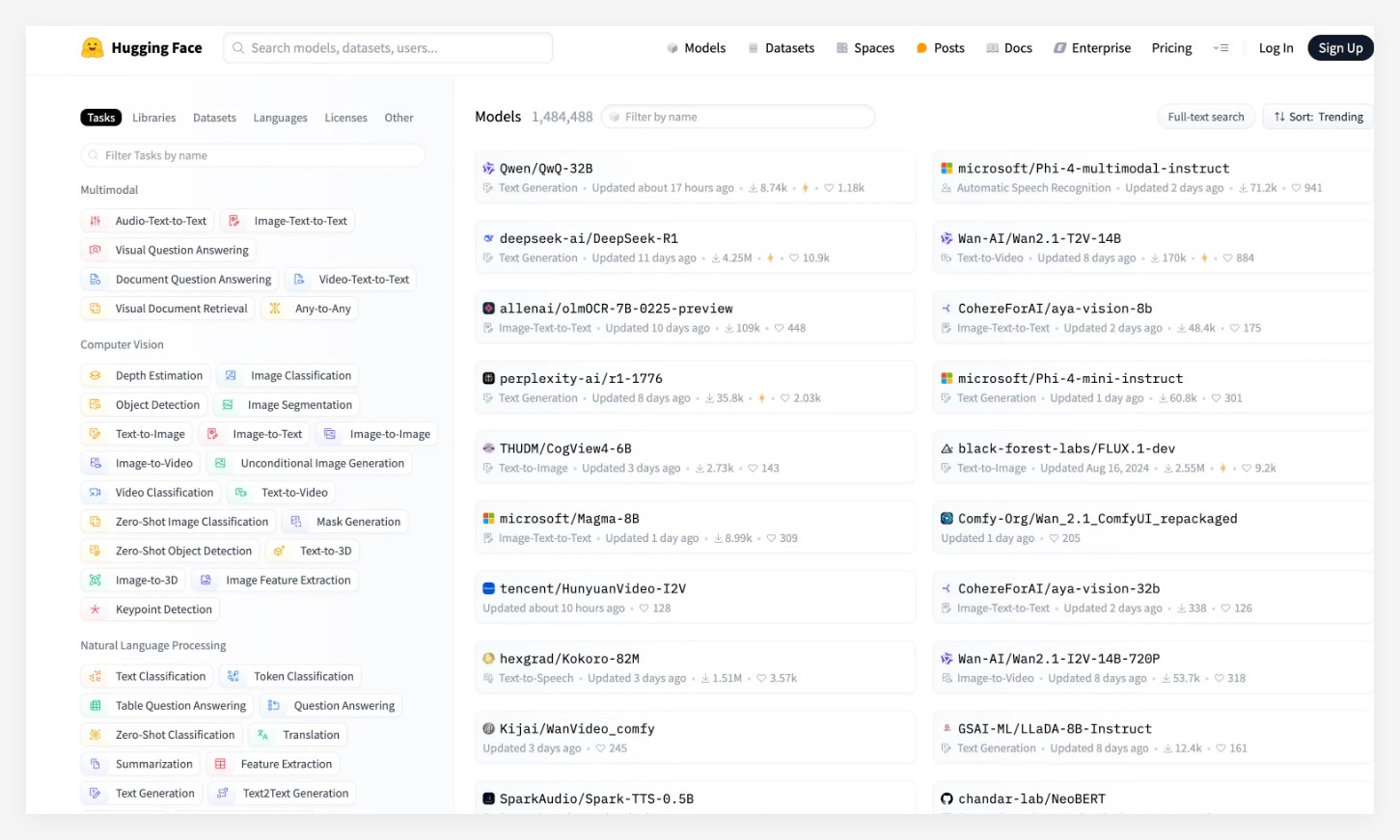

Na atualização mais recente do HuggingFace, a maior comunidade de código aberto da IA do mundo, o Alibaba lançou recentemente o modelo de inferência de Tongyi Qianwen QWQ-32B conquistou com sucesso o primeiro lugar na grande lista de modelos. Esse modelo atraiu atenção generalizada após seu lançamento, superando modelos conhecidos, como o PHI-4 da Microsoft e o Deepseek-R1 e mostrando um forte desempenho.

O modelo QWQ-32B deu um salto qualitativo em matemática, processamento de código e recursos gerais, especialmente seu pequeno número de parâmetros, o que torna seu desempenho geral comparável ao do Deepseek-R1. Além disso, o design deste modelo permite que os usuários implementem a implantação local em placas gráficas de consumo, reduzindo bastante o custo do aplicativo de modelo. Esse avanço fornece a mais usuários uma escolha de aplicativos de IA mais conveniente e econômica.

Entre os vários benchmarks autoritários, o modelo QWQ-32B teve um desempenho muito bom, quase completamente superando completamente o OpenAI da O1-mini e comparável ao desempenho do DeepSeek-R1. Especialmente no conjunto de avaliação AIME24 para habilidades matemáticas e LivecodeBench, as pontuações QWQ-32B são comparáveis a Deepseek-R1, muito à frente do O1-mini e seu modelo de destilação R1 do mesmo tamanho.

Atualmente, o modelo QWQ-32B foi de origem aberta em plataformas como a comunidade Modai, Huggingface e Github com base no protocolo solto do Apache2.0. Qualquer pessoa pode baixar e implantá -lo localmente gratuitamente. Ao mesmo tempo, os usuários também podem chamar diretamente o serviço de API de modelo através da plataforma Alibaba Cloud Bailian.

Pontos-chave: o modelo QWQ-32B ocupa o primeiro lugar na lista Huggingface, superando vários modelos conhecidos. Esse modelo alcança avanços nos custos de desempenho e aplicativos e suporta a implantação local de placas gráficas de nível de consumo. Excelente desempenho em vários benchmarks, comparável ao modelo mais forte Deepseek-R1.