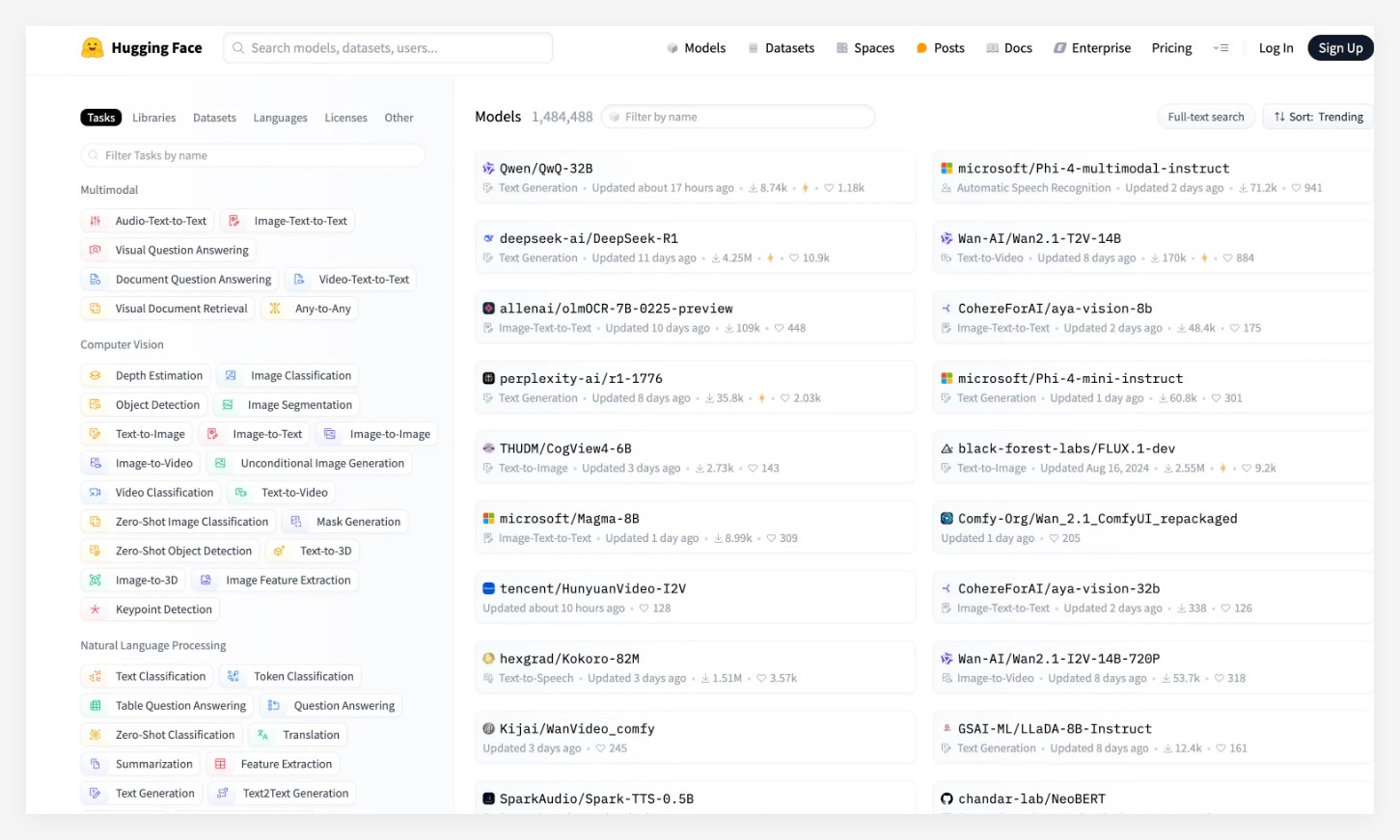

En la última actualización de Huggingface, la comunidad de código abierto de AI más grande del mundo, Alibaba lanzó recientemente el modelo de inferencia Tongyi Qianwen QWQ-32B con éxito ganó el primer lugar en la lista de modelos Big. Este modelo ha atraído una atención generalizada después de su lanzamiento, superando modelos conocidos como Phi-4 y DeepSeek-R1 de Microsoft, y mostrando un rendimiento fuerte.

El modelo QWQ-32B ha dado un salto cualitativo en matemáticas, procesamiento de código y capacidades generales, especialmente su pequeño número de parámetros, lo que hace que su rendimiento general sea comparable al de Deepseek-R1. Además, el diseño de este modelo permite a los usuarios implementar la implementación local en tarjetas de gráficos de consumo, reduciendo en gran medida el costo de la aplicación del modelo. Este avance proporciona a más usuarios una opción de aplicación AI más conveniente y económica.

Entre múltiples puntos de referencia autorizados, el modelo QWQ-32B funcionó muy bien, superando casi por completo el O1-Mini de OpenAI y comparable al rendimiento de Deepseek-R1. Especialmente en el conjunto de evaluación AIME24 para habilidades matemáticas y LivecodeBench, los puntajes QWQ-32B son comparables a Deepseek-R1, muy por delante del O1-Mini y su modelo de destilación R1 del mismo tamaño.

En la actualidad, el modelo QWQ-32B ha sido abierto en plataformas como Modai Community, Huggingface y GitHub basada en el protocolo APACHE2.0 suelto. Cualquiera puede descargarlo e implementarlo localmente de forma gratuita. Al mismo tiempo, los usuarios también pueden llamar directamente al servicio API del modelo a través de la plataforma Alibaba Cloud Bailian.

Puntos clave: el modelo QWQ-32B se ubica primero en la lista de Huggingface, superando varios modelos conocidos. Este modelo logra avances en los costos de rendimiento y aplicación, y admite la implementación local de tarjetas gráficas de grado de consumo. Excelente rendimiento en múltiples puntos de referencia, comparables al modelo más fuerte Deepseek-R1.