DeepSeek официально выпустила свои новейшие технологические достижения в первый день недели открытого исходного кода - Flashmla, многослойного ядра декодирования внимания, разработанного специально для графических процессоров Architecture Nvidia. Эта технология особенно оптимизирована для сценариев последовательности с переменной длиной, что может значительно улучшить производительность вывода крупных моделей и принести новые прорывы в область глубокого обучения.

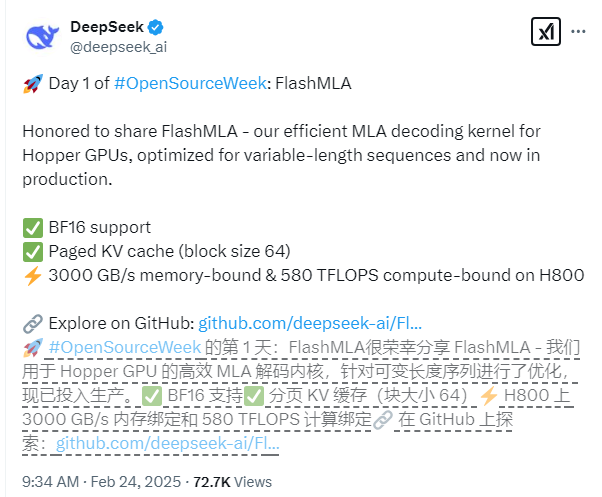

Основные технические функции FlashMLA включают в себя комплексную поддержку точности BF16 и использование системы кэша Pagge KV с размером блока 64 для достижения более точного управления памятью. С точки зрения производительности, основанной на платформе CUDA12.6, FlashMLA достигла замечательных результатов по H800SXM5GPU: в сценариях с ограниченными памятью скорость обработки достигает 3000 ГБ/с, а в сценариях, ограниченных вычислениями, уровень компьютерной мощности достигает 580TFLOPS.

Проект прошел проверку производственной среды и демонстрирует отличную стабильность. Команда разработчиков заявила, что дизайн FlashMLA позаимствовал превосходный опыт таких проектов, как Flashattention2 & 3 и Cutlass, и на этом основании он достиг инновационных прорывов, еще больше улучшив свои возможности применения в сложных сценариях.

Разработчики могут быстро развернуть FlashMLA с простыми командами установки. Просто выполните "Python setup.py install", чтобы завершить установку, а затем вы можете запустить тестовый скрипт "Python Tests/test_flash_mla.py", чтобы испытать его превосходную производительность.

Адрес с открытым исходным кодом: https://github.com/deepseek-ai/flashmla