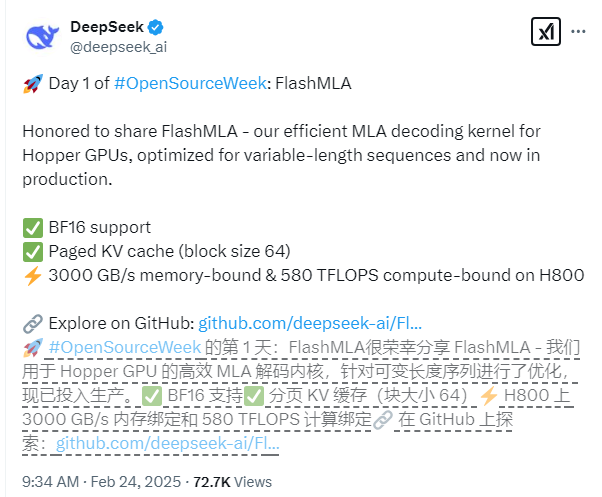

DeepSeek은 공식적으로 Open Source Week -Flashmla의 첫날 NVIDIA Hopper Architecture GPU를 위해 특별히 설계된 멀티 레이어주의 디코딩 커널 인 FlashMla에 공식적으로 발표했습니다. 이 기술은 가변 길이 시퀀스 시나리오에 특히 최적화되어 대형 모델의 추론 성능을 크게 향상시키고 딥 러닝 분야에 새로운 혁신을 가져올 수 있습니다.

FlashMLA의 핵심 기술 기능에는 BF16 정확도에 대한 포괄적 인 지원과 블록 크기가 64 인 PAGED KV 캐시 시스템 사용을 포함하여보다 정확한 메모리 관리를 달성합니다. 성능 측면에서 CUDA12.6 플랫폼을 기반으로 FlashMLA는 H800SXM5GPU에 대한 놀라운 결과를 얻었습니다. 메모리 제한 시나리오에서 처리 속도는 3000GB/s에 도달하며 컴퓨팅 제한 시나리오에서는 컴퓨팅 전력 수준이 580tflops만큼 높습니다.

이 프로젝트는 생산 환경 검증을 통과했으며 우수한 안정성을 보여줍니다. 개발 팀은 FlashMLA의 디자인은 FlashAttention2 & 3 및 Cutlass와 같은 프로젝트의 훌륭한 경험을 빌려 왔으며,이를 바탕으로 혁신적인 혁신을 달성하여 복잡한 시나리오에서 애플리케이션 기능을 더욱 향상 시켰다고 말했다.

개발자는 간단한 설치 명령으로 FlashMLA를 신속하게 배포 할 수 있습니다. "Python Setup.py 설치"를 실행하여 설치를 완료 한 다음 "Python Tests/Test_Flash_mla.py"테스트 스크립트를 실행하여 우수한 성능을 경험할 수 있습니다.

오픈 소스 주소 : https://github.com/deepseek-ai/flashmla