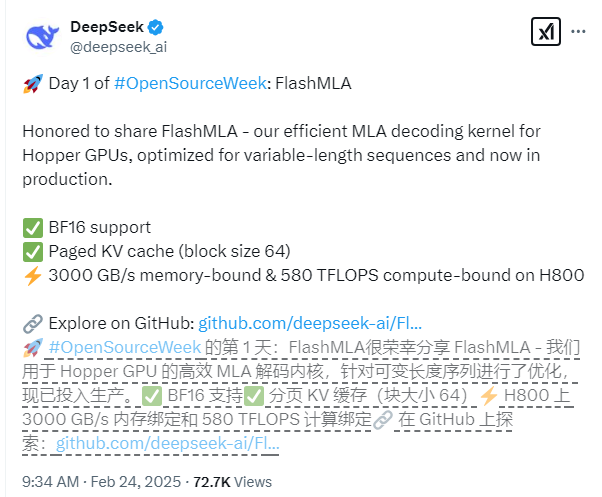

Deepseek veröffentlichte am ersten Tag der Open -Source -Woche offiziell seine neueste Technologieer Leistung - FlasMla, ein mehrschichtiger Aufmerksamkeitskernkernel, das speziell für die Nvidia Hopper Architecture GPUs entwickelt wurde. Diese Technologie ist besonders für Sequenzszenarien mit variabler Länge optimiert, die die Inferenzleistung großer Modelle erheblich verbessern und neue Durchbrüche auf das Gebiet des tiefen Lernens bringen können.

Die technischen Kernmerkmale von FlashMLA sind umfassende Unterstützung für die Genauigkeit von BF16 und die Verwendung eines PAGED KV -Cache -Systems mit einer Blockgröße von 64, um eine genauere Speicherverwaltung zu erzielen. In Bezug auf die Leistung hat FlashMLA basierend auf der CUDA12.6-Plattform bemerkenswerte Ergebnisse in der H800SXM5GPU erzielt: In Szenarien mit Speicherbeschränkungen erreicht die Verarbeitungsgeschwindigkeit 3000 GB/s, und in Computer-beschränkten Szenarien beträgt die Rechenleistungspegel von bis zu 580 Tflops.

Das Projekt hat die Produktionsumgebungsprüfung bestanden und zeigt eine hervorragende Stabilität. Das Entwicklungsteam sagte, dass das Design von FlashMLA die hervorragenden Erfahrungen von Projekten wie Flashattention2 & 3 und Cutlass entlehnt und auf dieser Grundlage innovative Durchbrüche erzielte und seine Anwendungsfähigkeiten in komplexen Szenarien weiter verbesserte.

Entwickler können FlashMLA schnell mit einfachen Installationsbefehlen bereitstellen. Führen Sie einfach "Python Setup.py Install" aus, um die Installation zu vervollständigen, und dann können Sie das Testskript "Python Tests/test_flash_mla.py" ausführen, um seine hervorragende Leistung zu erleben.

Open Source-Adresse: https://github.com/deepseek-ai/flashmla