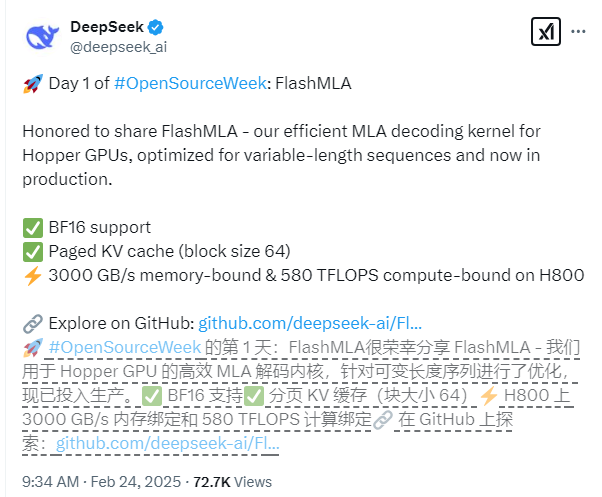

Deepseek a officiellement publié sa dernière réussite technologique le premier jour de la semaine open source - Flashmla, un noyau décodant de l'attention multicouche conçu spécifiquement pour les GPU de Nvidia Hopper Architecture. Cette technologie est particulièrement optimisée pour les scénarios de séquence de longueur variable, ce qui peut améliorer considérablement les performances d'inférence des grands modèles et apporter de nouvelles percées dans le domaine de l'apprentissage en profondeur.

Les caractéristiques techniques de base de FlashMLA incluent une prise en charge complète de la précision BF16 et l'utilisation d'un système de cache KV piqué avec une taille de bloc de 64 pour atteindre une gestion de mémoire plus précise. En termes de performances, sur la base de la plate-forme CUDA12.6, FlashMLA a obtenu des résultats remarquables sur le H800SXM5GPU: Dans les scénarios liés à la mémoire, la vitesse de traitement atteint 3000 Go / s et dans les scénarios à limite de calcul, le niveau de puissance de calcul est aussi élevé que 580 tflops.

Le projet a passé la vérification de l'environnement de production et démontre une excellente stabilité. L'équipe de développement a déclaré que la conception de Flashmla avait emprunté l'excellente expérience de projets tels que Flashattention2 et 3 et Cutlass, et sur cette base, il a réalisé des percées innovantes, améliorant encore ses capacités d'application dans des scénarios complexes.

Les développeurs peuvent rapidement déployer FlashMLA avec des commandes d'installation simples. Exécutez simplement "Python setup.py install" pour terminer l'installation, puis vous pouvez exécuter le script de test "Python tests / test_flash_mla.py" pour expérimenter ses excellentes performances.

Adresse open source: https://github.com/deepseek-ai/flashmla