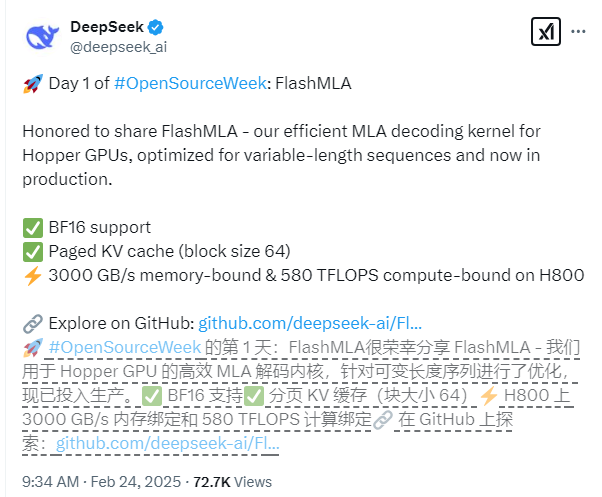

Deepseek secara resmi merilis pencapaian teknologi terbarunya pada hari pertama Open Source Week - FlashMLA, sebuah kernel decoding perhatian multi -lapisan yang dirancang khusus untuk GPU arsitektur NVIDIA HOPPER. Teknologi ini secara khusus dioptimalkan untuk skenario urutan panjang variabel, yang secara signifikan dapat meningkatkan kinerja inferensi model besar dan membawa terobosan baru ke bidang pembelajaran yang mendalam.

Fitur teknis inti dari FlashMLA termasuk dukungan komprehensif untuk akurasi BF16 dan penggunaan sistem cache KV paged dengan ukuran blok 64 untuk mencapai manajemen memori yang lebih tepat. Dalam hal kinerja, berdasarkan platform CUDA12.6, FlashMLA telah mencapai hasil yang luar biasa pada h800sxm5gpu: Dalam skenario yang dibatasi memori, kecepatan pemrosesan mencapai 3000GB/s, dan dalam skenario yang dibatasi komputasi, tingkat daya komputasi setinggi 580tflops.

Proyek ini telah melewati verifikasi lingkungan produksi dan menunjukkan stabilitas yang sangat baik. Tim pengembangan mengatakan bahwa desain FlashMLA meminjam pengalaman yang sangat baik dari proyek -proyek seperti Flashattention2 & 3 dan Cutlass, dan atas dasar ini, ia mencapai terobosan inovatif, lebih lanjut meningkatkan kemampuan aplikasinya dalam skenario yang kompleks.

Pengembang dapat dengan cepat menggunakan flashmla dengan perintah instalasi sederhana. Cukup jalankan "python setup.py install" untuk menyelesaikan instalasi, dan kemudian Anda dapat menjalankan skrip uji "tes python/test_flash_mla.py" untuk mengalami kinerjanya yang sangat baik.

Alamat Sumber Terbuka: https://github.com/deepseek-ai/flashmla