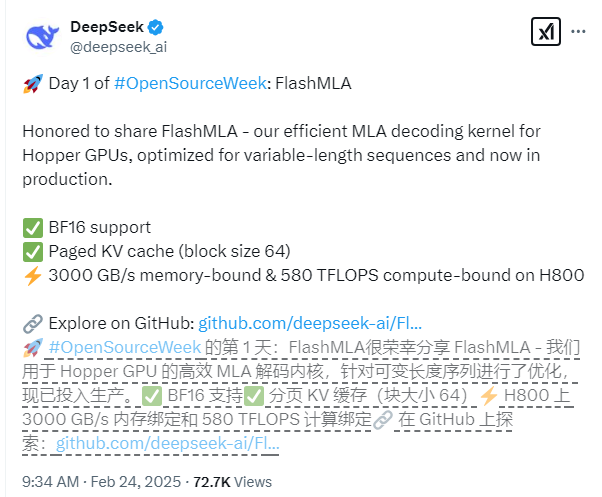

Deepseek lanzó oficialmente su último logro tecnológico el primer día de la Semana de Open Source: Flashmla, un núcleo de decodificación de atención de varias capas diseñado específicamente para las GPU de arquitectura de tolva nvidia. Esta tecnología está particularmente optimizada para escenarios de secuencia de longitud variable, lo que puede mejorar significativamente el rendimiento de inferencia de grandes modelos y llevar nuevos avances al campo del aprendizaje profundo.

Las características técnicas centrales de FlashMLA incluyen soporte integral para la precisión de BF16 y el uso de un sistema de caché KV paginado con un tamaño de bloque de 64 para lograr una gestión de memoria más precisa. En términos de rendimiento, basado en la plataforma CUDA12.6, FlashMLA ha logrado resultados notables en el H800SXM5GPU: en los escenarios limitados por la memoria, la velocidad de procesamiento alcanza 3000GB/s, y en escenarios de informática, el nivel de potencia informática es tan alto como 580tops.

El proyecto ha aprobado la verificación del entorno de producción y demuestra una excelente estabilidad. El equipo de desarrollo dijo que el diseño de Flashmla tomó prestada la excelente experiencia de proyectos como FlashAttion2 & 3 y Cutlass, y sobre esta base, logró avances innovadores, mejorando aún más sus capacidades de aplicación en escenarios complejos.

Los desarrolladores pueden implementar rápidamente FlashMLA con comandos de instalación simples. Simplemente ejecute "Python Setup.py Instalar" para completar la instalación, y luego puede ejecutar el script de prueba "Pruebas de Python/test_flash_mla.py" para experimentar su excelente rendimiento.

Dirección de código abierto: https://github.com/deepseek-ai/flashmla