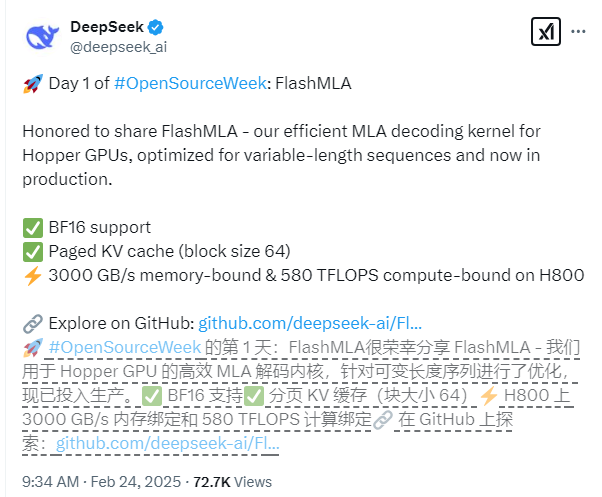

A Deepseek divulgou oficialmente sua mais recente conquista tecnológica no primeiro dia da semana de código aberto - FlashMla, um kernel de atenção de atenção de várias camadas projetado especificamente para as GPUs da Nvidia Hopper Architecture. Essa tecnologia é particularmente otimizada para cenários de sequência de comprimento variável, que podem melhorar significativamente o desempenho da inferência de modelos grandes e trazer novos avanços no campo da aprendizagem profunda.

Os principais recursos técnicos do FlashMLA incluem suporte abrangente para a precisão do BF16 e o uso de um sistema de cache KV paginado com um tamanho de bloco de 64 para obter um gerenciamento de memória mais preciso. Em termos de desempenho, com base na plataforma CUDA12.6, o FlashMLA alcançou resultados notáveis no H800SXM5GPU: em cenários com restrição de memória, a velocidade de processamento atinge 3000 GB/s e, em cenários com restrição de computação, o nível de potência da computação é de 580 fletas.

O projeto passou na verificação do ambiente de produção e demonstra excelente estabilidade. A equipe de desenvolvimento disse que o design do FlashMLA emprestou a excelente experiência de projetos como Flashattion2 e 3 e Cutlass e, nessa base, alcançou avanços inovadores, melhorando ainda mais seus recursos de aplicação em cenários complexos.

Os desenvolvedores podem implantar rapidamente flashmla com comandos de instalação simples. Basta executar "python setup.py install" para concluir a instalação e, em seguida, você pode executar o script de teste "Python tests/test_flash_mla.py" para experimentar seu excelente desempenho.

Endereço de código aberto: https://github.com/deepseek-ai/flashmla