DeepSeek выпустил крупный продукт во второй день недели с открытым исходным кодом - Deepep, первой библиотеки коммуникации EP с открытым исходным кодом для гибридной экспертной модели (MOE). Библиотека фокусируется на реализации оптимизации полного стека гибридных экспертных моделей в области обучения и вывода, предоставляя разработчикам эффективное и гибкое решение.

Deepep-это высокопроизводительная библиотека связи, разработанная для гибридных экспертных моделей (MOE) и экспертной параллели (EP). Его основная цель состоит в том, чтобы оптимизировать эффективность планирования и комбинации MOE, предоставляя сердечнику по графическим процессорам с высокой пропускной способностью и низкой задержкой. Этот дизайн заставляет Deepep хорошо работать при работе с крупномасштабными моделями, особенно в сценариях, где требуется эффективная связь.

Deepep не только поддерживает операции с низким уровнем определения, такие как FP8, но также идеально соответствует группе ограниченного алгоритма стробирования, предложенного в бумаге DeepSeek-V3. Deepep значительно повышает эффективность передачи данных, оптимизируя ядра для передачи полосы ширины асимметричных доменов, таких как передача данных из доменов NVLink в домены RDMA. Эти ядра хорошо работают в задачах обучения и вывода предварительного заполнения и имеют гибкий контроль над количеством потоковых процессоров, что еще больше улучшает масштабируемость системы.

Для чувствительных к задержке задач кодирования вывода Deepep предоставляет набор ядер с низкой задержкой, которые минимизируют задержку с использованием чистой технологии RDMA. Кроме того, Deepep также вводит метод перекрытия на основе коммуникации на основе крючков, который еще больше улучшает общую производительность системы, не занимая каких-либо ресурсов процессора потока.

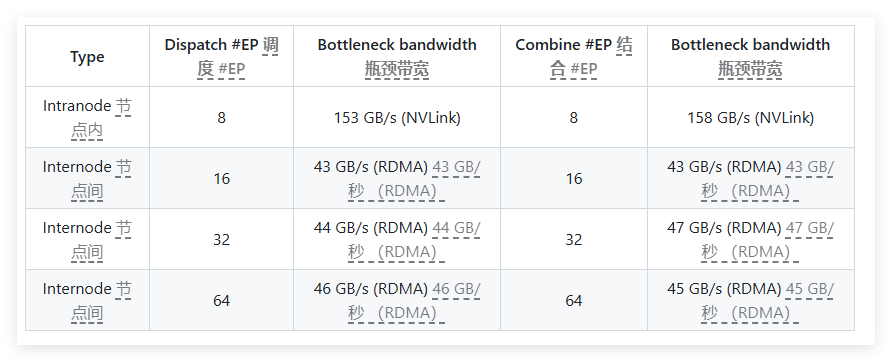

В тестировании производительности Deepep провели несколько тестов на сетевых картах H800 и CX7 Infiniband 400 ГБ/с RDMA. Результаты теста показывают, что нормальные ядра превосходно работают во внутренней и межсексуальной полосе пропускания, в то время как ядра с низкой задержкой достигают ожидаемых результатов как в задержке, так и в полосе пропускания. В частности, ядро с низкой задержкой имеет задержку всего 163 микросекунд и полоса пропускания до 46 ГБ/с при обработке 8 экспертов.

Deepep хорошо протестирован и в первую очередь совместим с сетью Infiniband, но также теоретически поддерживает работу на сходящейся Ethernet (ROCE). Чтобы убедиться, что различные типы трафика не мешают друг другу, рекомендуется выделить трафик в различных виртуальных каналах, чтобы обеспечить независимую работу нормальных и низких ядра.

В качестве эффективной библиотеки связи, разработанной для гибридных экспертных моделей, Deepep превосходит оптимизацию производительности, сокращении задержки и гибкой конфигурации. Будь то крупномасштабная модельная тренировка или чувствительные к задержке задачи вывода, Deepep предоставляет отличные решения.

Вход в проект: https://x.com/deepseek_ai/status/1894211757604049133

Ключевые моменты:

Deepep, разработанный для гибридных экспертных моделей, обеспечивает решения с высокой пропускной способностью и низкой задержкой.

Поддерживает различные операции с низким уровнем режима и оптимизирует производительность полосы пропускания для пересылки данных.

После тестирования и проверки Deepep совместим с сетью Infiniband и подходит для выделения и управления различными типами трафика.