Deepseek a publié un produit majeur le deuxième jour de la semaine open source - DeepP, la première bibliothèque de communication EP open source pour le modèle d'experts hybrides (MOE). La bibliothèque se concentre sur la mise en œuvre de l'optimisation complète des modèles d'experts hybrides dans la formation et l'inférence, offrant aux développeurs une solution efficace et flexible.

DeepPE est une bibliothèque de communication haute performance conçue pour les modèles d'experts hybrides (MOE) et le parallèle expert (EP). Son objectif principal est d'optimiser l'efficacité de la planification et de la combinaison du MOE en fournissant des noyaux de GPU de plusieurs à plusieurs avec un débit élevé et une faible latence. Cette conception permet de bien performer en profondeur lorsqu'il s'agit de modèles à grande échelle, en particulier dans les scénarios où une communication efficace est nécessaire.

DeepEP prend non seulement des opérations de faible précision telles que FP8, mais correspond également parfaitement à l'algorithme de déclenchement de limite de groupe proposé dans le papier Deepseek-V3. DeepEP améliore considérablement l'efficacité de transmission des données en optimisant les noyaux pour le transfert de bande passante des domaines asymétriques, tels que le transfert des données des domaines NVLink aux domaines RDMA. Ces noyaux fonctionnent bien dans les tâches de pré-remplissage de formation et d'inférence et ont un contrôle flexible sur le nombre de processeurs de flux, améliorant davantage l'évolutivité du système.

Pour les tâches de codage d'inférence sensible à la latence, DeepEP fournit un ensemble de grains de faible latence qui minimisent la latence en utilisant la technologie RDMA pure. En outre, DeepPe introduit également une méthode de chevauchement de composition de communication basée sur le crochet, qui améliore encore les performances globales du système sans occuper aucune ressource de processeur de flux.

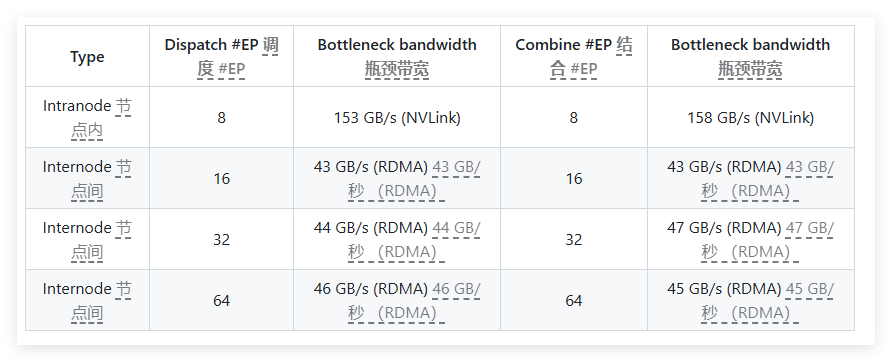

Dans les tests de performances, DeepPe a effectué plusieurs tests sur les cartes réseau RDMA H800 et CX7 Infiniband 400 Go / s. Les résultats des tests montrent que les noyaux normaux fonctionnent parfaitement dans la bande passante interne et à nœuds, tandis que les noyaux à faible latence obtiennent les résultats attendus à la fois dans la latence et la bande passante. Plus précisément, le noyau à faible latence a une latence de seulement 163 microsecondes et une bande passante allant jusqu'à 46 Go / s lors du traitement de 8 experts.

DeepEP est bien testé et est principalement compatible avec le réseau Infiniband, mais il prend également en charge théoriquement la course sur Convergent Ethernet (ROCE). Pour s'assurer que différents types de trafic n'interfèrent pas les uns avec les autres, il est recommandé d'isoler le trafic dans différents canaux virtuels pour assurer le fonctionnement indépendant des noyaux normaux et de faible latence.

En tant que bibliothèque de communication efficace conçue pour les modèles d'experts hybrides, DeepP excelle dans l'optimisation des performances, la réduction de la latence et la configuration flexible. Qu'il s'agisse d'une formation de modèles à grande échelle ou d'une tâche d'inférence sensible à la latence, DeepP propose d'excellentes solutions.

Entrée du projet: https://x.com/deepseek_ai/status/1894211757604049133

Points clés:

Conçu pour les modèles d'experts hybrides, DeepP propose des solutions de communication à haut débit et à faible latence.

Prend en charge une variété d'opérations à faible précision et optimise les performances de la bande passante du transfert de données.

Après les tests et la vérification, DeepP est compatible avec le réseau Infiniband et convient à l'isolement et à la gestion de différents types de trafic.