Deepseek veröffentlichte am zweiten Tag der Open -Source -Woche ein großes Produkt - Deepep, der ersten Open -Source -EP -Kommunikationsbibliothek für das Hybrid -Expertenmodell (MOE). Die Bibliothek konzentriert sich auf die Implementierung der vollständigen Optimierung von Hybrid-Expertenmodellen für Schulungen und Inferenz und bietet Entwicklern eine effiziente und flexible Lösung.

Deepep ist eine leistungsstarke Kommunikationsbibliothek für Hybrid-Expertenmodelle (MOE) und Experten parallel (EP). Das Kernziel ist es, die Effizienz der MOE-Planung und -kombination zu optimieren, indem viele zu viele GPU-Kerne mit hohem Durchsatz und geringer Latenz bereitgestellt werden. Dieses Design leistet die Leistung von Deepp, wenn es um große Modelle geht, insbesondere in Szenarien, in denen eine effiziente Kommunikation erforderlich ist.

Deepep unterstützt nicht nur Vorgänge wie FP8, sondern passt auch perfekt zum Gating-Algorithmus für Gruppengrenze überein, das in der Papier von Deepseek-V3 vorgeschlagen wurde. Deepep verbessert die Datenübertragungseffizienz signifikant durch Optimierung von Kerneln für die Bandbreitenweiterung asymmetrischer Domänen, z. B. die Weiterleitung von Daten von NVLink -Domänen an RDMA -Domänen. Diese Kerne arbeiten gut im Trainings- und Inferenzvorbereitungsaufgaben und haben eine flexible Kontrolle über die Anzahl der Stream-Prozessoren, wodurch die Skalierbarkeit des Systems weiter verbessert wird.

Für latenz-sensitive Inferenz-Codierungsaufgaben liefert Deepep eine Reihe von Kerneln mit niedriger Latenz, die die Latenz mithilfe der reinen RDMA-Technologie minimieren. Darüber hinaus führt Deepep auch eine überlappende Überlappungsmethode auf Hook-basierte Kommunikation ein, die die Gesamtleistung des Systems weiter verbessert, ohne dass Stream-Prozessor-Ressourcen besetzt sind.

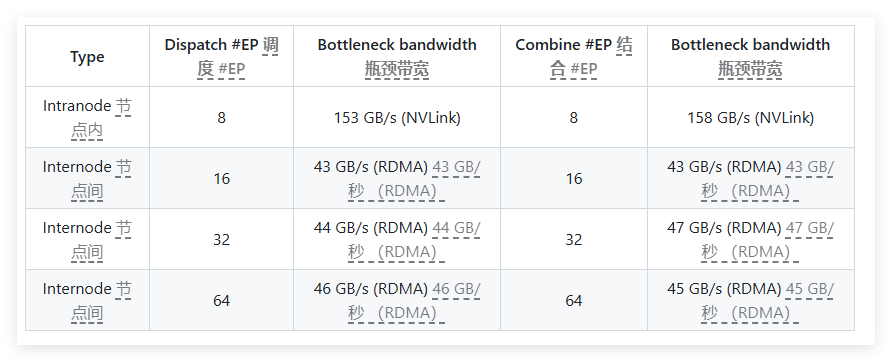

Bei Leistungstests führte Deepep mehrere Tests auf den H800- und CX7 Infiniband 400 GB/s RDMA -Netzwerkkarten durch. Die Testergebnisse zeigen, dass normale Kernel in der internen und kritischen Bandbreite hervorragend abschneiden, während Körner mit niedriger Latenz die erwarteten Ergebnisse sowohl in Latenz als auch in Bandbreite erzielen. Insbesondere hat der Kern mit niedriger Latenz eine Latenz von nur 163 Mikrosekunden und eine Bandbreite von bis zu 46 GB/s bei der Verarbeitung von 8 Experten.

Deepep ist gut getestet und ist in erster Linie mit dem Infiniband -Netzwerk kompatibel, unterstützt aber auch theoretisch das Laufen auf Convergent Ethernet (ROCE). Um sicherzustellen, dass sich unterschiedliche Verkehrstypen nicht stören, wird empfohlen, den Verkehr in verschiedenen virtuellen Kanälen zu isolieren, um den unabhängigen Betrieb normaler und niedriger Latenzkerne zu gewährleisten.

Als effiziente Kommunikationsbibliothek für Hybrid -Expertenmodelle zeichnet sich bei der Optimierung der Leistung, der Verringerung der Latenz und der flexiblen Konfiguration aus. Unabhängig davon, ob es sich um ein großflächiges Modelltraining oder eine latenz-sensitive Inferenzaufgabe handelt, bietet Deepep hervorragende Lösungen.

Projekteingang: https://x.com/deepseek_ai/status/1894211757604049133

Schlüsselpunkte:

Deepep wurde für Hybrid -Expertenmodelle entwickelt und bietet Kommunikationslösungen für hohe Durchsatz und Latenz.

Unterstützt eine Vielzahl von Vorgängen mit niedriger Präzision und optimiert die Bandbreitenleistung der Datenweiterleitung.

Nach dem Testen und Überprüfungen ist Deepep mit dem Infiniband -Netzwerk kompatibel und ist für die Isolation und Verwaltung verschiedener Verkehrstypen geeignet.