Deepseekは、Hybrid Expert Model(MOE)の最初のオープンソースEPコミュニケーションライブラリであるOpen Source Weekの2日目に主要な製品をリリースしました。ライブラリは、トレーニングと推論にハイブリッドエキスパートモデルのフルスタックの最適化を実装し、開発者に効率的で柔軟なソリューションを提供することに焦点を当てています。

Deepepは、ハイブリッドエキスパートモデル(MOE)およびエキスパートパラレル(EP)向けに設計された高性能通信ライブラリです。その中心的な目標は、MOEスケジューリングと組み合わせの効率を最適化することです。このデザインは、特に効率的なコミュニケーションが必要なシナリオで、大規模なモデルを扱うときにDeepepのパフォーマンスを高めることができます。

Deepepは、FP8などの低精度操作をサポートするだけでなく、DeepSeek-V3ペーパーで提案されているグループ制限ゲーティングアルゴリズムと完全に一致します。 DEEPEPは、NVLinkドメインからRDMAドメインへの転送データなど、非対称ドメインの帯域幅転送のカーネルを最適化することにより、データ送信効率を大幅に改善します。これらのコアは、トレーニングと推論の事前充填タスクでうまく機能し、ストリームプロセッサの数を柔軟に制御できるため、システムのスケーラビリティがさらに向上します。

遅延に敏感な推論コーディングタスクの場合、DeepEPは、純粋なRDMAテクノロジーを使用してレイテンシを最小限に抑える低遅延カーネルのセットを提供します。さらに、Deepepはフックベースの通信コンピューティングオーバーラップメソッドも導入し、ストリームプロセッサリソースを占有することなくシステムの全体的なパフォーマンスをさらに向上させます。

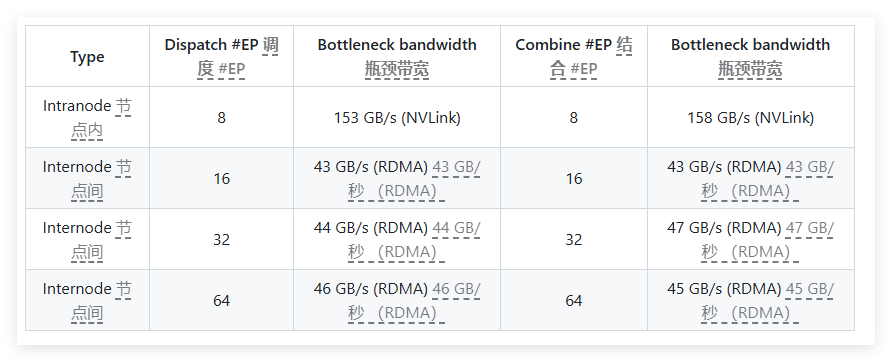

パフォーマンステストでは、DeepepはH800およびCX7 Infiniband 400GB/S RDMAネットワークカードで複数のテストを実施しました。テスト結果は、通常のカーネルが内部およびクロスノードの帯域幅で優れたパフォーマンスを発揮し、低遅延カーネルがレイテンシと帯域幅の両方で期待される結果を達成することを示しています。具体的には、低遅延コアのレイテンシーはわずか163マイクロ秒で、8人の専門家を処理すると最大46GB/sの帯域幅があります。

Deepepはよくテストされており、主にInfinibandネットワークと互換性がありますが、収束イーサネット(ROCE)でのランニングも理論的にはサポートしています。異なるトラフィックタイプが互いに干渉しないようにするには、異なる仮想チャネルでトラフィックを分離して、通常および低遅延のカーネルの独立した動作を確保することをお勧めします。

ハイブリッドエキスパートモデル向けに設計された効率的な通信ライブラリとして、DeepEPはパフォーマンスの最適化、レイテンシと柔軟な構成の削減に優れています。大規模なモデルトレーニングであろうと、レイテンシに敏感な推論タスクであろうと、DeepEPは優れたソリューションを提供します。

プロジェクトの入り口:https://x.com/deepseek_ai/status/1894211757604049133

キーポイント:

ハイブリッドエキスパートモデル向けに設計されたDeepEPは、高いスループットと低レイテンシの通信ソリューションを提供します。

さまざまな低精度操作をサポートし、データ転送の帯域幅のパフォーマンスを最適化します。

テストと検証後、DeepEPはInfinibandネットワークと互換性があり、さまざまなトラフィックタイプの分離と管理に適しています。