A Deepseek lançou um grande produto no segundo dia da semana de código aberto - DeepEp, a primeira biblioteca de comunicação EP de código aberto para o modelo de especialista híbrido (MOE). A biblioteca se concentra na implementação da otimização de pilhas completas de modelos especialistas em treinamento e inferência, proporcionando aos desenvolvedores uma solução eficiente e flexível.

O DeepEp é uma biblioteca de comunicação de alto desempenho projetada para modelos de especialistas híbridos (MOE) e paralelo especializado (EP). Seu objetivo principal é otimizar a eficiência da programação e combinação de MOE, fornecendo núcleos de GPU muitos para muitos com alta taxa de transferência e baixa latência. Esse design faz com que o DeepEp tenha um bom desempenho ao lidar com modelos em larga escala, especialmente em cenários em que a comunicação eficiente é necessária.

O DeePep não apenas suporta operações de baixa precisão, como o FP8, mas também corresponde perfeitamente ao algoritmo de bloqueio de limite do grupo proposto no papel Deepseek-V3. O DeePep melhora significativamente a eficiência da transmissão de dados, otimizando os kernels para encaminhamento de largura de banda de domínios assimétricos, como encaminhar dados dos domínios NVLink para domínios RDMA. Esses núcleos têm um bom desempenho nas tarefas de pré-preenchimento de treinamento e inferência e têm controle flexível sobre o número de processadores de fluxo, melhorando ainda mais a escalabilidade do sistema.

Para tarefas de codificação de inferência sensíveis à latência, o DeePep fornece um conjunto de kernels de baixa latência que minimizam a latência usando a tecnologia RDMA pura. Além disso, o DeePep também apresenta um método de sobreposição de computação em comunicação baseado em gancho, o que melhora ainda mais o desempenho geral do sistema sem ocupar nenhum recurso do processador de fluxo.

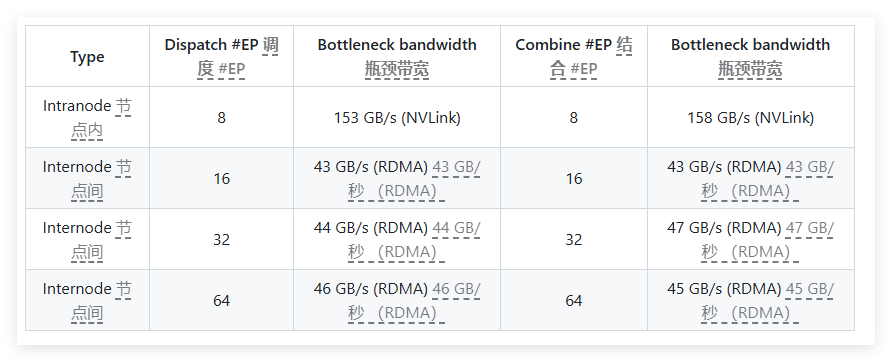

Nos testes de desempenho, o DeePep realizou vários testes nos cartões de rede RDMA H800 e CX7 Infiniband 400GB/S. Os resultados dos testes mostram que os núcleos normais têm desempenho excelentemente na largura de banda interna e cruzada, enquanto os núcleos de baixa latência atingem os resultados esperados na latência e na largura de banda. Especificamente, o núcleo de baixa latência possui uma latência de apenas 163 microssegundos e uma largura de banda de até 46 GB/s ao processar 8 especialistas.

O DeepEp é bem testado e é principalmente compatível com a rede InfiniBand, mas também suporta teoricamente a execução da Ethernet convergente (ROCE). Para garantir que diferentes tipos de tráfego não interfiram entre si, é recomendável isolar o tráfego em diferentes canais virtuais para garantir a operação independente dos kernels normais e de baixa latência.

Como uma biblioteca de comunicação eficiente projetada para modelos de especialistas híbridos, o DeepEp se destaca na otimização do desempenho, reduzindo a latência e a configuração flexível. Seja o treinamento de modelos em larga escala ou as tarefas de inferência sensível à latência, o DeepEp fornece excelentes soluções.

Entrada do projeto: https://x.com/deepseek_ai/status/1894211757604049133

Pontos -chave:

Projetado para modelos de especialistas híbridos, o DeePep fornece soluções de alto rendimento e baixa latência.

Suporta uma variedade de operações de baixa precisão e otimiza o desempenho da largura de banda do encaminhamento de dados.

Após o teste e a verificação, o DeepEP é compatível com a rede Infiniband e é adequado para isolamento e gerenciamento de diferentes tipos de tráfego.