Deepseek lanzó un producto importante en el segundo día de la Semana de Open Source: Deepep, la primera biblioteca de comunicación EP de código abierto para el Modelo de Experto Hybrid (MOE). La biblioteca se enfoca en implementar la optimización de la pila completa de modelos de expertos híbridos en capacitación e inferencia, proporcionando a los desarrolladores una solución eficiente y flexible.

Deepep es una biblioteca de comunicación de alto rendimiento diseñada para modelos de expertos híbridos (MOE) y experto paralelo (EP). Su objetivo principal es optimizar la eficiencia de la programación y combinación de MOE al proporcionar núcleos de GPU de muchos a muchos con alto rendimiento y baja latencia. Este diseño hace que Deepep funcione bien cuando se trata de modelos a gran escala, especialmente en escenarios en los que se requiere una comunicación eficiente.

DeepEP no solo admite operaciones de baja precisión, como FP8, sino que también coincide perfectamente con el algoritmo de activación de límite de grupo propuesto en el artículo Deepseek-V3. DeepEP mejora significativamente la eficiencia de la transmisión de datos mediante la optimización de los núcleos para el reenvío del ancho de banda de dominios asimétricos, como el reenvío de datos de los dominios NVLINK a los dominios RDMA. Estos núcleos funcionan bien en tareas de repleto de entrenamiento e inferencia y tienen un control flexible sobre el número de procesadores de flujo, mejorando aún más la escalabilidad del sistema.

Para las tareas de codificación de inferencia sensible a la latencia, DeepEP proporciona un conjunto de núcleos de baja latencia que minimizan la latencia utilizando la tecnología RDMA pura. Además, DeepEP también introduce un método de superposición que computa por comunicación basada en el gancho, que mejora aún más el rendimiento general del sistema sin ocupar los recursos del procesador de flujo.

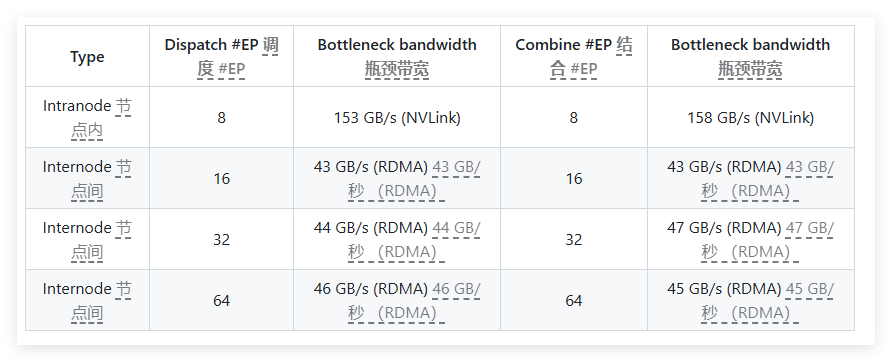

En las pruebas de rendimiento, DeepEP realizó múltiples pruebas en las tarjetas de red RDMA H800 y CX7 infiniband 400GB/S. Los resultados de las pruebas muestran que los núcleos normales se desempeñan excelentemente en el ancho de banda interno y de nodos cruzados, mientras que los núcleos de baja latencia logran los resultados esperados en latencia y ancho de banda. Específicamente, el núcleo de baja latencia tiene una latencia de solo 163 microsegundos y un ancho de banda de hasta 46 GB/s cuando procesan 8 expertos.

Deepep está bien probado y es principalmente compatible con la red Infiniband, pero también es teoría admite la ejecución de Ethernet Convergente (ROCE). Para garantizar que diferentes tipos de tráfico no interfieran entre sí, se recomienda aislar el tráfico en diferentes canales virtuales para garantizar un funcionamiento independiente de núcleos normales y de baja latencia.

Como una biblioteca de comunicación eficiente diseñada para modelos de expertos híbridos, Deepep sobresale para optimizar el rendimiento, reducir la latencia y la configuración flexible. Ya sea que se trate de capacitación modelo a gran escala o tareas de inferencia sensible a la latencia, DeepEP proporciona excelentes soluciones.

Entrada del proyecto: https://x.com/deepseek_ai/status/1894211757604049133

Puntos clave:

Diseñado para modelos de expertos híbridos, DeepEP proporciona soluciones de comunicación de alto rendimiento y baja latencia.

Admite una variedad de operaciones de baja precisión y optimiza el rendimiento de ancho de banda del reenvío de datos.

Después de la prueba y la verificación, DeepEP es compatible con la red Infiniband y es adecuada para el aislamiento y la gestión de diferentes tipos de tráfico.