Deepseek merilis produk utama pada hari kedua Open Source Week - Deepep, perpustakaan komunikasi EP open source pertama untuk model ahli hybrid (MOE). Perpustakaan ini berfokus pada penerapan optimalisasi full-stack dari model ahli hibrida dalam pelatihan dan inferensi, memberikan solusi yang efisien dan fleksibel kepada pengembang.

Deepep adalah perpustakaan komunikasi berkinerja tinggi yang dirancang untuk model ahli hybrid (MOE) dan Paralel Paralel (EP). Tujuan intinya adalah untuk mengoptimalkan efisiensi penjadwalan dan kombinasi MOE dengan menyediakan inti GPU banyak-ke-banyak dengan throughput tinggi dan latensi rendah. Desain ini membuat DeepEP berkinerja baik ketika berhadapan dengan model skala besar, terutama dalam skenario di mana komunikasi yang efisien diperlukan.

Deepep tidak hanya mendukung operasi presisi rendah seperti FP8, tetapi juga sangat cocok dengan algoritma Gating Limit Gating yang diusulkan dalam kertas Deepseek-V3. Deepep secara signifikan meningkatkan efisiensi transmisi data dengan mengoptimalkan kernel untuk penerusan bandwidth domain asimetris, seperti meneruskan data dari domain NVLink ke domain RDMA. Inti ini berkinerja baik dalam tugas pelatihan dan inferensi pra-pengisian dan memiliki kontrol yang fleksibel atas jumlah prosesor aliran, lebih lanjut meningkatkan skalabilitas sistem.

Untuk tugas pengkodean inferensi-sensitif latensi, DeepEp menyediakan satu set kernel latensi rendah yang meminimalkan latensi menggunakan teknologi RDMA murni. Selain itu, DeepEp juga memperkenalkan metode tumpang tindih komputasi komunikasi berbasis kait, yang selanjutnya meningkatkan kinerja keseluruhan sistem tanpa menempati sumber daya prosesor aliran apa pun.

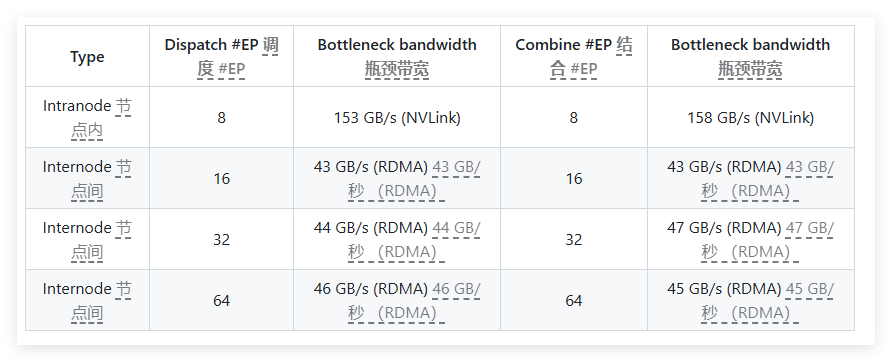

Dalam pengujian kinerja, Deepep melakukan beberapa tes pada kartu jaringan H800 dan CX7 Infiniband 400GB/s RDMA. Hasil tes menunjukkan bahwa kernel normal berkinerja sangat baik dalam bandwidth internal dan lintas-simpul, sementara kernel latensi rendah mencapai hasil yang diharapkan baik dalam latensi dan bandwidth. Secara khusus, inti latensi rendah memiliki latensi hanya 163 mikrodetik dan bandwidth hingga 46GB/s saat memproses 8 ahli.

Deepep diuji dengan baik dan terutama kompatibel dengan jaringan Infiniband, tetapi secara teoritis juga mendukung berjalan pada Ethernet konvergen (ROCE). Untuk memastikan bahwa jenis lalu lintas yang berbeda tidak saling mengganggu, disarankan untuk mengisolasi lalu lintas di saluran virtual yang berbeda untuk memastikan operasi independen kernel normal dan latensi rendah.

Sebagai pustaka komunikasi yang efisien yang dirancang untuk model ahli hybrid, Deepep unggul dalam mengoptimalkan kinerja, mengurangi latensi dan konfigurasi yang fleksibel. Apakah itu pelatihan model skala besar atau tugas inferensi yang peka terhadap latensi, DeepEp memberikan solusi yang sangat baik.

Pintu masuk proyek: https://x.com/deepseek_ai/status/1894211757604049133

Poin -Poin Kunci:

Dirancang untuk model ahli hibrida, DeepEp memberikan solusi komunikasi latar dan latensi rendah.

Mendukung berbagai operasi presisi rendah dan mengoptimalkan kinerja bandwidth dari penerusan data.

Setelah pengujian dan verifikasi, DeepEp kompatibel dengan jaringan Infiniband dan cocok untuk isolasi dan pengelolaan jenis lalu lintas yang berbeda.