? Принято в ICASSP 2023

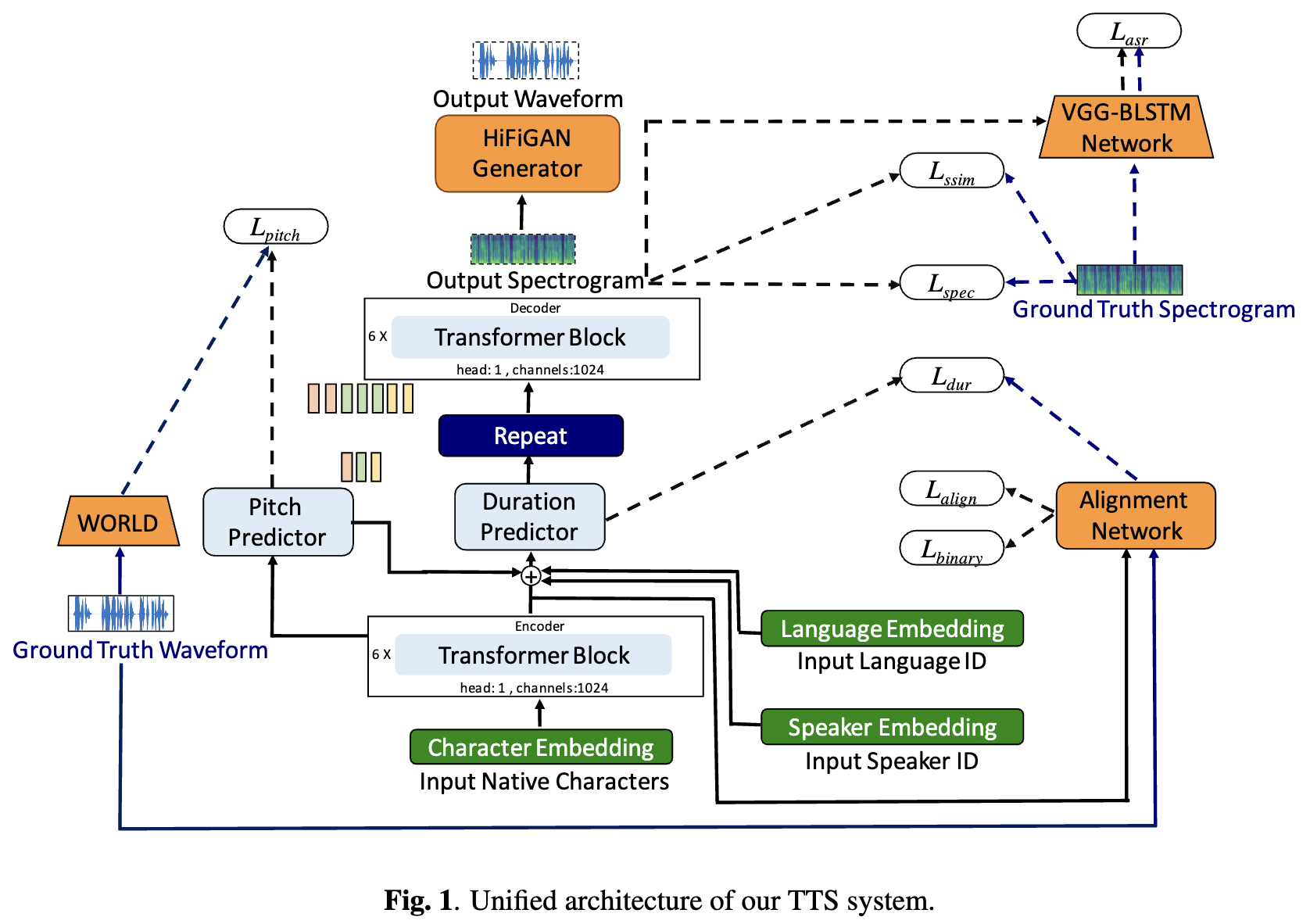

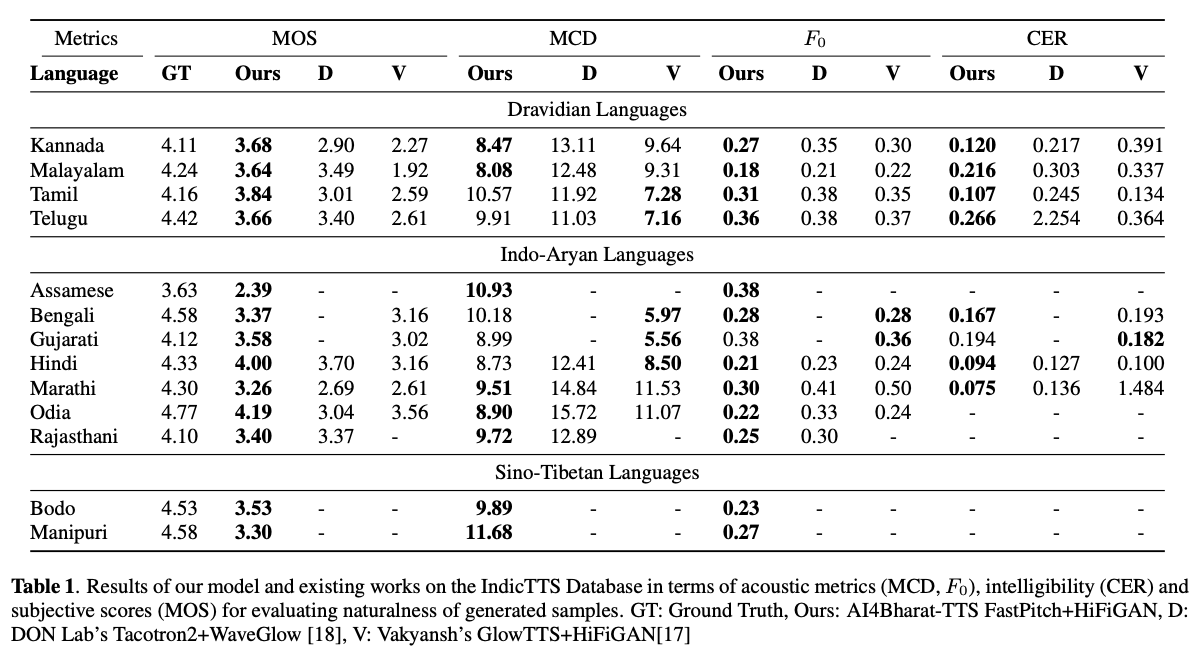

Системы глубокого обучения, основанные на текстовом до речи (TTS), быстро развивались с достижениями в области модельной архитектуры, методологий обучения и обобщения между носителями и языками. Тем не менее, эти достижения не были тщательно исследованы для синтеза речи индийского языка. Такое исследование является вычислительно дорогостоящим, учитывая количество и разнообразие индийских языков, относительно более низкую доступность ресурсов и разнообразный набор достижений в нейронных ТТ, которые остаются непроверенными. В этой статье мы оцениваем выбор акустических моделей, вокадеров, дополнительных функций потерь, графиков обучения, а также разнообразия динамиков и языка для дравидийских и индоарийских языков. Основываясь на этом, мы идентифицируем одноязычные модели с FastPitch и Hifi-Gan V1, обученными совместно с ораторами мужского и женского пола, чтобы выполнить лучшее. С помощью этой настройки мы обучаем и оцениваем модели TTS для 13 языков и находим наши модели значительно улучшить существующие модели на всех языках, измеренные по средним оценкам мнений. Мы с открытым исходным кодом всех моделей на платформе Бхашини.

TL; DR: Мы с открытым исходным кодом SOTA Text-To Speek Models для 13 индийских языков: ассамезе, бенгали, Бодо, Гуджарати, Хинди, Каннада, Малаялам, Манипури, Маратхи, Одиа, Раджастхани, Тамильский и Телугу .

Авторы: Гокул Картик Кумар*, Правин С.В., Пратюш Кумар, Митеш М. Хапра, Картик Нандакумар

[Arxiv Preprint] [Audio Samples] [Попробуйте это вживую] [Видео]

# 1. Create environment

sudo apt-get install libsndfile1-dev

conda create -n tts-env

conda activate tts-env

# 2. Setup PyTorch

pip3 install -U torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113

# 3. Setup Trainer

git clone https://github.com/gokulkarthik/Trainer

cd Trainer

pip3 install -e .[all]

cd ..

[or]

cp Trainer/trainer/logging/wandb_logger.py to the local Trainer installation # fixed wandb logger

cp Trainer/trainer/trainer.py to the local Trainer installation # fixed model.module.test_log and added code to log epoch

add `gpus = [str(gpu) for gpu in gpus]` in line 53 of trainer/distribute.py

# 4. Setup TTS

git clone https://github.com/gokulkarthik/TTS

cd TTS

pip3 install -e .[all]

cd ..

[or]

cp TTS/TTS/bin/synthesize.py to the local TTS installation # added multiple output support for TTS.bin.synthesis

# 5. Install other requirements

> pip3 install -r requirements.txt

sh run.shОбученная модель веса и файлы конфигурации могут быть загружены по этой ссылке.

python3 -m TTS.bin.synthesize --text <TEXT>

--model_path <LANG>/fastpitch/best_model.pth

--config_path <LANG>/config.json

--vocoder_path <LANG>/hifigan/best_model.pth

--vocoder_config_path <LANG>/hifigan/config.json

--out_path <OUT_PATH>

Ссылка на код: https://github.com/coqui-ai/tts