? Aceito no ICASSP 2023

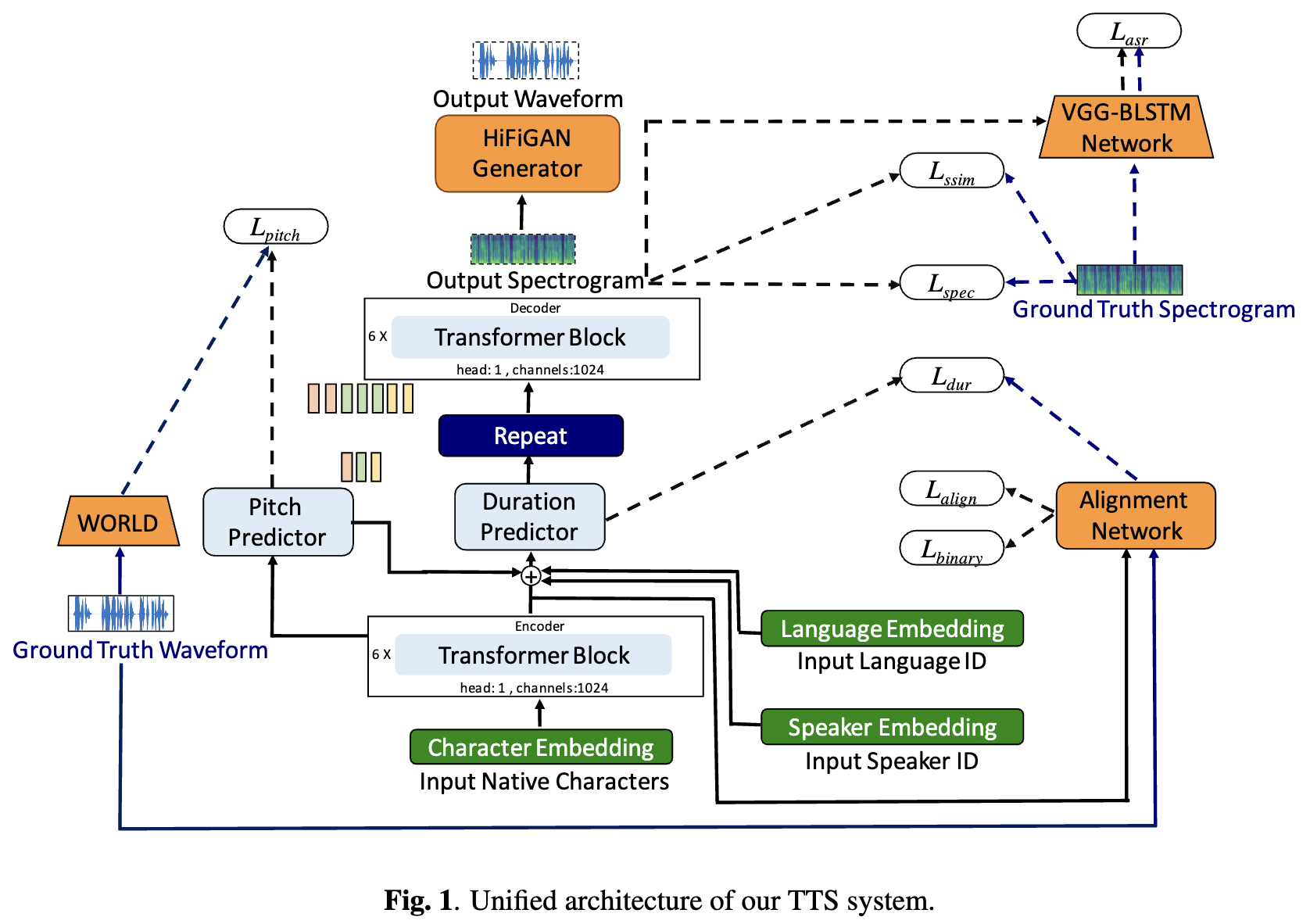

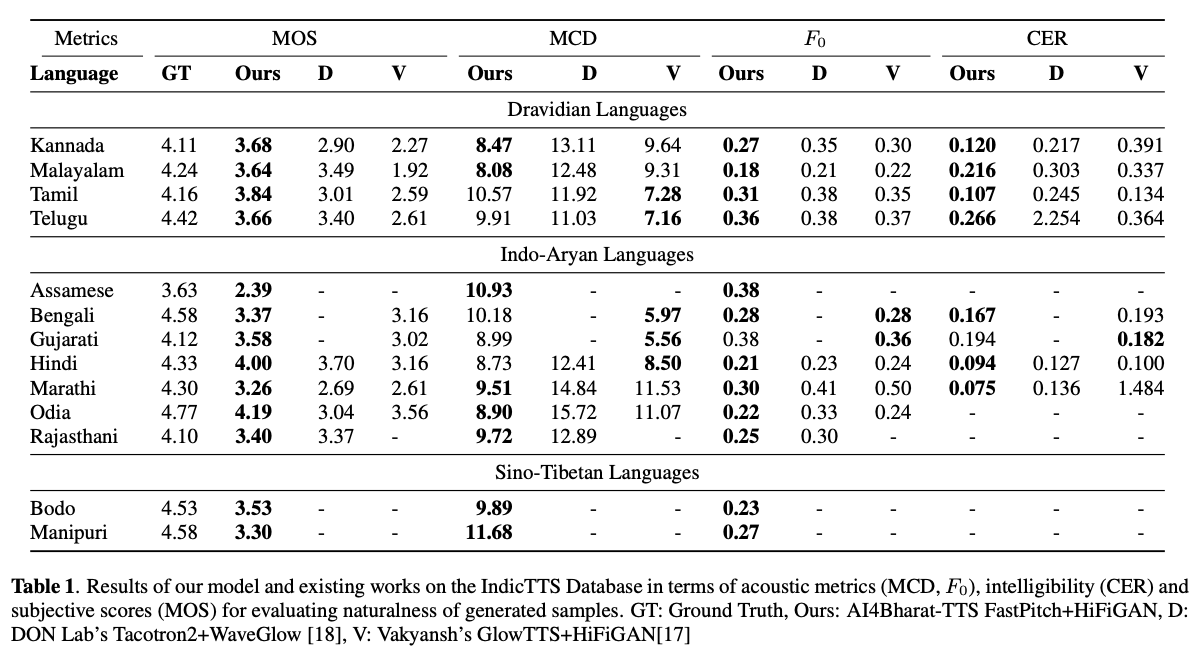

Os sistemas de text-speal-to (TTS) baseados em aprendizado profundo estão evoluindo rapidamente com os avanços nas arquiteturas de modelos, metodologias de treinamento e generalização entre falantes e idiomas. No entanto, esses avanços não foram minuciosamente investigados para a síntese de fala da língua indiana. Essa investigação é computacionalmente cara, dado o número e a diversidade dos idiomas indianos, a disponibilidade de recursos relativamente menor e o conjunto diversificado de avanços no TTS neural que permanecem não testados. Neste artigo, avaliamos a escolha de modelos acústicos, vocoders, funções de perda suplementar, cronogramas de treinamento e diversidade de palestrantes e idiomas para idiomas dravidianos e indo-arianos. Com base nisso, identificamos modelos monolíngues com FastPitch e Hifi-Gan V1, treinados em conjunto em falantes masculinos e femininos para executar o melhor. Com essa configuração, treinamos e avaliamos modelos TTS para 13 idiomas e encontramos nossos modelos para melhorar significativamente os modelos existentes em todos os idiomas, medidos pelas pontuações médias de opinião. Nós de código aberto todos os modelos na plataforma Bhashini.

TL; DR: Modelos de texto em fala de código aberto para 13 idiomas indianos: Assamese, Bengali, Bodo, Gujarati, Hindi, Kannada, Malayalam, Manipuri, Marathi, Odia, Rajasthani, Tamil e Telugu .

Autores: Gokul Karthik Kumar*, Praveen SV*, Pratyush Kumar, Mitesh M. Khapra, Karthik Nandakumar

[ARXIV PRINT] [AUDIO Amosples] [Experimente ao vivo] [Vídeo]

# 1. Create environment

sudo apt-get install libsndfile1-dev

conda create -n tts-env

conda activate tts-env

# 2. Setup PyTorch

pip3 install -U torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113

# 3. Setup Trainer

git clone https://github.com/gokulkarthik/Trainer

cd Trainer

pip3 install -e .[all]

cd ..

[or]

cp Trainer/trainer/logging/wandb_logger.py to the local Trainer installation # fixed wandb logger

cp Trainer/trainer/trainer.py to the local Trainer installation # fixed model.module.test_log and added code to log epoch

add `gpus = [str(gpu) for gpu in gpus]` in line 53 of trainer/distribute.py

# 4. Setup TTS

git clone https://github.com/gokulkarthik/TTS

cd TTS

pip3 install -e .[all]

cd ..

[or]

cp TTS/TTS/bin/synthesize.py to the local TTS installation # added multiple output support for TTS.bin.synthesis

# 5. Install other requirements

> pip3 install -r requirements.txt

sh run.shOs arquivos treinados de peso e configuração do modelo podem ser baixados neste link.

python3 -m TTS.bin.synthesize --text <TEXT>

--model_path <LANG>/fastpitch/best_model.pth

--config_path <LANG>/config.json

--vocoder_path <LANG>/hifigan/best_model.pth

--vocoder_config_path <LANG>/hifigan/config.json

--out_path <OUT_PATH>

Referência de código: https://github.com/coqui-ai/tts